原文以AI can be sexist and racist — it’s time to make it fair为标题发布在2018年7月18日的《自然》评论上

原文作者:斯坦福大学生物医学数据科学教授James Zou & 斯坦福大学科学史教授 Londa Schiebinger

谷歌翻译(Google Translate)在将西班牙语新闻翻译成英语时,通常将提及女人的句子翻译成“他说”或“他写道”。尼康相机中用来提醒拍照者照片中的人有没有眨眼的软件有时会把亚洲人识别为总在眨眼。单词嵌入——一个用来处理和分析大量自然语言数据的流行算法——会把欧裔美国人的姓名识别为“正面”词汇,而非裔美国人的姓名识别为“负面”词汇。

在这三个例子之外,人们还发现了其他很多人工智能(AI)系统性地歧视特定人群的例证。

决策偏见并不是AI独有的问题。但正如很多研究者所指出的,由于AI的应用范围越来越大,因此解决AI偏见至关重要。考虑到该问题普遍存在,我们需要一种系统性的解决方案。我们在此列举出几种可能的策略。

偏差数据

无论是在学术界还是产业界,计算机科学家都会在训练出更复杂的算法时获得赞誉(从发表论文到媒体报道均是如此)。相对而言,很少有人关注数据是如何收集、处理和归类的。

导致AI产生偏见的一个主要因素是训练数据。大多数机器学习任务都是使用大型、带标注的数据集来训练的。例如,用于图像分类的深度神经网络通常会使用ImageNet进行训练,其中包含了逾1400万张带标签的图片。在自然语言处理领域,标准算法是在包含上亿单词的语料库上训练的。

研究者们通常会利用网站来构建数据集,例如使用特定的单词搜索Google Images或Google News,或是从维基百科等易于访问的信息网站上收集。这些数据集接下来会被标注出来——通常由研究生来做,或是通过Amazon Mechanical Turk这样的众包网站进行。

这种方法会在无意中产生出包含了性别、种族和文化偏见的数据集。

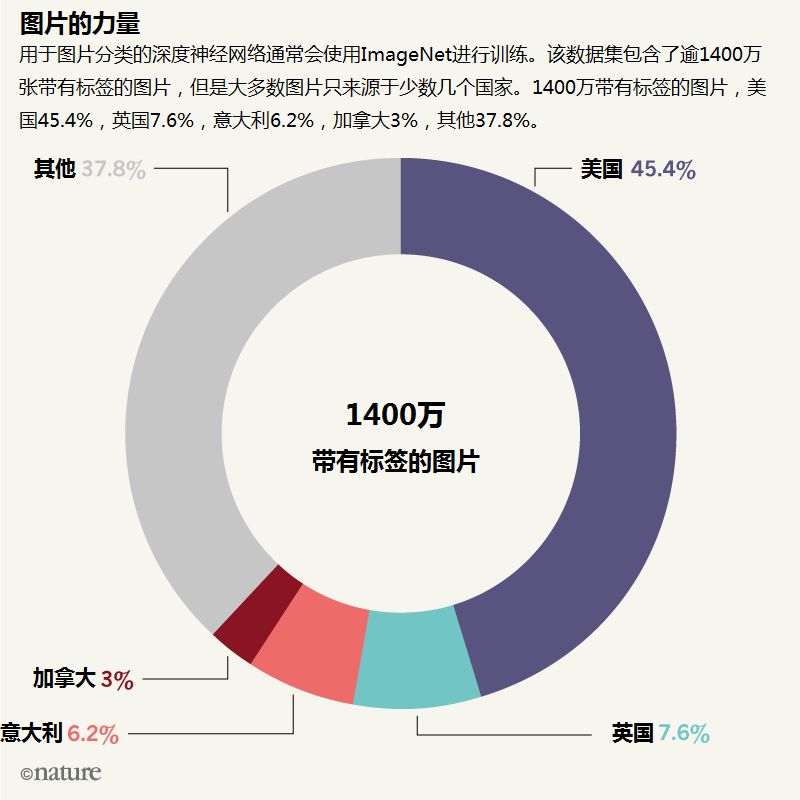

通常来说,会有一些人群被代表过度,而另一些则代表不足。ImageNet推动了计算机视觉研究,但是其中超过45%的数据来源于美国,而美国人只占世界人口的4%。相反,中国和印度加起来只占其中3%的数据量,而两国人口却占了世界人口的36%。

缺乏地理上的多样性可以在一定程度上解释为什么计算机视觉算法会把传统的身着白色婚纱的美国新娘标注为“新娘”、“礼服”、“女人”、“婚礼”,而北印度新娘的照片则会被标注为“表演”和“戏服”。

在医学领域,机器学习的预测特别易受训练数据集中的偏差影响,因为医学数据的生成和标注都相当昂贵。去年,研究者使用深度学习从照片中识别皮肤癌。他们在包含129450张图片的数据集上训练了算法模型,其中60%是从Google Images上搜索而来。但是其中只有5%的图片是深肤色人群,而算法没有在深肤色人群中测试过。因此该算法在不同人群中的表现可能相差极大。

偏见的另一个来源可以归于算法本身。

一个常见的机器学习程序会试图最大化训练数据集的整体预测准确率。如果训练数据集中某类人群的出现频率远多于另一人群,那么程序就会为占比更多的人群进行优化,这样才可以提高整体的准确率。计算机科学家会在“测试”集上评估算法效果,而这些通常也是原始训练数据集的一个随机子集,因此很可能会包含同样的偏见。

有缺陷的算法还会造成恶性循环,使偏见越发严重。举例来说,使用统计方法训练出的系统,例如谷歌翻译,会默认使用男性代词。这是因为英语语料库中男性代词对女性代词的比例为2:1。

更糟糕的是,每次翻译程序默认翻出“他说”,就会提高网络上男性代词的比例——这可能会逆转女性在性别平等上所获得的艰难胜利。事实上,20世纪60年代男性代词对女性代词的比例高达4:1,之后因为大规模的社会变革才降到了目前的水平。

调整均衡

数据集中的偏差常常体现出了制度基础和社会权力关系中更深、更隐蔽的不均衡。例如,维基百科看起来是一个丰富多样的数据源,但是该网站上的人物页面里只有18%是女性。在关于女性的条目中,链接到男性条目的数量远比男性条目链接到女性条目的数量要多,因此搜索引擎里就更容易找到关于男性的条目。女性条目里还包含了更多的伴侣和家人信息。

因此,在构建训练数据集时必须进行技术处理,并将社会因素纳入考虑范围。具体说来,应当采取措施来保证数据集的多元化,不要使特定人群代表不足。也就是说,我们不能局限于方便的分类方式——“女人/男人”,“黑人/白人”等——这些分类方式无法捕捉到性别和种族认同上的复杂性。

一些研究者已经开始这方面的工作了。计算机科学家最近发现,商用的面部识别系统在识别深肤色女性时,错误率达到了35%,而识别浅肤色男性的错误率仅为0.8%。为了解决这一问题,研究者们筛选出了一组新的图片数据集,其中包含了在性别和种族上保持均衡的1270人。用这组数据重新训练已有的面部分类算法并调整参数后,应可以提高其准确率。

为了帮助鉴定偏见的来源,我们推荐标注者使用标准化的元数据,系统性地标注训练数据集的内容。有几个研究组已经在着手设计“数据表”,表中包含了机器学习数据集的元数据和“营养成分标签”。

所有训练数据集均应说明数据是如何收集和标注的。如果数据包含了有关人类的信息,那就应当提供地域、性别、种族和其他人口学信息(见下图“图片的力量”)。如果数据标注是通过众包完成的,那就应当列出众包参与者的基本信息,另外也要列出向众包参与者提出的确切要求或指示。

数据管理者应当尽可能提供与数据相关的描述语的精确定义。例如,在犯罪司法数据里,阐明训练算法模型时所使用的“犯罪”类型可以使该模型的应用范围和解释方式更加明确。

算法内的修正

很多期刊已经要求作者为实验数据提供这类信息,作为发表的先决条件。例如,《自然》要求作者将DNA微阵列数据上传至可公开访问的数据库Gene Expression Omnibus,而该数据库则要求作者提交实验方法的元数据。

我们推荐机器学习会议(如国际机器学习大会)的组织者也将标准化的元数据作为论文提交和同行评议的关键组成。OpenML这样的数据库和Kaggle这样的AI竞赛平台也应当如此。

最后,计算机科学家应努力开发能够稳定应对数据中的人类偏见的算法。

目前人们已经在进行各种各样的尝试。其中一种是加入约束条件,本质上说就是调整机器学习模型,让它能够在不同的群体和相似的个体间均有相似的表现。类似的一种尝试是修改学习算法,减少它对种族、性别、收入等敏感特性以及所有与此相关的信息的依赖。

这种新出现的除偏尝试确实有潜力,但是需要在现实场景中进一步调整和评估。

但是,这类解决方案还有一个尚无解法的问题,即种族、性别和其他相关信息必须被准确记录下来。除非数据集中已经包含了适当的分类,否则就很难确定到底应该给模型加入什么样的约束条件,或是做出什么样的修正。这种解决方案还要求算法设计者预先决定好他们想要避免的偏见类型。

一个互补的方法是使用机器学习本身来识别并量化算法和数据中的偏见。这叫做“执行AI审计”,其中“审计员”是一个会系统性监测原始机器学习模型的算法,以便识别模型和训练数据集中的偏见。

例如,我们最近的工作是使用单词嵌入这一流行的机器学习算法来量化美国历史上的刻板印象。单词嵌入会把每个英语单词映射到空间中的一个点(即一个几何向量),向量之间的距离表示单词间语义上的相似性。它可以捕捉到类比关系:例如“男人”对“国王”正如“女人”对“女王”。

我们开发了一个算法——AI审计员——来查询其他性别相关的类比关系。最后发现了“男人”对“医生”正如“女人”对“护士”;或是“男人”对“程序员”正如“女人”对“家庭主妇”的关系。

一旦审计员发现了单词嵌入和原始文本中的刻板印象,就有可能通过修改单词向量的位置来减少偏见。更重要的是,识别出刻板印象的发展趋势之后,在历史文本上训练的算法就可以相应除偏。

例如,我们对Google Books中1910-1990年每十年一组的美国文章进行了嵌入,由此发现了对亚裔美国人令人震惊的态度转变。1910年,他们被描述为“怪物”和“野蛮人”,到了1990年就变成了“拘谨”和“敏感”——最大的变化发生在二战之后和上世纪80年代的移民潮时期。

正确的事

当计算机科学家、伦理学家、社会科学家等人努力提高数据和AI的公平性时,我们所有人都应该思考“公平”到底应该指什么。数据是应当表现现有的世界,还是应当表现大多数人所追求的世界?

又比如,用来评估应聘者的AI工具是应当评价应聘者是否有能力,还是应聘者是否能融入工作环境?应该让谁来决定哪种“公平”才是更为优先的?

为了解决这些问题,以及评估训练数据集和算法在更大范围内的影响,机器学习的研究者应当去和社会科学家以及人文、性别、医学、环境和法律领域的专家合作。

现在已有各方在努力促成这类合作,例如我们在斯坦福大学参与的“以人为本的人工智能”项目。这种合作必须从本科生开始。学生在学习算法的时候,就应该在社会大背景下考察AI。

计算机、程序和进程塑造了我们的态度、行为和文化。AI正在改变我们的经济和社会,改变我们交流的方式,改变我们的行政和政治。不平等在我们的社会中积疾已久,不能让AI在不经意间延续甚至恶化这一问题了。

Nature|doi:10.1038/d41586-018-05707-8

本文由施普林格·自然上海办公室负责翻译。中文内容仅供参考,一切内容以英文原版为准。

阅读英文原文:https://www.nature.com/articles/d41586-018-05707-8

声明:本文来自Nature自然科研,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。