随着人工智能技术的兴起对该领域的研究也日益加深,其应用也早已融入到很多领域并成为其不可分割的一部分。目前来讲,人工智能已经涵盖数学、计算机科学等多个学科的知识,并且对每个方向都有详细的技术探讨过程。已呈现星星之火、燎原之势。但是人工智能技术是一把“双刃剑”,在给我们生活带来便利之时,也会带来相关的问题。目前安全方面的问题最受关注,本文从其基本概念和内涵出发,主要结合一些案例来分析目前人工智能技术存在的安全风险并在最后提出相关建议。

人工智能基本概念

1956年,美国达特茅斯会议上,科学家约翰麦卡锡首次提出“人工智能”(Artificial Intelligence, AI)一词。人工智能是让机器的行为看起来像人所表现出的智能行为一样的技术。在人工智能概念提出时,科学家主要确定了智能的判别标准和研究目标,而没有回答智能的具体内涵。

之后,诸多知名学者都对人工智能内涵提出了自己的见解,反映人工智能的基本思想和基本内容:研究如何应用计算机模拟人类智能行为的基本理论、方法和技术。但是,由于人工智能概念不断演进,目前未形成统一定义。

人工智能安全内涵

人工智能安全的内涵一方面包括人工智能在安全领域的应用,如人工智能在越来越多的行业辅助或替代人类。另一方面是人工智能自身的安全问题,是本文的着眼点。如何促进人工智能的应用更加安全和道德一直是人类长期思考和不断深化的命题。现阶段的人工智能技术不成熟性会导致诸多安全风险。例如:一辆自动驾驶汽车必须在撞一个老人和撞一个孩子之间做出抉择时,它会怎么选择?其背后的原因何在?它在做出选择时会更看重哪些因素?它能够自圆其说吗?这只是数学运算的结果,在人类看来是不可解释的。除此之外,数据的强依赖性和人为的恶意应用都属于技术不成熟性带来的安全风险;再者,不光人工智能系统需要安全性,其他的系统也需要安全性。利用人工智能去攻击其他系统,探测其他系统的漏洞,这种行为可能会给网络空间和国家社会带来安全风险[1]。

因此,人工智能安全内涵包含[2]:降低人工智能技术不成熟性带来的安全风险,同时利用人工智能构建安全防护系统,减少人为恶意应用带来的危害。

人工智能安全风险分析

在分析之前,我们首先来简单的介绍一下人工智能的应用。由于人工智能具有突出的数据分析、知识提取、自主学习等优点,被广泛应用在网络防护、数据管理、信息审查、智能安防、金融风控以及舆情监测等方面。在这些方面,往往存在若干安全风险,常见风险如下:

1.框架安全风险

近些年来,我们熟知的深度学习框架TensorFlow、Caffe等,及其依赖库被多次发现存在安全漏洞,这些漏洞可被攻击者利用,引发系统安全问题。

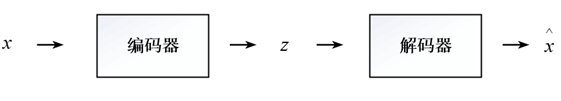

以生成模型(Generative Models)举例[3],其原本的工作原理为:输入x经过编码器映射到低维表示z,再经过解码器映射回高维重建x,用表示。如下图所示:

被攻击后就可能出现以下情况:假设输入为7,经过攻击者攻击过的网络,输出就可能是8。如下图所示:

除此之外,人工智能可能被利用来编写计算机病毒、木马,原来的恶意脚本都是通过人手工编写,人工智能技术可以使这些流程自动化,并通过插入对抗性样本,绕过安全检测[4];同样,人工智能技术还可以自动化地生成智能僵尸网络[5],这些网络可以规模化、自动化地对其他系统进行攻击,而不需要等待僵尸网络控制者的命令,大大加剧了网络攻击的破坏程度。

2.数据安全风险

攻击者可以通过网络的内部参数逆向获取网络训练的数据集[6];人工智能技术还会加强数据挖掘的能力,这加大了隐私泄露的风险,例如2018年3月的Facebook数据泄露事件。

3.算法安全风险

对于深度学习网络目标函数定义的不准确、不合理或者不正确也可能会导致错误甚至伤害性的结果。错误的目标函数、计算成本太高的目标函数、表达能力有限的网络都可能使网络产生错误的结果。例如,2018年3月,Uber自动驾驶汽车因机器视觉系统未及时识别路上突然出现的行人,导致与行人相撞,导致行人死亡的事故。

算法存在偏见与人工智能的不可解释性也是一个重大的问题。之前美国利用人工智能算法预测犯罪的人,名单暴露,其中许多无辜的人被冤枉,并且被冤枉的人中大多数为黑人,并且对于决策算法中系统为什么做出这样的决策,即使它的开发者也无法给出合理的解释。

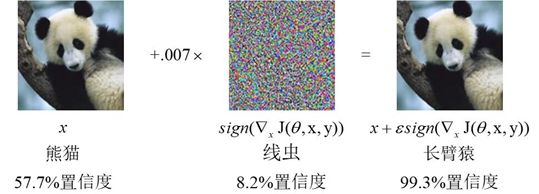

对抗性样本的出现也会使算法出现误判的情况,如下图中加入少量的噪声,AI便将熊猫以很高的置信度识别成长臂猿。

4.信息安全风险

只要有足够的训练数据,人工智能就可以制作虚假的信息,用于不法活动。例如AI换脸技术DeepFakes,还有前段时间出现的DeepNude。一些不法分子利用虚假的语音与视频来实施诈骗。目前谷歌发明的聊天机器人在与人进行电话聊天时,已经完全能骗过人类。

5.社会安全风险

这也是目前最热、最有争议的一个方面。首先,人工智能在不久的将来会取代很多岗位上的工人,这点从目前发展趋势来看是正确的,如果相关岗位人员不学习新技能,就会面临失业,从而导致严重的社会问题。其次,人工智能系统可能会危及到人类安全,由于技术的不成熟性,自动汽车、无人机等的一些行为可能会导致人类自身的安全风险。2016年特斯拉汽车无法识别蓝天背景下的白色货车导致车祸;2018年Uber自动汽车因机器视觉系统未及时识别路上突然出现的行人,与行人相撞导致行人死亡;近些年来,我国出现多起无人机干扰导致航班紧急迫降事件。另外,人工智能产品可能会对现有社会道德伦理产生冲击[7]:

1)AI算法存在偏见会影响社会的公平正义,例如,为何黑人的犯罪率就大大高于白人?

2)AI算法缺乏道德规范约束,只知道达到自己的目的,而不会考虑别人的权益。例如,一些APP会利用人工智能系统根据用户最近的一些活动自动向用户发送短信推销产品、做广告,它无法保证其内容的真实性以及它的行为是否侵犯了用户的某些权益。

3) 假如人与人工智能出现类夫妻、父女等情感,将考问现代伦理规范。

6.国家安全风险

人工智能可用于影响公众意识形态。例如美国大选时,对候选人通过点对点的虚假新闻推送,影响公众意识形态来影响大选结果。人工智能还可用于构建新型军事力量,如2018年8月委内瑞拉总统在公开活动中受到了无人机炸弹的轰炸,这是全球利用人工智能产品进行恐怖活动的首例。

人工智能作为引领未来的战略性技术,已然成为了驱动社会各领域发展的重要引擎。然而,人工智能是一把“双刃剑”,需要加强对安全风险的研究和预防,推动其在安全领域的应用,力图在下一轮的人工智能发展浪潮中占得先机,赢得主动。为此,对于人工智能安全的发展有以下几点建议:

1.加强技术应用研究,提升网络空间安全防御能力

2.立法和技术研究并重,促进个人隐私安全管理

3.强化人工智能应用安全,规避人身安全风险

4.优化学科专业设置和在线培训,降低社会失业风险

5.加强国际交流,共同应对安全风险。

参考文献:

[1] Henry A. Kissinger. TheMetamorphosis.Technology[J],2019年8月刊.

[2]中国信息通信研究院.人工智能安全白皮书(2018年)[R].2018.

[3] Microsoft Research FacultySummit 2017 AI and Security[R].2017.

[4]Malwarebytes.当人工智能误入歧途:将科幻小说与现实分离[R].2019.

[5] Ben Dickson.The securitythreats of neural networks and deep learning algorithms[C].2018.

[6] Chiyuan Zhang.Understandingdeep learning requires rethinking generalization[C].2017.

[7]刘诗瑶.人工智能或许对法律规范、道德伦理等产生冲击[N].人民日报,2017-07-10.

作者:刘博超 葛仕明

声明:本文来自中国保密协会科学技术分会,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。