蚂蚁金服在CIKM 2018上的一篇论文《Heterogeneous Graph Neural Networks for Malicious Account Detection》(下一次介绍),作者包括刘子奇、陈超超、杨新星、周俊、李小龙、宋乐。该篇文章介绍了一种新的基于异构图的、面向恶意账户识别的图神经网络方法GEM ,这也是这也是世界上已知的第一个面向恶意账户检测的图神经网络方法。

本文提出了一种新的异构图神经网络分层注意力机制,涉及到节点级别和语义级别。这篇文章在方法上相比蚂蚁那篇文章是加入了attention机制,当然这已经是目前很多文章的日常套路了,但是写得比较详细,看起来比蚂蚁那篇要轻松一点,有兴趣的可以先看蚂蚁金服那篇文章再看本篇。

接下来,我们开始正文:

文章目录

ABSTRACT

KEYWORDS

INTRODUCTION

RELATED WORK

Graph Neural Network

Network Embedding

PRELIMINARY

THE PROPOSED MODEL

Node-level Attention

Semantic-level Attention

Analysis of the Proposed Model

EXPERIMENTS

Datasets

Baselines

论文地址

Heterogeneous Graph Attention Network:https://arxiv.org/pdf/1903.07293.pdf

ABSTRACT

深度学习最大的弱点是什么?

深度学习不能进行因果推理,而图模型(GNN)是其中的一种解决方案。

GNN在深度学习领域固然有非常强大的性能,但是,单纯的GNN模型应用在包含不同节点和边的HIN领域,并不能取得较好的效果。

但是我们有Attention机制,节点级别的Attention主要学习节点及其临近节点间的权重,语义级别的Attention是来学习基于不同meta-path的权重。将Attention、GNN与HIN结合可以很好地处理这类问题。

INTRODUCTION

真实世界中,许多重要的数据集都是以图或者网络的形式存在的,比如社交网络,知识图谱,蛋白质相互作用网,世界贸易网等等。

异质性是异质图的一个内在属性,即各种类型的节点和边。

例如,不同类型的节点具有不同的特征,它们的特征可能落在不同的特征空间中。以IMDB为例,演员的特征可能涉及性别、年龄和国籍。另一方面,电影的特点可能涉及情节和演员。如何处理如此复杂的结构信息,同时保存不同的特征信息是一个急需解决的问题。

这部分介绍了GNN、Attention mechanism、HIN等。由于HIN的复杂性,传统的GNN并不能直接应用于HIN中。这就需要新的方法来解决这个问题,论文提出了HAN模型(Heterogeneous graph Attention Network)。

RELATED WORK

Graph Neural Network

GNN在对图节点之间依赖关系进行建模的强大功能,使得与图分析相关的研究领域取得了突破。GCN相比能够更好地学习节点信息,同时兼顾网的结构信息和节点特征信息。GCN可以分为两类,分别是谱域和非谱域。谱方法用于谱表示的图中,非谱域方法直接在图上进行卷积,对空间上的近邻进行操作。

注意力机制最开始是在自然语言处理上取得了非常好的效果,在深度学习中有广泛的应用,self-attention、soft-attention等。也已经有很多基于图Attention的应用,但是都是同构图的数据。

Network Embedding

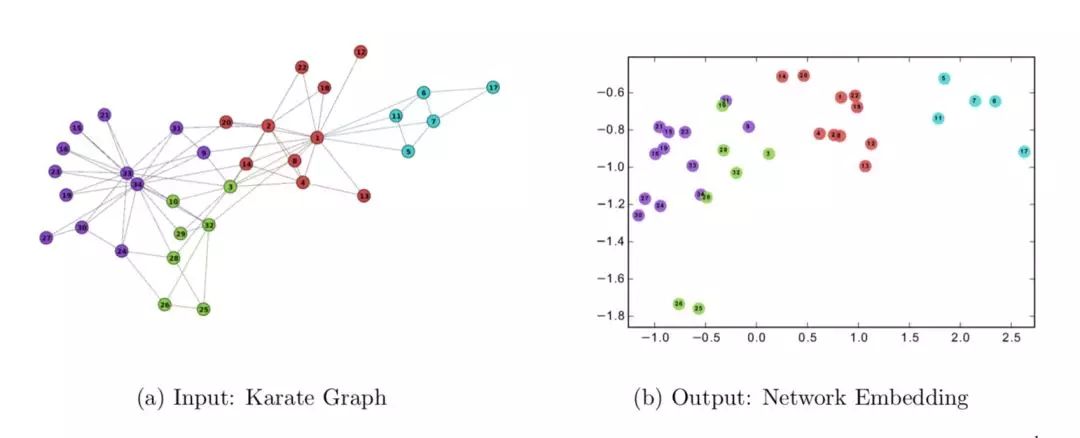

「网络嵌入方法(Network Embedding)旨在学习网络中节点的低维度潜在表示,所学习到的特征表示可以用作基于图的各种任务的特征,例如分类,聚类,链路预测和可视化。

由于信息网络可能包含数十亿个节点和边缘,因此在整个网络上执行复杂的推理过程可能会非常棘手。因此有人提出了用于解决该问题的一种方法是网络嵌入(Network Embedding)。NE 的中心思想就是找到一种映射函数,该函数将网络中的每个节点转换为低维度的潜在表示。

一个典型的例子就是 DeepWalk。其学习 Zachary’s Karate network 网络中的拓扑结构信息并转换成一个二维的潜在表示(latent representation)。」

参考资料:网络表示学习综述:一文理解Network Embedding

网络嵌入或者网络表示学习,以往的方法有很多,随机游走、 深度神经网络、矩阵分解等,但是这些都是基于同构图的。

异构图的embedding主要关注基于meta-path的结构信息。

PRELIMINARY

异类图是一种特殊的信息网络,它包含多种对象类型或多种链接类型。在异类图中,两个对象可以通过不同的语义路径连接,称为元路径。

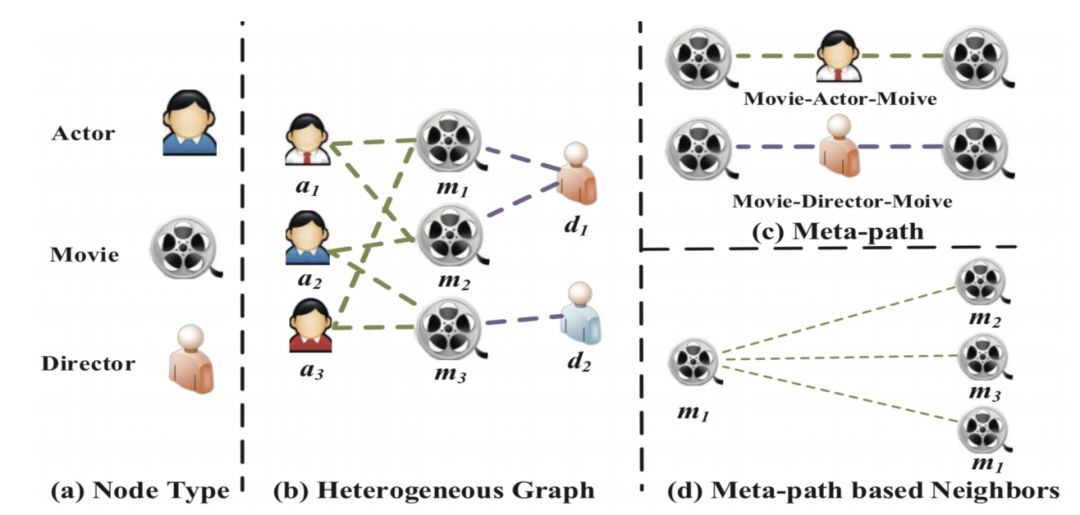

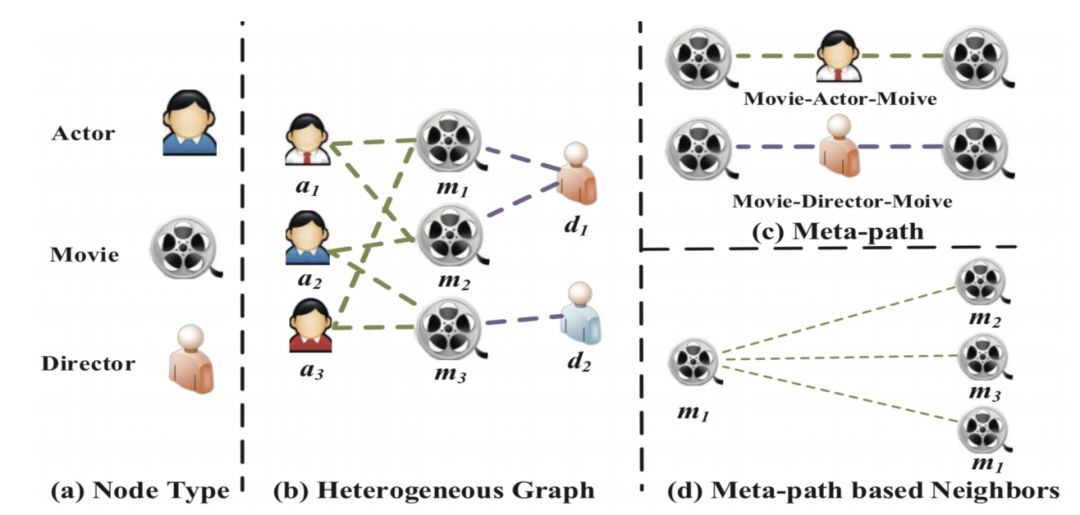

Heterogeneous Graph : 如上图,我们构建了一个异构图表模拟IMDB。它包括多种类型的对象。还有各个对象间的映射关系。图G = (V, E) 包含节点集V和连接集E。

Meta-path:如上图是指一个节点到另一个节点的序列,如两部电影可以通过一个序列链接,如Movie-Actor-Movie (MAM) 和 Movie-Director-Movie (MDM)。

Meta-paht based Neighbors:一条meta-path的所有邻居节点(包括其自身)。如上图d中m1的Meta-paht based Neighbors包括m1,m2,m3。

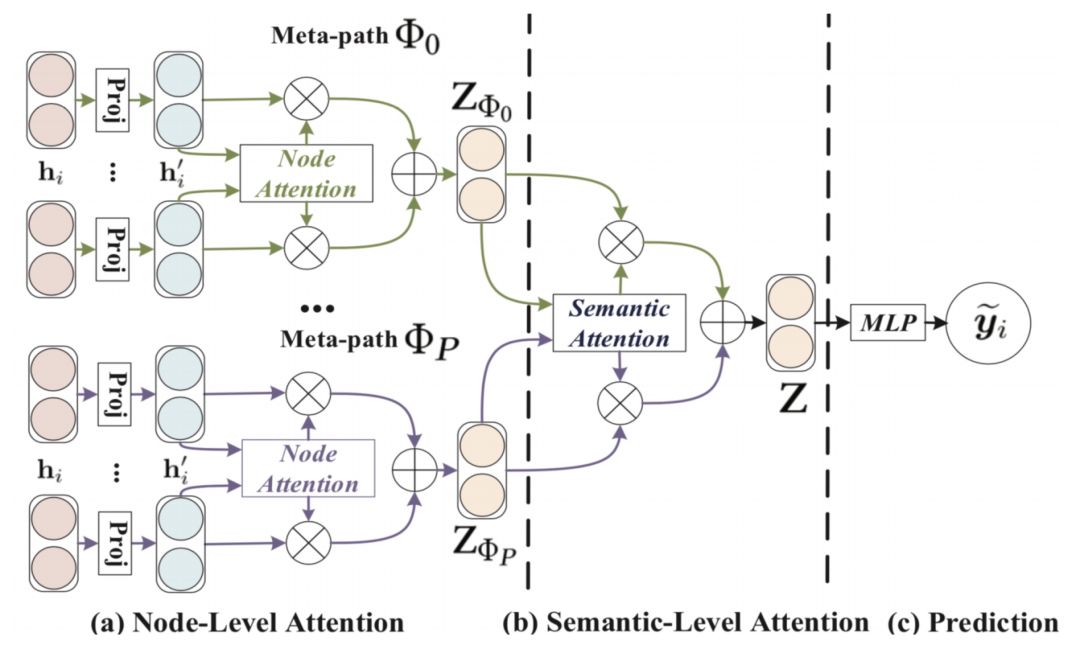

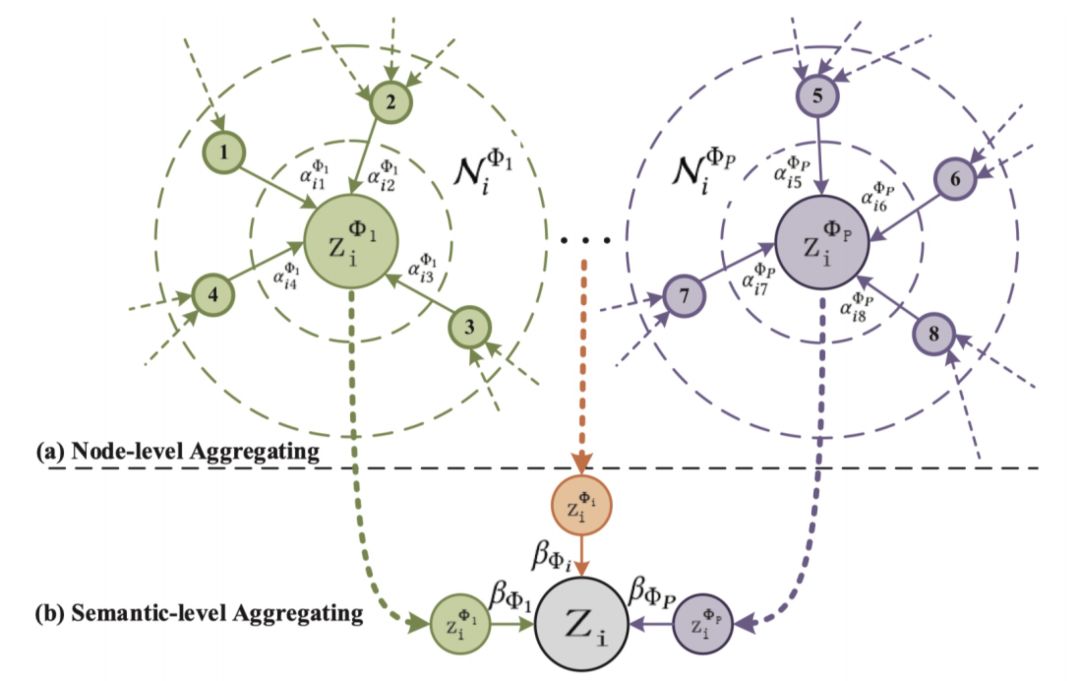

下图是论文所提出的HAN的架构图。

(a)所有类型的节点都被投影到一个统一的特征空间中,基于元路径的节点对的权重可以通过node-level attention来学习。

(b)联合学习每个元路径的权重,通过semantic-level attention融合语义特定的节点嵌入。

(c)计算拟定HAN的损耗和端到端优化。

THE PROPOSED MODEL

Node-level Attention

在对每个节点的元路径邻居的信息进行聚合之前,我们应该注意到每个节点基于元路径的邻居在学习特定任务的节点嵌入中扮演着不同的角色,并显示出不同的重要性。在这里,我们引入Node-level Attention,可以了解在异类图中,基于元路径的邻域对于每个节点的重要性,并聚合这些有意义的邻域的表示,以形成一个节点嵌入。

给定一个节点对(i , j),Node-level Attention能学习到节点j相对于节点i的权重,重要的一点是(i , j)的权重是非对称的。

通过softmax计算出节点j的权重系数,这里得到的系数也是非对称的。

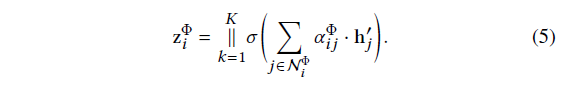

这只是得到一对(i , j),通过下面的式子聚合所有邻居节点的系数。

这只是得到一对(i , j),通过下面的式子聚合所有邻居节点的系数。

下面这个图更直观地显示node-level and semantic-level的聚合过程。

由于异类图具有无标度的特性,因此图数据的方差很大。为了应对上述挑战,我们将node-level attention 拓展到 multihead attention,使训练过程更加稳定。具体来说,我们将node-level attention重复k次,并将 learned embeddings连接为semantic-specific embedding:

Semantic-level Attention

通常,异构图中的每个节点都包含多种类型的语义信息,语义特定的节点嵌入只能从一个方面反映节点。为了学习更全面的节点嵌入,我们需要融合可以通过元路径显示的多个语义。针对异构图中元路径选择和语义融合的挑战,提出了一种新的语义层次关注,自动学习不同元路径的重要性,并将其融合到特定任务中。

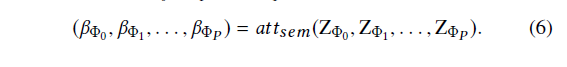

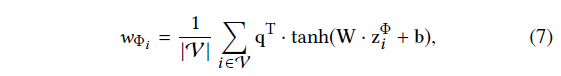

要学习每条语义的权重,论文首先使用一层的MLP将Semantic embedding进行非线性转换。通过Semantic-level Attention vector q 来衡量多条Semantic embedding 间的相似性。

经过Softmax函数,得到语义权重。

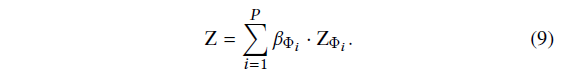

最后,获得的语义层的embedding是这样的。

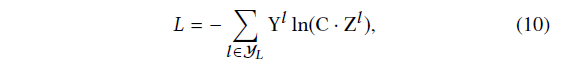

有了embedding之后,我们就可以构建loss function了,论文使用半监督的方式,通过最小化Cross-Entropy来训练。

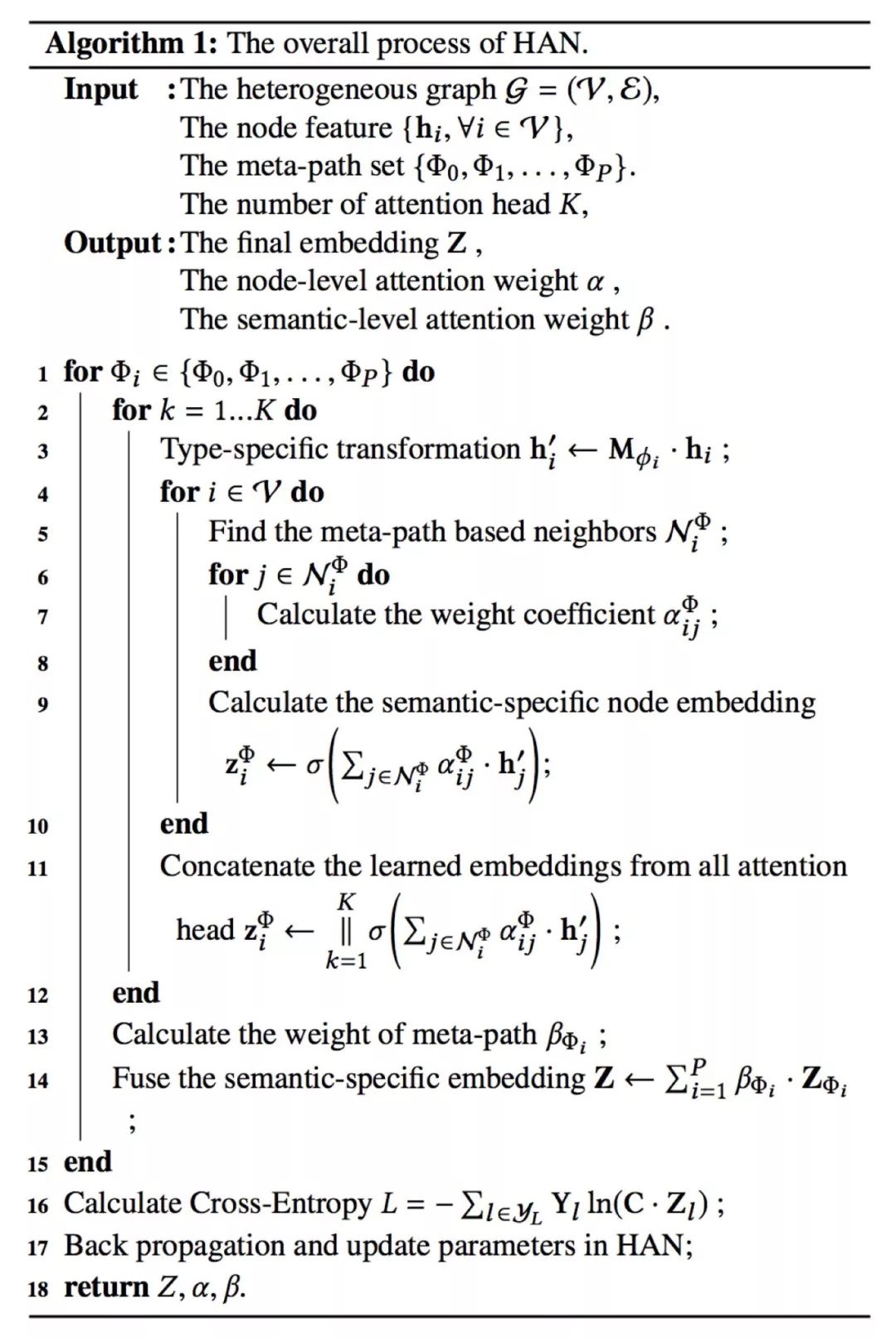

整个过程的算法如下。

整个过程的算法如下。

Analysis of the Proposed Model

该模型可以处理各种类型的节点和关系,并将丰富的语义融合到异构图中。信息可以通过不同的关系从一种节点传输到另一种节点。利用这种异构的图形关注网络,不同类型的节点嵌入可以增强相互集成、相互促进和相互升级;

该方法效率高,易于并行。注意力的计算可以在所有节点和元路径上单独计算;

整个模型的Attention是共享的,这意味着参数的数量不依赖于异类图的规模;

该模型对学习节点嵌入具有良好的解释能力,这对异构图分析具有很大的优势。

EXPERIMENTS

Datasets

实验过程用到了DBLP、ACM、IMDB三个数据集。

Baselines

Baseline包括GCN、GAT、HAN of Node、HAN of Semantic、HAN,从分类、聚类的实验结果来看,HAN基本上都是最优的。

如果喜欢相关内容欢迎随时交流,谢谢

声明:本文来自数据札记倌,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。