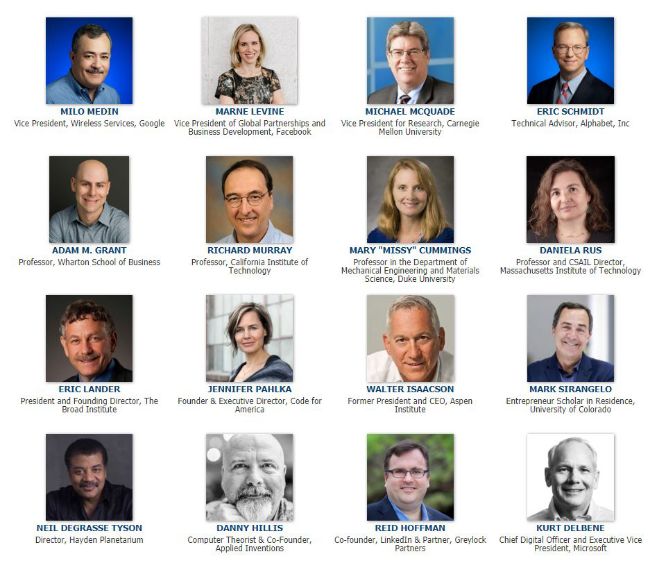

2019年10月31日,美国国防创新委员会(The Defense Innovation Board, DIB)在官网上放出了一个消息,国防部DIB投票通过了一份名为《人工智能原则:国防部人工智能应用伦理的若干建议》(AI Principles: Recommendations on the Ethical Use of Artificial Intelligence)的报告。为了向五角大楼提供这份报告,集结了16位杰出技术专家组成了专家小组负责,耗时15个月完成,同时,也征求了李飞飞、Yan Lecun在内的人工智能领域的专家的意见。

文章仅供参考,观点不代表本机构立场。

美国国防创新委员会:美国国防部人工智能应用伦理的若干建议

编译:学术plus高级评论员 张涛

报告关键结论一览

1. 报告中提出了“负责、公平、可追踪、可靠、可控”五大原则。报告强调国防部应确保技术专家对人工智能的技术、开发过程和操作方法有足够理解;国防部应避免偏见,以防在开发和部署战斗或非战斗人工智能系统时对人造成无意伤害等。

2. 报告中还提出了12条建议,包括通过国防部官方渠道将这些原则正式化,建立一个国防部范围的人工智能指导委员会,确保人工智能伦理原则的正确执行,召开有关人工智能安全的年度会议等。

目的

国防部领导美国国防创新委员会DIB为国防部设计、开发、部署战斗和非战斗AI系统的伦理准则。基于国防部现有的伦理、法律和政策框架基础,以及人工智能相关领域快速发展的现实,DIB开发的原则与国防部应对战争和保护国家安全的使命相一致。

国防部现有伦理框架和价值观

AI目前和未来都会成为国防部战斗和非战斗功能的必要能力。事实上,AI只是国防部使用的众多技术之一,也会遇到其他国防部成功和安全部署的大型技术复杂系统所遇到的挑战。国防部和DIB都有关于价值观的框架,包括美国宪法、美国法典第10篇(Title 10 of the U.S. Code)在内的其他应用法律都为现有运行的AI伦理准则提供了基础。

建立的伦理框架和其对应的价值观指导着国防部如何做和执行决策。这是通过各种各样的声明、政策文件和现有的法律义务来体现的。国防部的伦理框架反映了美国人民和美国宪法的价值观和准则。

五个原则

AI的使用是必须在现有国防部伦理框架之内的。基于这一基础,研究人员提出了更针对AI的5个原则,而且这5个原则要应用于战斗和非战斗系统。AI是一个快速和不断发展的领域,没有一个组织和企业能够开发出解决所有挑战和伦理原则的AI系统。但国防部应当为AI系统的使用设定目标,那就是这五条基本原则:

负责任。人们应当对国防部人工智能系统的开发、部署、使用和结果负责。

公平性。国防部应当采取适当的措施来避免战斗或非战斗人工智能系统的开发和部署过程中对人类造成伤害。

可追踪性。国防部的人工智能工程研究应该足够先进,这样技术专家可以对人工智能技术开发、开发过程和操作方法有充分的理解,包括透明和可审计的方法、数据源、设计程序和文档。

可靠性。国防部的人工智能系统应该有一个明确的、定义良好的使用领域,并且应该在其使用领域的整个生命周期内对系统的安全性(safety和 security)和稳定性得到测试和保证。

可控性。国防部的人工智能系统的设计和工程使用应能实现其预期的功能,同时具备检测和避免意外伤害或抗干扰的能力,如果发现已部署的系统发生意外升级或其他行为时,可以自动或手动停用。

12条建议

除了上述五个原则外,报告中还提出了对于美国国防部未来如何在战斗和非战斗人工智能系统中应用道德规范的12条建议。

(1)通过国防部官方渠道将这些原则正式化。JAIC(人工智能联合中心)应当向国防部长提出适当的通讯和政策来确保这些AI伦理准则持续性的本质。

(2)在国防部范围内建议一个人工智能指导委员会。国防部副部长应当建立一个高级委员会,负责确保国防部AI战略和AI项目是与国防部AI伦理准则是一致的。坚持AI伦理原则要求国防部将这些伦理原则融入到决策的底层,从概念级的设计到数据分享、云计算、IT策略等AI相关的领域。

(3)进一步培育和发展人工智能工程领域。OUSD(R&E)和实验室应该通过构建可行的工程实践来支持AI工程学科的成熟和成长。这些工程实践是国防部通过长期培养起来的,为刚步入科研的研究人员提供一些机会,将AI的安全性和负责任融入到AI技术和更大更复杂的工程系统中。

(4)加强国防部的培训和人才计划。国防部作战司令部、每个组成部分的办公室、国防架构和相关领域活动都应建立AI相关技能和只是的人员培训和教育方案。国防部应该通过专业军事教育和实用应用教育来为初级军官、文职人员等提供继续学习和教育的机会。

(5)投资人工智能安全方面的新研究。政策副秘书长办公室和净评估办公室应当在理解竞争与威慑的新方法方面进行投资,尤其是其与网络安全、量子计算、信息战、生物科技等领域融合在一起时。需要加强关注的领域包括人工智能的竞争和升级动力、避免危险的扩散、对战略稳定的影响、威慑的选择以及国家间积极和承诺的机会。

(6)投资于研究以增强技术的可重复性的研究。OUSD(R&E)应当加大对AI系统的可重复性的研究。AI社区面临的挑战是为国防部提供了一个理解复杂AI模型工作原理的机会。这可以帮助解决AI的黑盒问题。

(7)定义(人工智能)可靠性的基准。OUSD(R&E)应当开发出如何对AI系统的性能进行一个基准性的评价,包括与人相关的性能。

(8)加强人工智能测试和评估技术的发展。在Office of Developmental Test & Evaluation (ODT&E)的领导下,国防部应当使用或改善现有的国防部测试、评估、确认和验证过程,在必要的情况下,还应为AI系统创新的基础设施。这些过程应当遵循DIB软件采购与实践研究(Software Acquisition and Practices , SWAP)。

(9)开发风险管理方法。JAIC(人工智能联合中心)应当根据伦理、安全和风险考虑创建国防部人工智能使用的分类方法。该方法应当管理和刺激成熟技术在低风险领域的快速应用,并加强对可能会引发不良后果的应用领域的预防和检查。

(10)确保AI伦理原则的正确执行。JAIC(人工智能联合中心)应当根据2019国防授权法案第238条的要求对这些原则的应用和实现进行评估作为监管的一部分。还要研究如何实现AI伦理准则。

(11)将研究扩展到理解如何实施AI伦理原则。OUSD(R&E)应当与相关研究架构组成一个跨学科的人工智能安全性(safety和security)和鲁棒性的研究项目组(Multidisciplinary University Research Initiative (MURI)),进行相关领域的基础和学术研究。

(12)召开关于人工智能安全性(safety和security)和鲁棒性的年度会议。人工智能领域技术和应用发展迅速,JAIC(人工智能联合中心)应当召开年度会议对嵌入在AI安全性(safety和security)和鲁棒性中的伦理进行检查,以接收来自内外部的声音。

结论

文件中提出的原则并未为了掩饰一些有争议的问题,也不是为了限制国防部使用AI的能力。提出这些原则的目的是为了让AI系统和相关的操作与国防部阻止战争和保护国家的使命。此外,这些原则与现有的政策框架也是一致的。DIB站在国防部的角度提出AI伦理原则,以及实现过程中的一些建议。

美国国防创新委员会是一个独立的联邦顾问委员会,旨在为国防部高级领导提供建议。成员包括来自谷歌、脸书、微软等科技企业的高管和专家。

研究主要方向包括:软件采购实践研究;零信任之路;5G生态系统:国防部风险与机遇;AI使用原则项目。

声明:本文来自学术plus,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。