顶级大学如美国斯坦福大学和耶鲁大学以及英国牛津大学和剑桥大学的科学家们连同民间组织以及网络安全行业的企业上个月发布了一篇重要论文,题目是《滥用人工智能:预测、阻止以及缓解》。

虽然这篇论文探索了大量潜在的人工智能滥用情况(其中包含且集中于机器学习),但这里基本上排除了军事领域而主要关注于网络安全领域。然而,鉴于政治监控和法规隐私问题之间的联系,不可能完全排除潜在的政治滥用情况。

人工智能是指使用计算机执行通常仅可由人类完成的分析功能,不过是以机器的速度完成。在Corvil 公司工作的 David Murray 指出,“机器速度”是指“以20毫秒或更快的速度在多个软件程序中执行数百万个指令和计算。”人工智能就是让不可实现的东西变得真实。

论文中讨论的问题是,这个功能并不存在道德偏见。人工智能可轻易将其用于恶意目的,就像用于良好目的那样。人工智能基本上是两用的,最基本的威胁是,0day 恶意软件会更加频繁地出现而且会遭更加精准的打击,而现有的防御措施是中性的,原因在于人工智能系统掌握在恶意人员手中。

机器学习和端点保护措施

如今,机器学习类型的人工智能最常见于下一代端点保护系统中即最新的反恶意软件中。之所以称为“机器学习”类型,是因为系统中的人工智能算法从数百万(以及还在增加的)真实恶意软件的样本和行为模式中“学习”。

人工智能通过比对检测到的新模式和已知的恶意模式,以在人类分析师在任何有意义的时间范围内均不可能实现的速度和精度生成潜在恶意的概率级别。但实现它需要具备两个附加条件:它取决于“学习”算法的质量以及它所学习的数据集的完整性。

出现滥用的情况可能存在于两个领域:操纵或甚至是更改算法;以及投毒机器学习的数据集。

报告警告称,“多次发现机器学习算法也存在漏洞问题,其中包括特定的机器学习的漏洞,如通过对抗性示例或投毒训练数据引发错误分类。机器学习算法仍然易受传统漏洞的威胁(如内存溢出)。当前,网络安全研究人员对理解机器学习系统的安全性很感兴趣,尽管目前的问题的数量似乎要比答案多。”

危险在于,虽然机器学习存在威胁,但网络犯罪分子和国家黑客将开始使用自己的机器学习能力来增强对抗机器学习防御攻击的速度和准确性。

在数据集投毒方面,F-Secure 公司的安全顾问 Andy Patel 警告称,“难以诊断模型遭不正确训练且显示出偏见或执行不正确的分类。”问题在于,即使是开发出人工智能算法的科学家们也不一定理解它们实际是如何运作的。

他还指出,恶意人员并不会等待自己的机器学习来做这一点。“自动化内容生成可用于投毒数据集。虽然这种情况已经发生,但用于生成内容的技术并不一定使用机器学习。例如,2017年,和网络中立相关的数百万条评论被提交至美国联邦通信委员会。”

攻击者和防御者之间的基本矛盾将不会随着机器学习的改变而改变,各方都在想着超越对方,而且各方都会获得短暂性胜利。McAfee 公司的首席技术官 Steve Grobman 指出,“我们需要认识到,利用新型技术如人工智能的新型防御措施在最开始发布也就是在恶意人员构建好旨在规避应对措施和躲避技术之前是最有效的。”

简言之,网络安全行业意识到了对人工智能滥用的情况,而且已经开始在考虑最佳对策。“安全企业之间以及它们和这些恶意人员三方都在竞争,比试创新并保持优势,目前来看安全企业更胜一筹。”Webroot 公司的首席技术官 Hal Lonas 指出,“正如使用抗生素时,生物感染会演变成更具对抗性的耐药菌株一样,随着时间的推移,对人工智能防御措施技术使用得越来越多,恶意软件攻击也会发生改变。”

Hyrum Anderson 是报告的作者之一,也是 Endgame 公司数据科学的技术总监,他认同业内认为机器学习可遭滥用或规避的观点,但关于遭利用的方法有不同看法。他指出,“很可能信息安全圈子的数据科学家们很少会思考产品如何可遭滥用。例如,利用一种幻觉模型通过误报让安全分析师透不过起来,或者是执行类似攻击导致系统遭受基于人工智能的防御措施发动的拒绝服务攻击。”

确实,这份报告并未提供某种攻击方法(尽管会提供其它方法)。“这份报告并没有解决基于去匿名化攻击的机器学习的危险含义。”Sophos 公司的首席数据科学家 Joshua Saxe 指出。数据去匿名化是很多法规的关键要求。基于人工智能的去匿名化可能是微不足道和快速的。

Anderson 说明了 Endgame 用于保护自身机器学习算法的完整性和安全使用的三条准则。第一条准则是了解或适当限制人工智能与系统或端点的交互。第二条准则是了解并限制数据获取,例如,获取所有事件的异常检测与仅获取“和安全相关的”事件子集的异常检测。为了保护数据集的完整性,他建议“虽然信任但也要验证数据提供商,如用于训练下一代反病毒的恶意软件源。”

第三条准则是“建立模型后、部署之前和之后要主动探究盲点。实现这个目标的方法有很多,但至少手动做这件事仍然是个不错的想法。”

身份

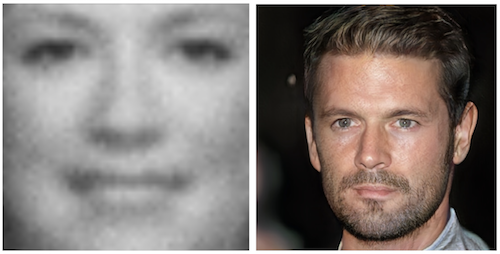

第二个滥用人工智能的潜在领域是“身份”。人工智能识别和生成人造图像的能力正在迅速提高。这种能力有利有弊。面部识别对于检测犯罪行为和恐怖分子而言通常是有益的,但它也可能越界。

Sophos 公司的 Saxe 表示,“例如,最近斯坦福大学的研究人员发布了一个有争议的算法,该算法能够根据社交媒体资料照片判断出某人是不是同性恋且准确性较高。”

研究论文指出,“根据每个人提供的五张照片,该算法的准确性已分别提升至91%(针对男性)和83%(针对女性)。”而人类的判断准确率要低得多,准确率分别为61%(男性)和54%(女性)。这种结果非常典型:人工智能能够改进人类表现的程度是人工无法设计的。

Saxe 补充道,“批评者认为这种研究可能会导致专制政权对同性恋的压迫,但这些批评意见并未在研究发布前出现。”

这种在某些情况下对人工智能的潜在滥用的案例触及到了该论文的主要主题,即人工智能天生的双重本质以及“道德”在人工智能发展过程中所发挥的作用。以下我们将详细展开道德方面的论述。

近期语音识别和语言理解的发展体现出对人工智能识别功能的积极利用。这些发展和进步本可用于更好地开展生物认证,如果人工智能不具备双重作用的话。随着面部识别和语音识别的发展,合成图像、文本和音频的生成技术也在快速发展;而报告认为这种发展“可用于模拟网上的其他人,或者通过社交媒体渠以传播由人工智能生成的内容方式影响舆论。”

图为2014年、2017年的合成图像

对于身份验证而言,Webroot 公司的 Lonas 认为我们需要调整当前的验证方式。“由于机器和人类之间的界限变得不那么明显,我们将会看到当前在认证系统中看到的改变,例如登录计算机或系统。当前认证用于区分各种人物以防止某人假冒为他人。未来,我们还需要区分人类和机器,以为后者可凭借人工智能以更高的逼真度模拟人类。”

虽然未来人工智能生成虚假新闻的潜能是另一码事,但是这个问题有可能会导致俄罗斯干涉2016年美国总统大选活动的行为显得有些过时。

就在上个月,美国起诉了13名俄罗斯人和3家企业,理由是他们“试图干涉美国政治制度从而开展联邦犯罪活动”。据称他们通过社交网络,以数百名人员轮班倒的方式投入数百万美元的预算传播虚假消息进行宣传。随着对人工智能的使用,此类活动对人力的要求更少且成本也更低,从而发生的概率也更大。

简言之,人工智能可被用于更频繁地制造虚假信息且更加现实,或者导致精准鱼叉式钓鱼活动的规模比当前通过滥用身份发动的大规模钓鱼活动更大。这种行为将同时影响企业网络安全(商业邮件遭攻陷、BEC可能会比现在更加有效)和国家安全。

道德问题

网络领域对人工智能的使用越来越多,将不可避免地将政府引入其中。虽然政府担心人工智能会导致关键基础设施遭受更加有效的网络攻击,但社会也担心政府将人工智能用于大规模监控活动中。随着所学的数据集的规模越来越大,机器学习算法也变得越来越有效,斯诺登所保留的“拥有所有的”心态对于执法部门和情报机构而言将变得更加不可抗拒。

结果,政府将会卷入关于人工智能及其所使用算法所造成的道德辩论中。实际上辩论已开始,英国金融监管机构警告称将监控人工智能在金融交易中的使用情况。

政府试图向人们保证对公民大数据的使用是符合道德的(依靠司法监督、法院判令以及最低限度的入侵等)。它还试图向人们保证企业会以符合道德的方式使用人工智能——GDPR 已开始控制自动化用户画像行为。

虽然政府通常喜欢“自我调节”(以避免自己看起来太过于强势),但科学家们并未充分地将研究中的道德问题纳入研究范围。这份报告阐述了这个问题,“对这些问题的适当回应可能受两个自我强化因素的阻碍:第一,决策者缺乏对技术的深入理解,可能导致出现设计欠佳或信息不充分的监管、立法或其它政府响应行为;第二,技术研究人员不愿意参与到这些主题中来,担心与恶意使用存在关联会损害该领域的声誉,从而可能导致资金减少或过早监管的问题。”

技术人员普遍认为政客们根本不懂技术。Acalvio 公司的首席安全架构师 Chris Roberts 就是一个例子。他指出,“如果决策者们参与进来,那么就让上帝帮助我们吧。刚看完他们参与的最后一件事,我就害怕他们想出点什么主意,然后我认为这些东西太晚了、太啰嗦、废话太多,都是些繁文缛节。他们基本上落后发展曲线5年。”

私营企业也好不到哪里去。在资本主义社会,企业都有任务在身,都是为股东谋求最大利益。不太考虑安全性的新想法不断涌入市场,而新算法也很可能会遭到同样的处理方式。

Vectra 公司的首席技术官 Oliver Tavakoli 认为安全行业有义务提供帮助。“我们必须采用更为灵活而非固定且不可渗透的防御性方法论。对于传统安全厂商而言做到这一点尤为困难,因为他们更加习惯于将人工智能分层到现有的工作流程,而不是根据人工智能带来的可能性重新思考他们所作的一切。”

Lacework 公司的联合创始人兼首席技术官 Vikram Kapoor 也同意上述说法,他指出,“安全行业有机会展示人工智能的领导地位,并将重点放在当前因网络攻击而受到打击的客户和组织的真正影响力上。”他认为,人工智能将在很多领域显示出比传统威胁更大的优势。

他继续讲到,“例如,应当将系统配置是否是安全最佳实践的日常审计工作自动化,而这就是人工智能可以发挥作用的地方。在云中持续检查是否存在异常情况的工作应当自动化,这也是人工智能的优势所在。”

然而,要求研究人员限制自己的研究范围的想法可能是错误的:研究要比对研究的潜在后续使用或滥用的道德考察更为重要。斯坦福性取向算法的例子正好说明了这一点。

谷歌数学家 Thomas Dullien (推特名: Halvar Flake)说出了研究人员的一个共同观点。他评论报告称,“研究的双重问题无法先验地建立;作为研究人员,他们通常只能选择着力于‘有用的’和‘无用的’东西。”换句话说,你不能或者说至少你不应该通过强加的政策限制研究工作,因为在这个阶段,它的价值(或缺乏它的后果)是未知的。

McAfee 公司的 Grobman 认为,专注于人工智能研究的道德问题是防御人工智能的错误焦点。他指出,“我们需要强调恶意人员使用人工智能所带来的能力,而不是试图阻止在人工智能领域取得的进展并阻止它的发展。”

总结

论文《滥用人工智能:预测、阻止以及缓解》提出了四项“更好地预测、阻止以及缓解”因不受限的人工智能所带来的威胁。它们是:决策者和研究人员(即政府和行业)之间开展更多协作;人工智能研究人员采用道德最佳实践;采用处理双重问题的方法论;以及让更多的股东和领域专家参与到问题讨论中来。

尽管报告的细节收到了更多细致化的评论,但这些建议表明,要解决网络犯罪分子和国家黑客使用人工智能所带来的威胁问题并不存在显著的解决方案。

确实可以说解决方案并不存在。就像无法阻止而只能缓解犯罪分子对加密的使用那样,对人工智能遭恶意使用的情况也并不存在解决方案,而只有缓解措施。如果这种观点站得住脚,那么针对恶意使用人工智能的防御措施将回到在自家产品中使用人工智能的这些安全供应商中。

然而,很可能在网络世界中因人工智能的不受限使用而带来的所有威胁只是危言耸听。

F-Secure 公司的员工 Patel 认为,“凭借生成‘虚假’内容(文本、声音和视频)的能力,开展社工和虚假宣传将变得更加容易。互联网上有很多人能够快速识别出某张照片是否经过 PS,我认为判断某些东西是否是自动生成还是经机器学习算法更改的也可能也会变得一样容易。”

他补充道,“未来,如果无法判断某些内容是否是由机器学习生成的,那么研究人员需要查看围绕该内容的元数据来判断其有效性(如时间戳、IP地址等)。”

简言之,Patel 认为人工智能会从质量和数量上放大当前所面临的威胁情况。但是人工智能也会大大发展当前的防御措施。

他表示,“让人担忧的是,基于超级强大的机器学习的模糊器会导致攻击者轻松且迅速地找出无数0day 漏洞。不过,要记住,这些模糊器也会为白帽子所使用。最终的发展情况可能和今天并无二致。”

本文由360代码卫士翻译自SecurityWeek

声明:本文来自代码卫士,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。