大家可能还记得,今年2月Facebook发布的,人体姿势实时识别系统DensePose。

现在,代码开源了。撒花。

100人也很轻松

DensePose,这项技术可以把2D图像,转换成3D人体模型,并已成功跻身今年CVPR的Oral环节。

Facebook和来自法国的INRIA研究所共同开发的AI,和传统姿态估计系统很不一样。

前人的姿势识别,大多是着眼一组关节,比如手腕,比如肘部。

不过,Facebook团队觉得,这样的观察方式,是没有办法深刻理解图像的。

他们需要的是,人体表面的全方位观察,把每个人变成UV贴图,一片一片一片,一片。

系统可以覆盖浑身上下超过5000个节点,比十几个关节要细致得多。

另外,DensePose每秒处理多帧画面,而且,就算视频里同时出现100个人,也没问题。

每一个被人体占据的像素,尽收眼底。

这样的任务,一个GPU可以完全搞定。2D转3D的速度和准确度,有希望为AR/VR这样的应用提供加持。

数据集叫COCO

这样的成就,DensePose-COCO功勋卓著。

这是一个大规模的参考标准 (Ground Truth) 数据集。里面包含了5万人图像 - 表面UV图的一一对应。

随机采样的人类,千姿百态,还有各个身体部位分割开来的样子。

万事俱备,只是数据集还没开源。

模型结构怎样

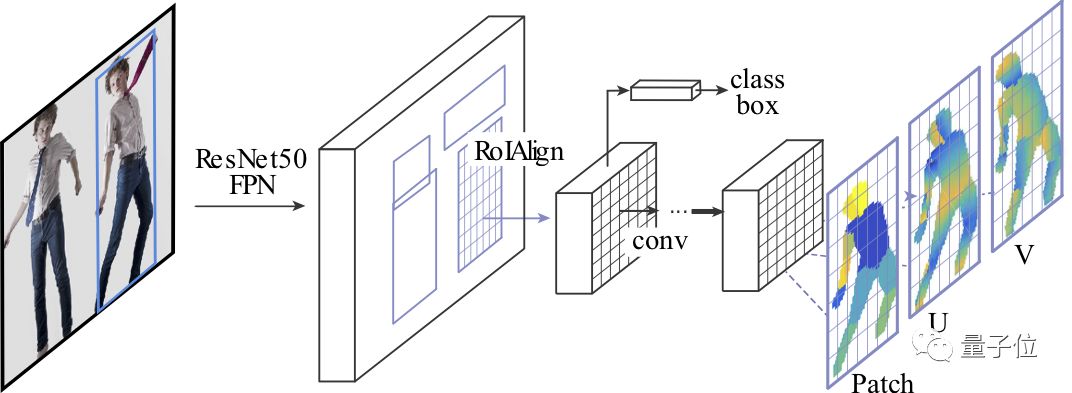

DensePose-RCNN,深度神经网络的结构,是团队新建的。

他们是在Facebook自家的物体检测平台Detectron上面,搭起了这样一个模型。

在全卷积处理之后,用了兴趣区域池化层 (ROI Pooling) 。研究人员用三个输出通道,扩增了这个网络。

训练好之后,AI可以把每一个像素,分配到不同的身体部位,给出U坐标和V坐标。

看着自家神经网络茁壮成长,Facebook团队还在博客里致谢了被并到PyTorch里的Caffe 2。

学习时间

现在,既然还不知道数据集里面,有多少羞羞的姿势,大家就先瞻仰一下代码吧。

GitHub传送门:

https://github.com/facebookresearch/DensePose顺便,CVPR正在盐湖城开心地进行。6月22日,就要轮到DensePose团队开讲,当地时间早8点之前,沉迷学习的各位可以趁机复习一下论文。

论文传送门:

https://arxiv.org/pdf/1802.00434.pdf声明:本文来自量子位,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。