从自动驾驶到网络购物,人工智能技术已经渗入数字社会的各个角落,但是人工智能的网络安全和风险管理却相对滞后,NIST推出的人工智能风险管理框架期望能够解决这种“风险差距”。

今天,企业和政府组织正在快速拥抱如雨后春笋的人工智能(AI)应用程序,提高自动化程度和运营效率,提供精准购物建议、信用审批、图像处理、预测性警务等等服务。

与任何数字技术一样,AI可能会受到一系列传统安全漏洞和其他新兴问题的影响,例如隐私、偏见、不平等和网络安全问题。为了更好地管理与人工智能相关的风险,美国国家标准与技术研究院(NIST)目前正在开发一个自愿框架,全称是:人工智能风险管理框架(AI RMF)。该框架的目标是将可信度考虑纳入人工智能产品、服务和系统的设计、开发、使用和评估的能力。

NIST希望AI RMF风险框架能够覆盖其他领域没有的,AI独有的风险,并可用于绘制超出框架的合规性考虑因素,包括现有法规、法律或其他强制性指南。

谁应该关注AI风险管理框架

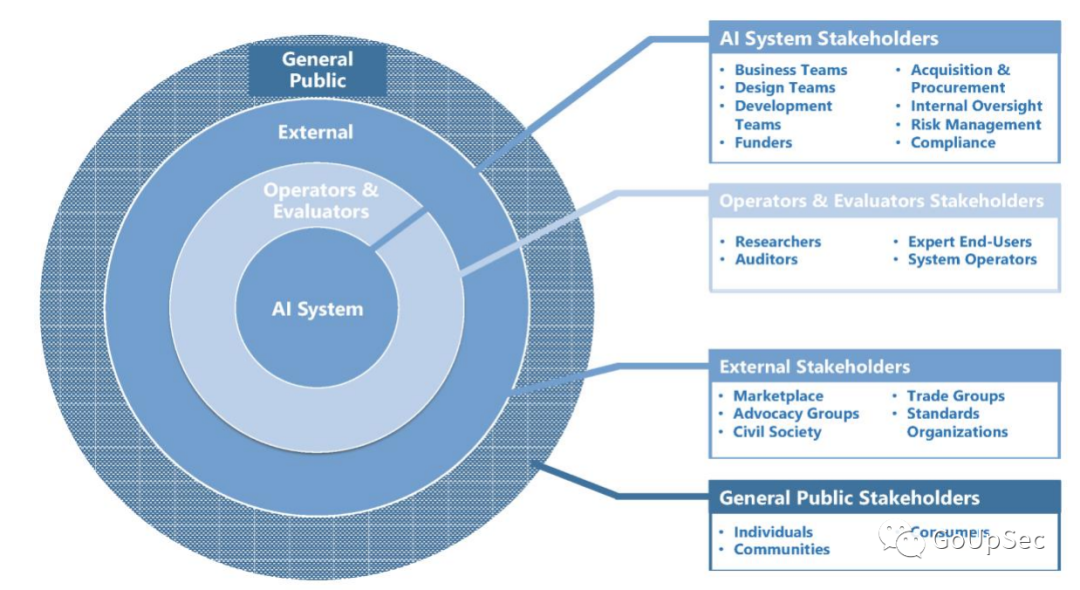

NIST将AI RMF框架的目标受众划分为四个利益相关者群体(上图):

人工智能系统利益相关者

运营商和评估者

外部利益相关者

公众

在识别和管理与AI系统相关的风险的综合方法中,NIST使用了三类特征分类法:技术特征、社会技术特征和指导原则:

技术特性是指AI系统设计人员和开发人员直接控制的因素,可以使用标准评估标准来衡量,例如准确性、可靠性和弹性。

社会技术特征是指人工智能系统在个人、群体和社会环境中的使用和感知方式,例如“可解释性”、隐私、安全和管理偏见。

指导原则是指更广泛的社会规范和价值观,表明社会优先事项,例如公平、问责制和透明度。

与其他NIST框架一样,AI RMF核心包含AI风险管理活动的三个元素:功能、类别和子类别。这些功能被组织用于映射、衡量、管理和治理人工智能风险。尽管AI RMF原计划通过配置文件为特定用例提供上下文信息,但该任务以及计划中的实践指南已被推迟到以后的草案。

人工智能风险治理各自为政

虽然大量科技企业正在开发、销售和部署人工智能技术,但很少有企业关注人工智能的风险治理政策。bnh.ai的科学家Patrick Hall表示,在大型消费金融机构和其他一些高度监管的领域之外,人工智能大多在没有正式风险治理规范的情况下被使用,因此企业(用户)只能自行解决这些暴风雨般的治理问题。”

微软首席人工智能官Natasha Crampton表示:“当你的治理方法过度分散时,就注定会出现失败模式。在这种情况下,团队希望将AI模型部署到生产中,但他们只是采用自己的流程和结构,几乎没有(风险治理方面的)协调。”

富国银行执行副总裁兼企业模型风险负责人Agus Sudjianto也强调AI风险管理离不开高层管理。“如果AI项目负责人没有高层的声望、通道和支持,那将是行不通的。”

埃森哲首席云计算技术官Teresa Tung强调,所有企业都需要专注于人工智能。“全球2000强公司中约有一半在财报电话会议中报告了人工智能技术应用。这(人工智能风险管理)是每个企业都需要意识到的事情。”

与NIST开发的其他风险管理框架(例如网络安全框架)一样,最终的AI RMF可能对私营和公共部门产生广泛的影响。目前AI RMF还处于草案的意见征询期,截止日期为2022年4月29日。

AI RMF草案下载地址:

https://www.nist.gov/system/files/documents/2022/03/17/AI-RMF-1stdraft.pdf

声明:本文来自GoUpSec,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。