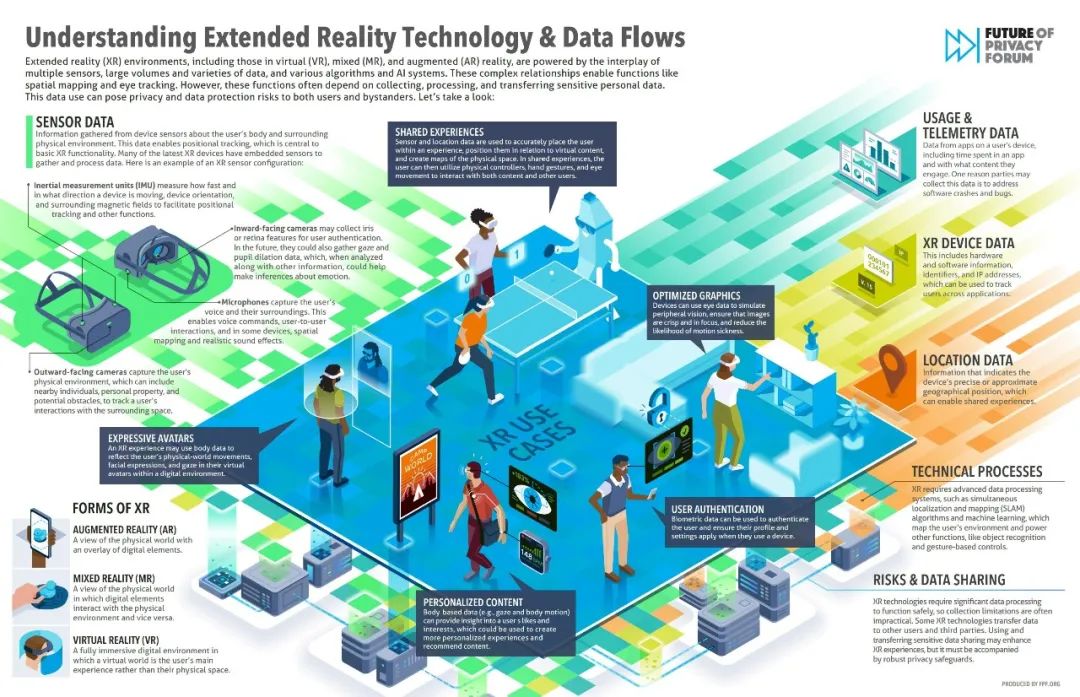

10月27日,全球非营利组织隐私未来论坛(Future of Privacy Forum,简称“FPF”)发布了其关于XR技术的数据流动和隐私风险信息图,通过探索XR技术可能支持的用例,将XR数据流动的工作方式、利用的传感器种类、数据类型、数据处理和传输流程可视化。

随着企业越来越多地开发和采用虚拟(VR)、混合(MR)和增强(AR)现实等拓展现实(XR)技术,潜在的隐私和数据风险与日俱增。立法者、监管机构和其他专家对XR技术的工作原理、数据保护风险以及可采保护措施来越来越感兴趣。

XR技术由多个传感器、大量数据以及各种算法和自动化系统(例如机器学习)的相互作用提供支持。然而,这些用例通常依赖于可能属于敏感个人数据的信息,而这些数据的收集、处理和传输可能会给用户和旁观者带来隐私和数据保护风险。

“XR技术通常需要有关瞳孔扩张和凝视的信息才能发挥作用,组织可以使用这些信息得出用户的性取向、年龄、性别、种族和健康状况等结论,”FPF的政策顾问兼信息图合著者Daniel Berrick说。

FPF的分析表明,跟踪身体运动的传感器也可能会破坏用户的匿名性。除了帮助绘制用户的物理环境,传感器还可以启用数字指纹,这使得识别用户和旁观者变得更加容易,同时引发去标识化和匿名化问题。由于担心报复,这些风险可能会阻碍个人充分表达意见和参与XR环境中的某些活动。

此外,FPF发现对身体数据的法律保护可能取决于隐私法规对生物特征数据的定义。然而,目前还不能确定美国生物识别法(如伊利诺伊州《生物识别信息隐私法案》)是否适用于XR技术的数据收集行为。

这表明现有法律对生物特征数据的保护可能无法扩展到涉及XR技术的所有情况。但是,由于XR数据有可能对个人做出敏感推断,因此可以考虑适用其他特殊类别的数据保护条文对个人隐私和数据进行保护。

FPF“数据流动和隐私风险”信息图

*来源:FPF

声明:本文来自数据合规公社,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。