ChatGPT制作的内容全面且看似准确,但是研究人员、艺术家和教授等群体发现其现存的缺点会降低内容产出的质量。

它无法创建感觉自然、包含真正见解的内容;

它无法感受或创作原创思想,这使其成为产生艺术表现形式的糟糕选择;

有时它还会“说谎”,使得部分内容必须经过专业人工审查……

摘译 | 李秋娟/赛博研究院实习研究员

来源 | SEJ

“人工智能生成内容”(AIGC,AI Generated Content)最近火遍全球。以其为核心技术的聊天机器人ChatGPT纷纷刷屏,引发讨论热潮。

但ChatGPT的开发者OpenAl同时警告,现在人们还不能依靠ChatGPT来完成重要事项,因为它在稳建性和真实性上还有所欠缺。

ChatGPT究竟还有哪些问题?本文将带你了解如何识别ChatGPT的生成内容。

01 无法使用习语,可以被检测为非人类

成语或是带有比喻意义的短语,例如“雨过天晴”(Every cloud has a silver lining)。如果一段内容中缺少习语,则可能代表该内容由机器生成,这也成为检测算法的一个小技巧。

2022年发表的论文《神经-统计特征在检测生成训练中的对抗鲁棒性》(Adversarial Robustness of Neural-Statistical Features in Detection of Generative Transformers)解释了这一点:“复杂的短语特征,是指基于特定单词和短语分析其在文本中出现的频率......习语特征在当前生成模型的检测中保留了最强大的预测能力。”这种无法使用习语的特性导致ChatGPT的输出显得并不自然。

02 缺乏表达能力

表达是交流思想或感受的行为。但ChatGPT的输出并不包含表达,仅包含陈述。

一位艺术家评论说,ChatGPT的输出是在模仿艺术,但缺乏艺术所想表达的实际品质。它无法像人类一样生产在情感上触动人心的内容——因为它没有实际的想法或感受。

音乐艺术家Nick Cave在其社交平台上发表的一篇文章,评论了ChatGPT按照其风格创作的歌词。原本的歌词讲述了一个与歌曲中说话的人的悲情、欲望、羞耻和故意欺骗产生共鸣的故事。

但ChatGPT仅模仿了艺术家的风格,实际上并没有传达任何信息——因此,Nick Cave认为ChatGPT制作的歌词是对创作者来说是一种拙劣可笑的模仿。

他认为:“一首伟大的歌曲之所以伟大,是因为这是对一个人的脆弱、危险、渺小气喘吁吁的对抗;正是这种救赎性的艺术行为激起了听众的心,听众在歌曲的内在运作中认出了自己的鲜血、挣扎与苦难。”

03 不具备洞察力

洞察力是好文章的标志,而这正是ChatGPT并不擅长的。

人类通过知识进行创造,也通过个人经验和主观感知创造。但ChatGPT生成的学术论文缺乏对主题的见解。它擅长总结,却无法提供对该主题的独特见解。

The Insider网站援引阿巴拉契亚州立大学教授Christopher Bartel的观点:“虽然ChatGPT文章可能表现出很高明的语法和复杂的想法,但它仍然缺乏洞察力。”

04 过于详细和全面

ChatGPT的训练方式是在人类对答案感到满意时给予机器奖励。评分者倾向于更喜欢有更多细节的答案。但有时,直接回答比全面回答更好。

2023年1月发表的一篇论文《ChatGPT与人类专家的距离有多近?》(How Close is ChatGPT to Human Experts?Comparison Corpus, Evaluation, and Detection)发现,ChatGPT内容中的模式使其不太适合某些关键应用程序。研究表明,在与金融和心理学相关的问题中,超过50%的人更喜欢ChatGPT的答案,但ChatGPT无法回答医学问题。

研究人员写道:“ChatGPT在医学领域的表现不佳。ChatGPT通常会给出冗长的医疗咨询答案,而人类专家可能会直接给出直截了当的诊断或建议。”

ChatGPT的制造商OpenAI也承认这是一个已知的限制。ChatGPT倾向于从不同的角度涵盖一个主题,这使得当最佳答案就是直接答案时它不能给出更短、更直接的回答。因此,使用ChatGPT的营销人员必须注意这一点,因为需要直接回答的网站访问者不会对冗长的网页感到满意。

05 逻辑清晰但不自然

ChatGPT的写作风格不仅冗长,而且倾向于遵循一种模板,这导致其内容具有一种非人类的独特风格。这种风格差异体现在人类和机器在回答问题的不同方式上。

电影《银翼杀手》中有一个场景包含一系列问题,目的是判断回答问题的对象是人类还是机器人。这些问题是“Voigt-Kampff测试”中的一部分。

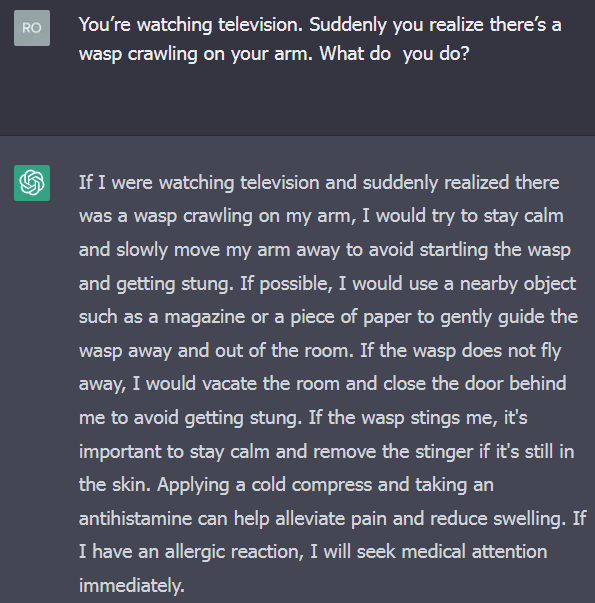

其中一个问题是:“你在看电视,突然意识到有一只黄蜂在你的手臂上爬行。你将怎么做?”正常的人类反应是尖叫、拍打和驱赶。

但是当向ChatGPT提出这个问题时,它提供了一个精心组织的答案,总结了逻辑上的多种可能结果,却未能直接回答问题——这给人一种非常不自然的感觉,对于人工智能来说是个减分项。

ChatGPT回答Voight-Kampff测试问题的屏幕截图

06 ChatGPT说谎(幻觉事实)

有研究注意到ChatGPT有说谎的倾向。

“在回答需要特定领域专业知识的问题时,ChatGPT可能会捏造事实以给出答案……例如,在法律问题上,ChatGPT可能会发明一些不存在的法律条款来回答问题。此外,当用户提出没有现有答案的问题时,ChatGPT也可能会捏造事实。”

Futurism网站就记录了在媒体网站CNET上发布的、机器生成但充满“愚蠢错误”的实例。此前OpenAI也发布了警告:“ChatGPT有时会写出看似合理但不正确、荒谬的答案。”因此,CNET声称已将机器生成的文章提交给人工审核。

而人工审核的一个问题是,ChatGPT内容看起来逻辑通顺,因此可能会愚弄不了解行业知识的审阅者。

07 思维不发散

人类交流可以通过转移话题而产生间接的含义。但ChatGPT过于字面化,导致答案有时会忽略实际的语义。

研究人员写道:“ChatGPT的回答通常严格集中在给定的问题上,而人类的回答是发散的,很容易转移到其他主题。人类可以根据自己的常识和知识回答问题下隐藏的含义,但ChatGPT仅能基于字面意思给出回答……”

08 过分中立

ChatGPT的输出一般情况下是中立的且信息丰富的,但实际上仍然包含了输出中的偏差,尤其是在涉及法律、医学和技术的问题上,中立是一种不受欢迎的品质。

09 正式有余,幽默不足

ChatGPT无法用轻松的口吻回答问题,也不使用缩写,它的回答往往是正式有余,反讽、隐喻和幽默不足。而人类倾向于用更口语化的方式表达,还会使用日常用语和俚语。

10 高风险下需要人工审核

ChatGPT目前仍在训练和改进。因此,OpenAI建议ChatGPT生成的所有内容都先由人工审核为宜。这个建议目的是让人类参与进ChatGPT的训练过程中:“人们应该意识到系统的局限性,并且访问、验证ChatGPT输出所需要的信息——这在高风险领域和代码生成中尤为重要。”

显然,ChatGPT还存在许多问题,使其不适合在无监督的情况下生成内容。

声明:本文来自赛博研究院,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。