本文发表于《指挥信息系统与技术》2023年第2期

作者:刘玮,张永亮,程旭

引用格式:刘玮,张永亮,程旭. 基于深度强化学习的人机智能对抗综述[J]. 指挥信息系统与技术,2023,14(2):28-37.

摘要

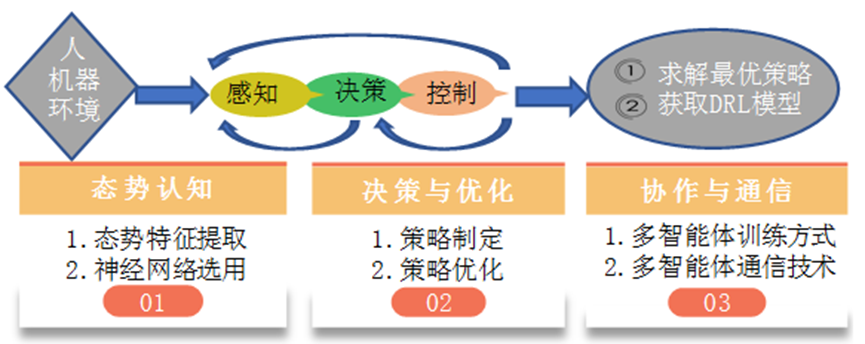

人机对抗是人工智能的热门领域,同时也为探索机器智能的内在原理与发展提供了途径。基于深度强化学习,讨论了人机智能对抗技术,并分析了人机对抗的内涵与机理。首先,简化了感知-判断-决策-行动(OODA)模型,总结了适用于深度强化学习的人机对抗框架,并归纳了态势认知、决策与优化以及协同与通信等关键技术;然后,阐述了态势特征提取与神经网络选择、策略制定与策略优化以及多智体训练模型与通信等技术内容;最后,列举了当前人机对抗的应用与挑战,并对人机对抗的未来发展做出了展望。

1 问题的提出

近年来,深度学习(DL)迅速发展,已在自然语言处理、图像识别和目标检测等领域取得了巨大成就。DL通过组合低层特征来形成更抽象的高层表示、属性类别或特征,同时给出数据的分层特征表示。强化学习(RL)作为机器学习的一个分支,其本质是为了解决时序决策问题,已广泛用于围棋、机器人控制、车辆驾驶、动态调度和游戏博弈等领域。随着深度Q网络(DQN)算法的提出,人工智能领域诞生了新的研究方向,即深度强化学习(DRL)。DRL将DL的抽象能力与RL的决策能力进行了融合,通过神经网络感知高维度特征,从而实现端到端输出,并极大降低了问题的复杂程度。

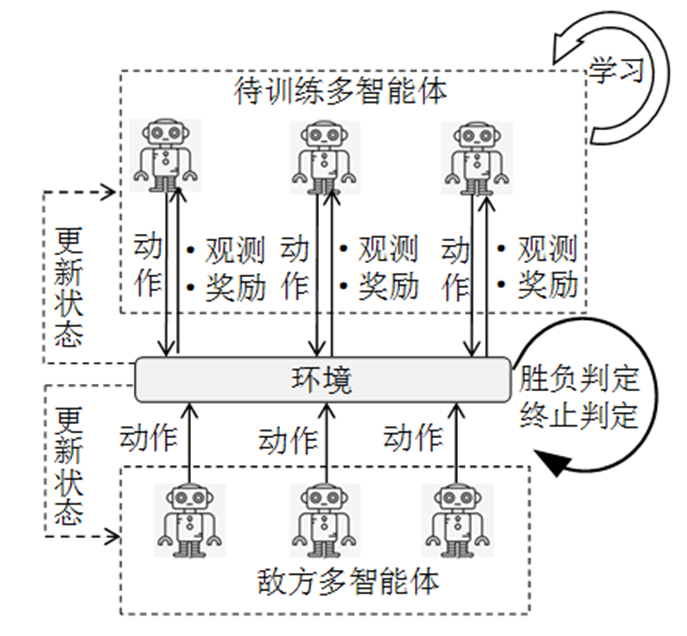

人工智能的发展一直受到广泛关注,而如何衡量一个智能体的智能程度则取决于人与智能体之间的对抗。随着Deep Blue、AlphaGo系列、Libratus和AlphaStar在国际象棋、围棋、德州扑克以及星际争霸中不断战胜人类,人工智能的胜利将“智能化”热潮推向了新的顶峰。上述人机对抗实例中,DRL扮演了重要角色,对智能体的胜利起到了关键作用。当今世界仍处在由弱人工智能迈向强人工智能的阶段,而将DRL与人机智能对抗进行有机融合可为挖掘并培育强人工智能提供技术准备,因此开发出一种真正有着自我意识且能进行推理和解决问题的智能机器尤为重要。本文从DRL出发,对人机智能对抗进行了阐述。基于DRL的人机智能对抗原理图如图1所示。

图1 基于DRL的人机智能对抗原理图

尽管DRL与人机智能对抗表现出了高度契合性以及广阔的应用前景,但是目前基于DRL的人机智能对抗仍面临以下问题与挑战:1)态势认知信息复杂多变,难以全面有效地抽取态势特征,故不利于深度神经网络感知;2)在不完全信息对抗局势中,由于缺少全局态势信息,DRL做出的决策存在鲁棒性差以及陷于局部最优等问题;3)不同对抗中的DRL模型难以进行迁移,缺乏泛用性。

2 人机对抗的内涵及其机理分析

2.1 基本内涵

人工智能(AI)必然离不开人工智能之父——阿兰•图灵,对于机器是否能够思考的问题,他提出了著名的图灵测试,即让1个人和1台机器作为2个受试者(多在暗处),与他们隔离的测试者向他们提各种问题,由2个受试者回答,若测试者分辨不出2个受试者中谁是人谁是机器,那么认定该机器能够思考。人机对抗从广义上说也是图灵测试的一个重要手段,可看作智能体性能的验金石。

人机对抗是一种人与机器相互博弈的方式,人机对抗涉及人、机器(智能体AI)和环境等要素。其中,人指人类;机器指AI或人创造的机器;环境指人机对抗中的规则和对局形式等信息,如在德州扑克中,己方和对方的牌均为环境的一部分。根据人机对抗中获得的环境信息,可将对弈分为完全信息博弈、不完全信息博弈(指没有参与者能够获得其他参与者的行动信息)和不完全信息多智体博弈。其中,完全信息博弈包括Deep Blue和AlphaGO等棋类游戏,游戏对弈双方均能清楚地观察到棋盘上所有棋子的位置以及对手的动作决策;不完美信息博弈则包括了麻将和德州扑克等牌类游戏,这类游戏最大特点是拥有隐藏信息,且随着隐藏信息数量不断增加,做出正确决策的难度也呈指数级增加;不完全信息多智体博弈更复杂,如在王者荣耀与Dota等即时战略游戏中,每个独立的智能体不仅需考虑隐藏信息的干扰,还需准确分析对局形式,在竞争与合作、作战与撤退以及获取资源与转化资源的复杂情况下做出最优决策。

2.2 内在机理

人机对抗的最终目的是为了实现机器在性能上对人类的超越,而其本质则是为了探索机器超越人类这一过程中的内在机理与技术原理。黄凯奇等从博弈的角度对人机对抗进行了分析,根据人机物要素分析法将对抗分为一元博弈、二元博弈和三元博弈,并从博弈学习角度将人机对抗智能的科学问题概括为可建模、可计算和可解释。周雷等提出了人机对抗中的博弈学习研究框架,将人机对抗划分为输入对抗任务、构建博弈模型、定义博弈可行解、计算博弈解和输出策略组合等步骤,将一类人机对抗任务的解决近似或等价转换为对某一类博弈问题的求解。

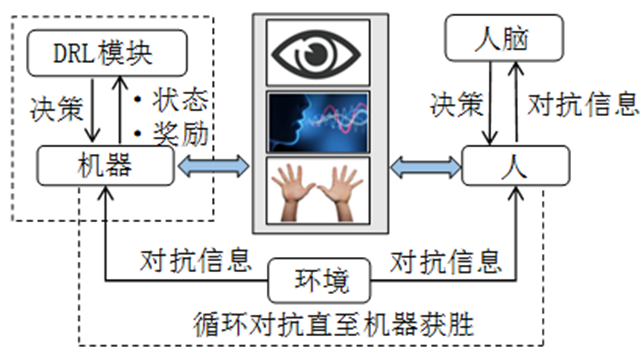

与从博弈角度出发的人机智能对抗相比,本文以DRL的视角看待对抗问题,将求解人机对抗任务视为求解最优DRL模型,实质上是从值出发,通过值来衡量对抗任务的完成质量和完成度,因为DRL的学习过程是累计奖励的期望最大化的过程。从值的角度看,人机智能对抗问题可概括为以下3个方面内容:1)态势可提取:指可从人机对抗模型中提取关键信息,并能有效输入神经网络;2)最大值可计算:指提供的奖励反馈信号需拥有一定的梯度,能够使神经网络进行梯度更新从而优化参数,并最终使全局奖励最大化;3)策略可输出:指训练过程中DRL模块能有效输出正确动作,而正确动作既可以是离散动作又可以是连续动作。本文将DRL引入人机对抗过程中,其机理如图2所示。

图2 基于DRL的人机对抗机理

人机对抗与人机交互紧密相关,后者为前者提供了媒介,使得单独的人与独立的机器相互关联,为后续对抗研究提供基础;前者对后者进行评判与改进,可从众多交互方式中挑选出更合适且更高效的种类,并对此不断完善。特定环境中,人与机器可以通过语音、视觉和姿态等方式进行交互,环境将交互所得的对抗信息分别传递给人与机器。机器可与DRL模块进行绑定,DRL模块内嵌于机器中,在外界看来二者是一个整体,而在内部则进行了分化,机器将奖励和状态等信息传递给DRL模块,由其决策下一步的行动。

人类获得对抗信息后,经由人脑进行运算推理,并结合以往经验和认识水平等因素做出决策;将决策反馈给环境,环境对这些决策做出相应的推演与改变,即进行了一次人机对抗;在循环的对抗中实现机器对人类的超越,以及DRL模块对人脑的超越。

3 基于DRL的人机对抗技术

为了使人机对抗过程更具规范性、可解释性和推广性,美国空军上校John Boyd在20世纪70年代提出了著名的作战指挥模型,即将对抗过程抽象为感知-判断-决策-行动(OODA)环。黄凯奇等则将OODA环归纳为感知-推理-决策-控制,其中感知是对对抗态势的理解,推理是在感知基础上对态势进行预测分析,决策和控制是在感知与推理后下达策略指令,并进行方案的实施与调控。通过不断迭代整个决策环路,智能体的决策水平与对抗能力得以持续提升。DRL利用深度神经网络将感知与推理进行联合抽象,因此本文将基于DRL的人机智能对抗决策流程简化为感知-决策-控制,并将对抗技术归纳为态势认知-决策与优化-协同与通信,最终在迭代完成后得到最优策略以及训练好的DRL模型,为后续研究与分析提供参考。

3.1 态势认知

态势认知的概念是美国著名心理学家M. Endsley在研究飞行员空战任务时提出的,一般分为感知、理解和预测3个层次。朱丰等给出了联合作战背景下战役级作战态势的概念,虽然态势从广义来说包含了环境要素,但比环境要素多了许多看不见的信息,如战场态势中对抗双方的力量对比以及对敌方战略的预测分析等。

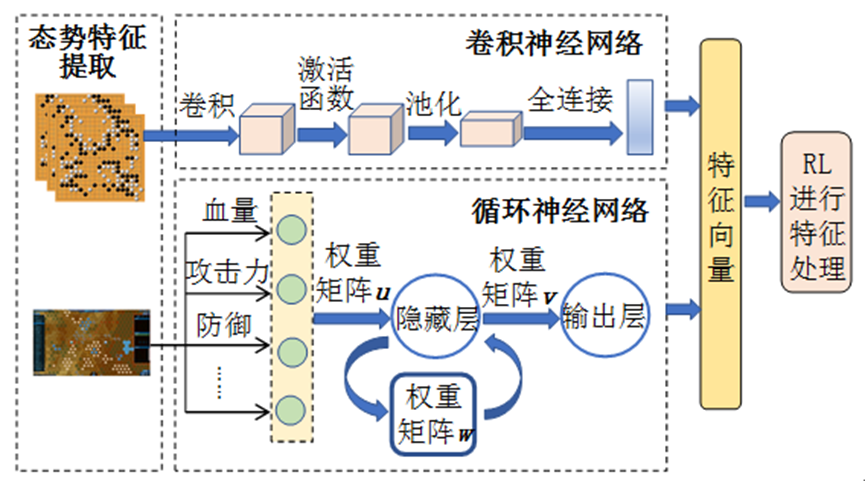

胡晓峰提出了态势认知速度将决定智能化作战的胜负的观点,未来的人机对抗将会是高智能的、高数量级的和高强度的。在这种情况下,人发挥的作用是有限的,如在AlphaGo与李世石的围棋对弈中,由于人脑的感知限制,使人对棋盘局势和棋子走向的预测始终存在局限性,充满了主观色彩,这说明人类难以胜任复杂的感知活动。而AlphaGo凭借监督学习和强化学习生成的策略网络,对棋局表现出了强大的感知力,获得了超越人类的棋感,最终以4:1战胜李世石。因此,为了加快认知速度,态势认知必然会向着智能化方向发展。本文将态势认知分为态势特征提取和神经网络选用2个步骤,而最终得到的特征向量则是DL对态势的一种抽象认知。态势认知图如图3所示。

图3 态势认知图

3.1.1 态势特征提取

为了将神经网络应用于态势认知,关键的特征提取是必不可少的。特征提取包括以下内容:1)先验特征提取:如在兵棋对抗中将战场环境(包括地形和气象等)、部队当前任务及行动、装备设施的当前状态、路径信息(运动目标的轨迹)和动态信息(交火和位置变化等)提取为先验特征;2)图像特征提取:对于一些难以提取的特征,则可采用图像提取方式,如在围棋和麻将等对抗中,想要从复杂对局中抽象出关键的信息则十分困难,因此采用图像感知形式将整个对局盘面传入神经网络,由神经网络进行推理分析,避免人为的过度解读。

3.1.2 神经网络选用

对于一些简单的对抗,普通的人工神经网络(ANN)可有效解决感知问题,而面对状态空间和动作空间中更复杂的对抗,简单网络就显出了弊端,而循环神经网络(RNN)与卷积神经网络(CNN)则能有效解决上述问题。RNN网络可以实现信息的时间转移,拥有记忆能力,可将当前对抗信息传递到下一阶段对抗中,为智能体后续博弈选择提供依据。AlphaStar、斗地主AI DouZero和Dota2均采用了RNN的变体长短期记忆网络(LSTM),提高了智能体对态势的理解,并通过整合历史信息做出更优判断。CNN凭借对人类直觉的模拟,在AlphaGo上取得了巨大成功,使其成功模拟了人类的棋感。徐佳乐等提出一种基于CNN的战术机动策略模型学习方法,采用了基础态势特征融合与网络参数共享方式来提取更多深层次的态势特征。此外,王者荣耀AI将CNN与LSTM同时应用于模型训练,通过CNN提取图像特征,将游戏状态信息传递给LSTM网络,并结合目标注意力机制对每个单位的动作进行预测。

3.2 决策与优化

决策表明根据对抗环境信息与当前自身状态制定策略, 并选择合适的行动方案,具有实时性、时序性和反馈滞后性。智能体做出的决策均基于当前态势下的选择,且决策与决策之间拥有先后关系,而影响智能体决策的最大因素是反馈滞后,很多情况下只有在对局结束时才能得到反馈,不利于智能体进行学习和改进。

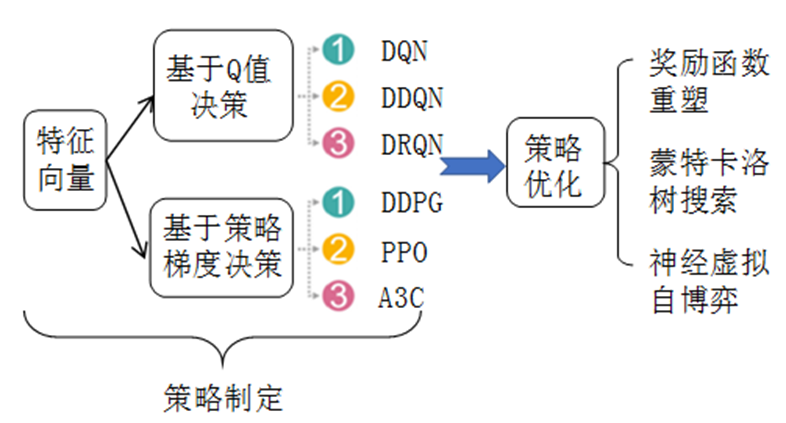

智能体做出的决策决定了对局走向,而决策质量则是影响胜负的关键。人类的决策具有主观性和片面性,带有经验主义色彩,通常只能在当前局势下取得一定优势,难以对最终胜利做出贡献。与人类决策相比,DRL实现了端到端的输出,通过神经网络直接给出决策结果,并通过对抗来优化网络参数,不断增强决策质量,提升智能体的决策水平。本文从策略制定和策略优化2个方面讨论智能体的决策。决策与优化如图4所示,其中,DDQN为双重深度Q网络;DRQN为深度循环Q网络;DDPG为深度确定性的策略梯度;PPO为近端策略优化;A3C为异步优势动作评价。

图4 决策与优化

3.2.1 策略制定

目前,DRL主要分为基于值函数与基于策略梯度2类算法。基于值函数DRL算法的典型代表为DQN,以及在DQN基础上提出的DUEL、DRQN和DDQN等一系列变体。DQN不直接输出策略,而是计算当前态势下每个动作的Q值,Q值反映了选取该动作后的未来累计奖励的期望值,因此Q值代表了对未来的评估与预期,Q值越大表明智能体越有可能在对局中取胜。陈希亮等提出基于DQN的陆军分队战术决策求解框架,采用自然DQN算法对策略进行求解。DouZero则采用了深度蒙特卡罗方法,其本质也是为了求得Q值,实现策略的准确评估。为了使策略收敛到最优策略,基于策略梯度的DRL算法通过计算期望总奖励关于策略参数的梯度来更新策略参数,最后以端到端的方式直接输出最优策略,省去了许多中间繁琐步骤,因此基于策略梯度的DRL算法比DQN更受青睐。基于策略梯度的算法包括行动者评论家(AC)方法、DDPG算法、循环确定性的策略梯度(RDPG)算法和A3C算法等。在兵棋对抗方面,李琛等构建了基于Actor-Critic框架的多算子分布执行集中训练的行动决策模型;张振等提出了使用监督学习训练智能体,研究了基于PPO的对抗算法。此外,AlphaGo与AlphaStar均采用了AC框架输出策略,先采用监督学习方式训练一个监督学习网络,再在该网络基础上通过自博弈进行策略网络训练,从而有效提高了训练效率。

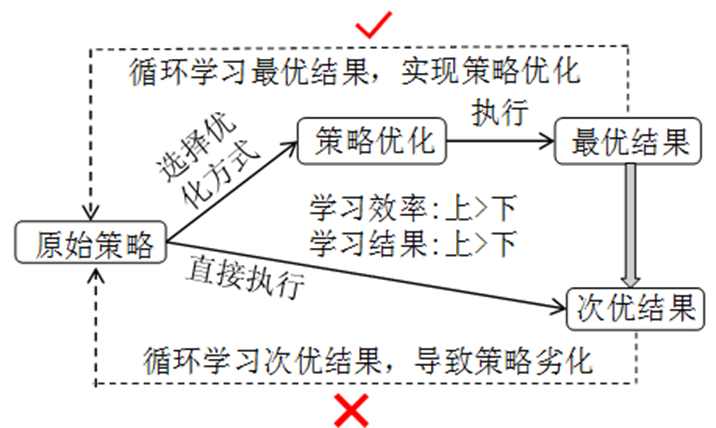

3.2.2 策略优化

策略优化能使智能体免于次优结果带来的策略劣化,跳脱出局部最优的困境,使得最终的策略性能得以改善,其原理如图5所示。DRL的最终目标是使全局奖励最大化,奖励反馈很大程度上决定了决策质量,通过正反馈奖励与负反馈奖励,智能体可以知道在接下来的任务中如何决策,即选择奖励值大的动作而避免选择奖励值小的动作。因此,奖励值设置尤为重要,在面对对局时间长、奖励反馈稀疏的对抗中,智能体由于长时间未得到反馈,收敛到最优决策的效率较低,甚至可能会陷于局部最优解状态。为了解决奖励稀疏问题,文献对奖励函数进行了重塑,奖励函数根据算子和目标夺控点的距离变化而变化;文献根据夺控点情况、算子血量和歼敌数量等进行奖励函数设计;文献采用逆向强化学习方式,运用既有的大量高质量范例数据来拟合奖励函数;文献使用加权时序差分(TD(λ))算法结合学习的评论家(critic)网络来减小方差,利用人类数据构造伪奖赏,引导策略模仿人类行为,缓解稀疏奖赏问题,加速策略训练;文献引入全局奖励预测模块,采用门控循环单元(GRU)建模一局中前若干个回合对整局的贡献,利用人类高手的数据进行价值预测网络的监督学习,并通过计算相邻两回合的奖励差来确定当前回合的奖励。除了在奖励函数上的优化,AlphaGo为了提高胜率,采用蒙特卡罗搜索树实现了总体策略选择,并对策略空间进行了搜索,最终确定了方案。文献提出了一种引入了神经网络的强化学习方法神经虚拟自我对弈(NFSP)算法,在自我博弈中近似均衡求解,虽然在大规模多人博弈稳定性较差,但在小规模博弈问题和简化的德州扑克游戏中表现突出。

图5 策略优化原理

3.3 协同与通信

策略的实施离不开各个智能体之间的配合,为了应对复杂多变的对抗情形,智能体需学会协作,跳出局部最优策略的陷阱。星际争霸中,智能体们需要分工合作、共同完成建筑建造以及战斗配合等关键性战略任务,同时还需要对各自战场职能进行分类,实现行动细化,如让智能体在对战过程中根据各自角色进行战术配合,或在建造采矿方面学会有序合作。智能体们想要实现上述群体协同控制的目标,需要通过信息共享、资源交换和联合对抗等手段,但目前多智体协同仍面临智能体数量增多带来的状态空间与动作空间维数爆炸、智能体之间采取不同动作的相互影响以及个体利益与团体利益协调等问题。为解决上述问题,实现多智能体协同,本文对多智能体训练方式和多智能体通信技术2个方面进行分析。多智能体通信如图6所示,其中,RIAL为增强智能体间学习;DIAL可微分智能体间学习。

图6 多智能体通信

3.3.1 多智能体训练方式

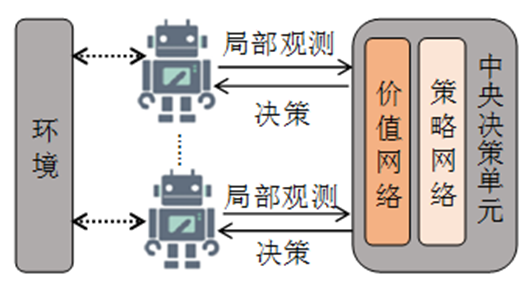

目前,多智能体强化学习训练分为全通信集中决策架构、全通信自主决策架构和欠通信自主决策架构3大类。本文以优势动作评价(A2C)算法在多智能体上的简单拓展为例,分别介绍了3种训练方式的实现。全通信集中决策架构如图7所示,中央决策单元先将所有智能体对环境的局部观测进行统筹,以此整合得到全局观测的信息,再训练联合价值网络与策略网络,从而集中决策产生联合动作,最后以通信方式将动作信息传递给每个智能体。该方式的优点是拥有全局观测信息,避免了局部观测导致的噪声,其决策更优,且可更好实现智能体的协同控制,但同时不可避免地对通信的时效性提出了挑战。

图7 全通信集中决策架构

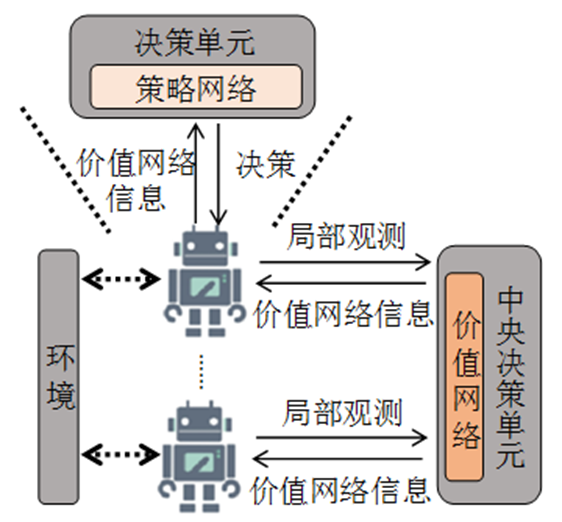

全通信自主决策架构如图8所示。中央决策单元只训练联合价值网络,并将价值网络的输出反馈给各智能体的本地决策单元,每个智能体均拥有独立的策略网络,为了提高训练时决策的准确性,各智能体间通过通信实现信息交换并整合得到全局的信息,以此做出最优决策,当训练完成后,智能体通过本地决策单元进行决策。由于训练时采用了全局信息,已经包含了对其他智能体的推断信息,因此在本地决策时涌现出了协同合作的能力。该框架由于应用了本地决策,对通信时效性要求较低,在训练完成后减少了信息收集流程,因此得到了广泛应用。

图8 全通信自主决策架构

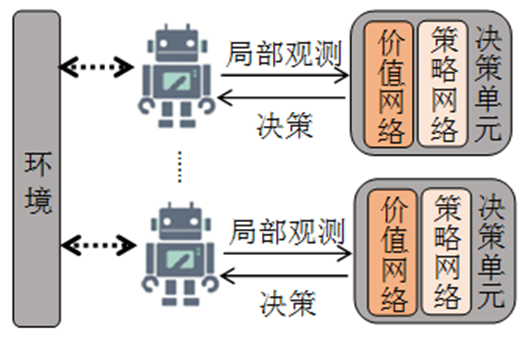

欠通信自主决策架构如图9所示。相比于前2种框架,欠通信自主决策架构放弃了对全局信息的整合,每个智能体拥有单独的价值网络与策略网络,训练过程中仅依靠自身的局部观测信息进行决策,以期涌现出协调合作的能力并最终完成任务。由于减少了通信流程,欠通信自主决策架构可以适用于任何一个多智体环境,但也产生了因信息缺失与观测噪声导致的不稳定因素。

图9 欠通信自主决策架构

3.3.2 多智能体通信技术

多智能体交流不是真正意义上的交流,而只是显式假设智能体之间存在信息的交互,并通过训练来学习如何根据对抗形式生成信息,或者确定是否要和其他智能体进行通信。训练完成后,若要运行,仍需要来自其他智能体的信息。Foerster等在多智能体强化学习中引入通信概念,采用了全通信自主决策架构训练模型,提出了RIAL算法,从而对智能体之间传输可学习的信息进行展示,此外,为了使智能体对收到信息进行反馈,Foerster等在RIAL的基础上又提出了DIAL算法,通过通信信道将梯度信息从信息接收方传回到信息发送方,形成反馈循环。Sukhbaatar等提出了CommNet算法,采用广播形式传递信息,由于采用了全通信集中决策架构,因此在大规模环境下网络维度过大且训练困难。Jiang等为了使智能体能够自主通信,提出了基于注意力机制的AtoC模型,该模型采用了全通信自主决策架构与DDPG算法,同时为了提高可扩展性,所有智能体之间共享了通信信道、策略网络和注意力单元等参数。另外,采用注意力机制进行通信的还有个性化控制连续通信模型(IC3Net)算法和目标化多智能体通信(TarMac)算法。

4 应用与挑战

人机对抗技术自其诞生起就受到了广泛关注,人与机器的较量角逐自此拉开了帷幕,从深蓝到AlphaGo系列,机器表现出的强大学习能力吸引着人们持续地探索这一片领域。尤其是AlphaGo在围棋领域取得的巨大突破,进一步推动了人机对抗技术的发展,使得DRL与人机对抗相结合的方式成为可能。

4.1 棋牌类游戏对抗

棋牌类游戏一直以来都是进行人机对抗测试的平台,棋牌类游戏对抗示意图如图10所示。2016年,谷歌Deepmind公司开发了AlphaGo系列,成功将DRL与人机对抗进行了结合,并以4∶1战胜了韩国棋手李世石,次年又以3∶0战胜了我国棋手柯洁。AlphaGo系列在围棋方面表现出的强大的想象力从侧面反映了DRL的能力。同年,文献提出的神经虚拟博弈是基于DRL自我博弈优化方法的典型代表,并在简化德州扑克游戏中取得不错表现。2020年,微软亚洲研究院发布了麻将AI suphx,采用分布式强化学习,对关于打牌策略的决策模型进行训练,Suphx和其他玩家对战了5 000多场,达到了最高段位10段,超过了平台上另外2个知名AI以及顶级人类选手的平均水平。2021年发布的斗地主AI DouZero,通过引入深度神经网络,提出了深度蒙特卡罗算法。需说明的是,由于在传统斗地主游戏中存在运气成分,因此无法像围棋一样完胜人类,但已可达到人类玩家水平,且与已知斗地主AI相比具有明显优势。

图10 棋牌类游戏对抗示意图

4.2 多人战略游戏对抗

与棋牌类游戏相比,多人战略游戏的状态空间和行动空间更复杂,且隐藏信息更丰富,因此对于智能体来说是一个巨大挑战,多人战略游戏对抗示意图如图11所示。

多人战略游戏的代表有Dota 2和星际争霸等。通常情况下,智能体不会只控制1个单位,而是需操纵多个单位进行对抗活动,如在星际争霸中需要控制单位进行采矿、战斗和建造,在Dota 2中需要控制英雄进行技能配合、线上补刀和装备购买。智能体不仅需要学习如何决策,还要学习如何协调竞争与合作的关系。即时战略游戏一直以来均受到DeepMind、Facebook和OpenAI等机构的关注,2019年OpenAI开发的Dota 2 AI OpenAI Five在和Dota2世界冠军战队的对局中获胜,在DRL算法的选择上,OpenAI Five使用的是近端策略优化+广义优势估计器(PPO+GAE)的标准设定,采用了单层4 096个单元的LSTM网络。同年,DeepMind推出了AlphaStar,采用优先虚拟自博弈和联盟训练等方法在与星际争霸2人类职业选手的挑战赛中,以10∶1的比分战胜人类选手。腾讯人工智能实验室针对多玩家在线竞技场开发了Moba 1v1 AI,且达到了99.81%的胜率。DeepMind于2019年发布了基于雷神之锤3的For the win夺旗AI,在夺旗任务中取得了高于人类的胜率。尽管DRL在即时策略游戏中表现突出,但仍需提高模型的可解释性和可泛化性,从而增强算法稳定性和算法性能,以便实现对人类的再次超越。

图11 多人战略游戏对抗示意图

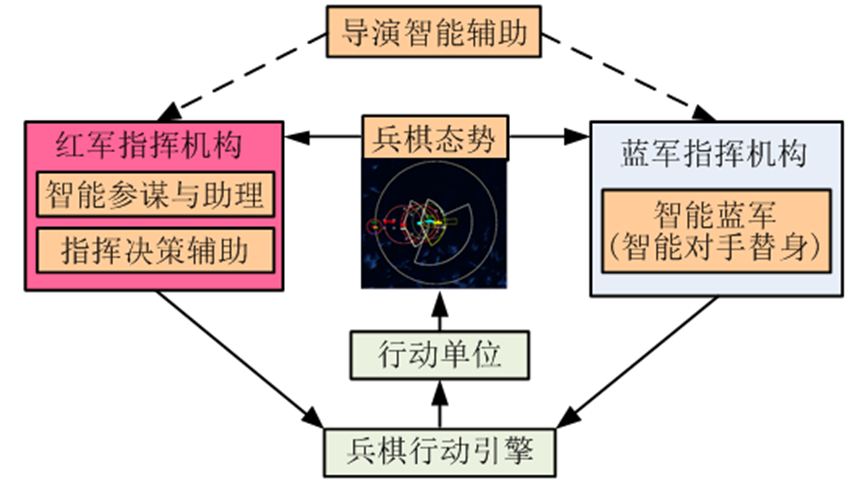

4.3 兵棋推演

兵棋推演作为战争研究和训练的手段,正逐渐从早期的手工兵棋演变为计算机兵棋。图12给出了兵棋推演示意图。兵棋推演具有非对称性、随机性和高风险性。与星际争霸不同,兵棋推演的对抗双方实力不均等,如在夺控战中,红方兵力配置一般弱于蓝方,但红方在视野方面则拥有更多优势,并可使用远程飞弹打击,而蓝方则配备了更多的地面武装,拥有更强的进攻能力。

随机性与高风险性体现在游戏的判决规则中,如武器打击时存在偏离目标概率而导致打击失败,同时一方兵力受损后未进行弥补导致风险增加,可能会使一方直接溃败。为了改善兵棋推演面临的困境,文献将分布式执行集中化训练的AC框架引入了兵棋推演,并通过简化想定进行了验证;文献提出了一种层次化和模块化DRL方法框架,将网络压缩优化与迁移学习应用其中;文献提出了一种融合知识数据和强化学习的空战编组对抗智能决策方法,并在典型作战场景中对方法的实用性与可行性进行了验证。此外,中科院自动化所搭建了人机对抗智能门户网站,可实现兵棋的机机对抗、人机对抗以及人及混合对抗,同时发布了兵棋推演AI AlphaWar,并于2020年通过了图灵测试,促进了兵棋推演的智能化发展。2017全国首届兵棋推演大赛中,中科院自动化所研制的人工智能程序CASIA-先知V1.0,在“赛诸葛”兵棋推演人机大战中与全国决赛阶段军队个人赛4强和地方个人赛4强的8名选手激烈交锋,以7∶1的战绩大胜。尽管DRL在兵棋推演方面取得了不错的效果,但随着推演的进一步升级以及推演规模的不断扩大,现有算法将会受到状态空间巨大、收敛困难和局部最优等问题的挑战,因此需通过提高神经网络的感知力与算法鲁棒性来提升对抗水平。

图12 兵棋推演示意图

5 问题与展望

本文从DRL角度出发,对人机对抗智能技术进行了讨论,阐述了人机对抗的内涵与机理,并在OODA环的基础上对框架进行了简化,即感知-决策-控制,并就人机对抗智能技术的分类与最新发展进行了归纳。从应用领域、前沿技术和面临挑战等方面对基于DRL的人机智能对抗进行了介绍。虽然基于DRL的人机智能对抗近年来蓬勃发展,在不同领域均取得了成果,但仍需解决以下关键问题:1)构建更高效快速的态势感知网络;2)提高网络鲁棒性,在不完全信息环境中保持稳定决策;3)实现网络可迁移,可针对不同对抗场景进行简化开发。

回顾人机对抗的历史,DRL对其发展起到了巨大的推动作用,本文对基于DRL的人机智能对抗研究进行了以下展望:1)条件对称/非对称的种群间人机智能对抗;2)条件对称/非对称的个体间人机智能对抗;3)条件非对称的种群与个体间人机智能对抗。通过研究同等条件下的种群与种群、个体与个体间的对抗,可以在公平的前提下分析对抗算法的性能,提高个体的竞争力与种群的协作性。通过研究非对称条件下的对抗,让智能体可以实现以少胜多和以弱胜强的战略目标。

6 结束语

人工智能的快速发展,不仅为DRL的产生奠定了基础,也为人机对抗智能化带来了契机。将两者有机结合并进行研究与分析,掌握内在原理,使得人与机器之间架起了沟通的桥梁,最终通过人机对抗实现人机协作、人机互助和共同进步的目标,使社会在政治、经济和生活等领域迈向智能化。

声明:本文来自防务快讯,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。