克雷西 发自 凹非寺

量子位 | 公众号 QbitAI学校的图书管理员,已经开始用ChatGPT来筛选带色情内容的书籍了。

根据一项新规定,美国爱荷华州的学校需要下架图书馆中包含性行为描述的书籍,但“阅读每本书并按新要求筛选根本不可行”。

在ChatGPT的帮助下,一个学区终于赶在开学前筛选出19本符合条件的书籍。

隔天,OpenAI也正式宣布将GPT-4引入内容审核系统。

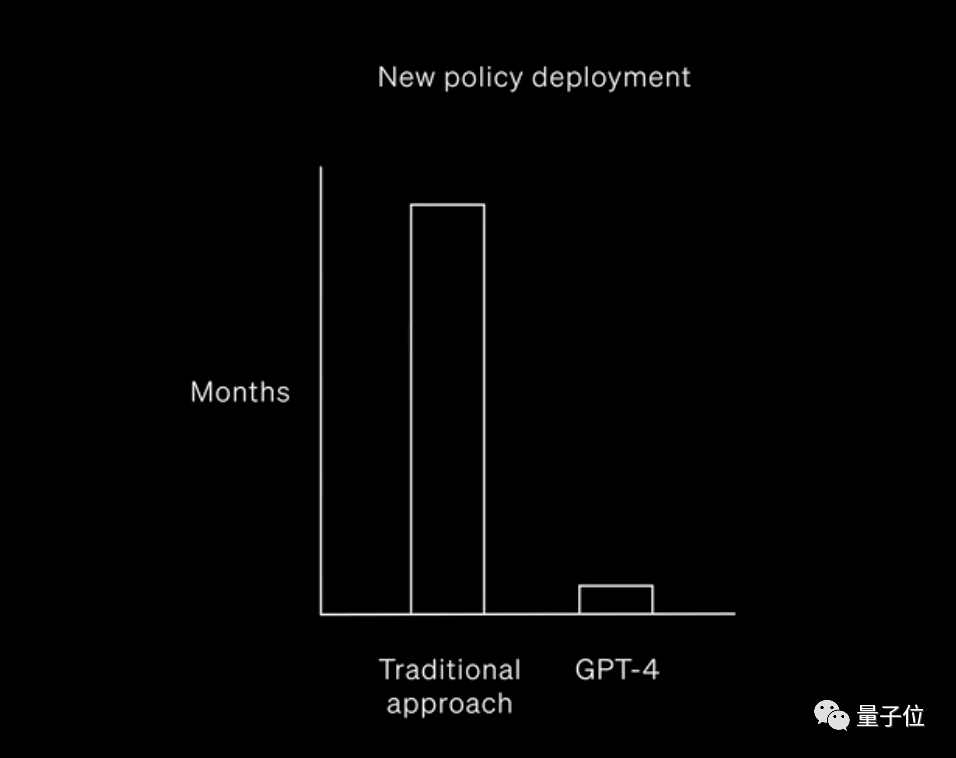

在OpenAI看来,GPT-4这项审查功能可将审查更新周期从数月缩短至数个小时,且具有更强的灵活性。

高效自动化内容审核

这项新的功能不仅在于提高效率和减轻人类工作量,还解决了人工审核中尺度不一致问题。

最重要的是,它能够避免有害内容对审核人员造成的身心伤害。

一家科技媒体的编辑Reed Albergotti做出了这样的表示:

使用大型语言模型来进行内容审查是向前迈出的一步。

这并不是因为它有多完美,而是因为它的尺度会更加一致,并且不易受到人类情感和文化差异的影响。

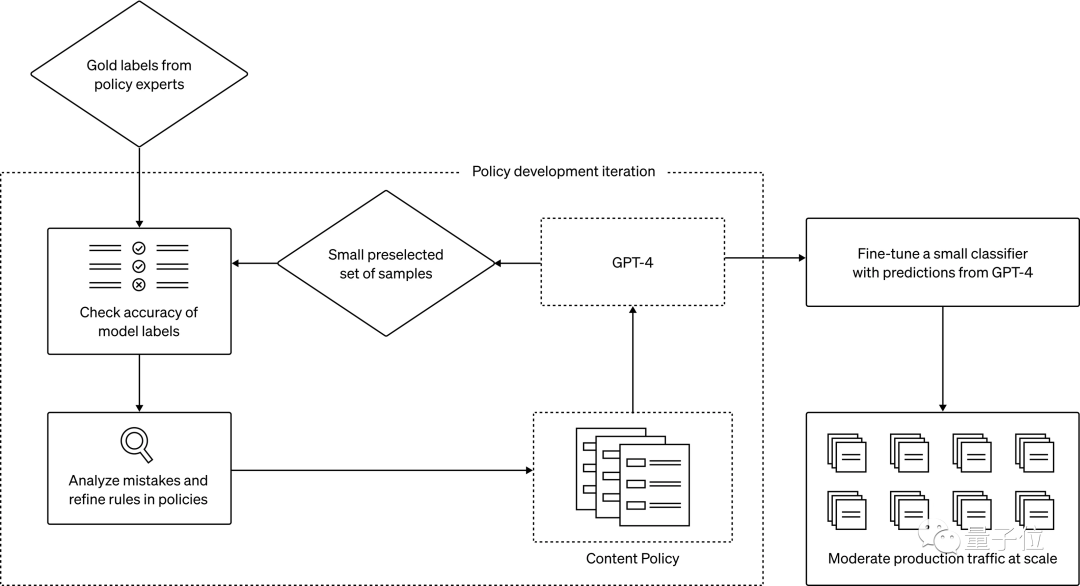

工作流程上,重点的环节是用户政策的设计,这部分是由人工主导的。

之后GPT-4会使用一些示例进行准确性检验和优化。

根据GPT-4的预测微调出小型筛选器,就可以对内容进行批量审查了。

OpenAI发言人也透露,已经有客户在用GPT-4进行内容审查,但并未给出具体名单。

此外,OpenAI正在研究将这项功能从文本审核扩展到图像、视频的鉴别 。

那么,这个功能究竟好不好用呢?

OpenAI:有信心做得很好

OpenAI总裁兼联合创始人Greg Brockman表示,这项功能「非常可靠」。

同时,Brockman还展示出了测试结果作为依据。

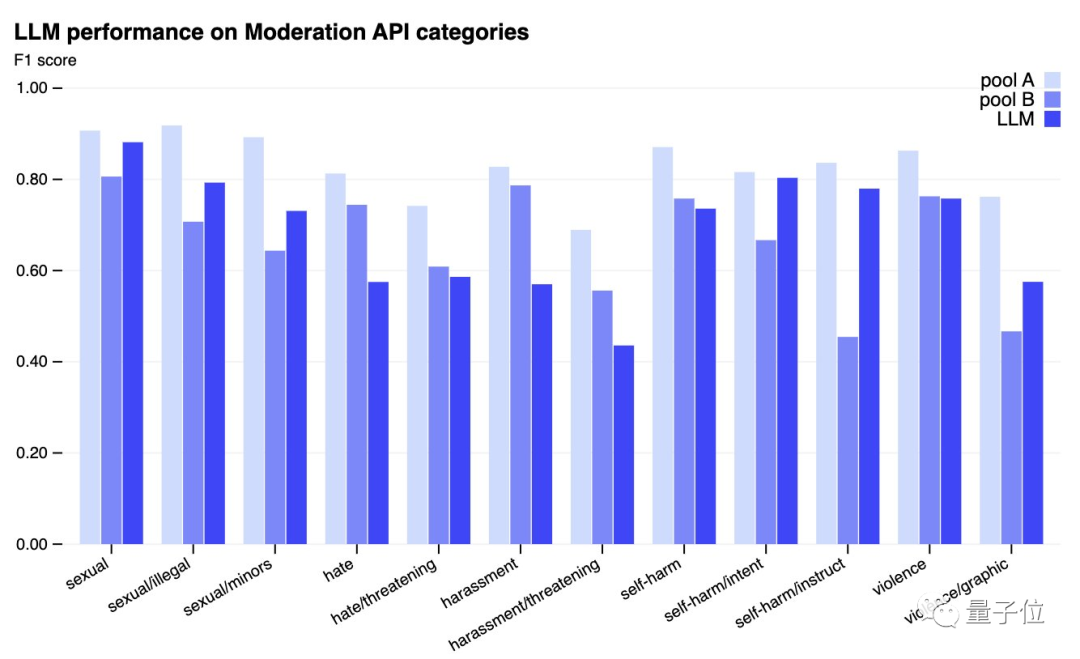

在色情、暴力等多个类型的有害内容判别上,GPT-4的表现超过了经少量训练的人类。

不过和经验丰富的审核人员相比,的确还有一些差距。

但OpenAI安全和信任部门原主管Dave Willner对著名科技媒体人Casey Newton表示,「这种情况不会持续太久」。

也有负面观点认为,总会有人想方设法钻AI规则的漏洞。

毕竟,大模型越狱事件出现了已经不只是一次两次了。

美联社的Frank Bajak更是表示,ChatGPT这样的大型语言模型「非常难以控制」。

对此,Weng也坦言,的确没办法做到100%没有漏洞,但有信心会很好。

我们无法从一开始就构建一个100%「防弹」的系统。

人们正在帮我们揪出模型中的错误,但我非常有信心它能做得很好。

One More Thing

GPT-4内容审核功能的实用性暂且按下不表,OpenAI的安全工作本身也存在很多争议。

据Time杂志消息,OpenAI此前在肯尼亚聘请数据标注人员标注有害内容的过程中,有参与者表示其中的暴力、酷刑等有害内容给他们造成了心理阴影。

新方法出台后,人类仍需要参与到内容审查工作当中,但这样的情况可能会大大减少。

参考链接:

[1]https://openai.com/blog/using-gpt-4-for-content-moderation

[2]https://www.popsci.com/technology/iowa-chatgpt-book-ban/

[3]https://www.semafor.com/article/08/15/2023/can-chatgpt-become-a-content-moderator

[4]https://twitter.com/gdb/status/1691500101187805185

[5]https://twitter.com/caseynewton/status/1691602324366786575

声明:本文来自量子位,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。