【综合编译】内容创作者希望通过毒害数据来保护他们的知识产权免受人工智能的侵害。这会破坏机器学习生态系统吗?专家警告说,专注于通过抓取已发布内容来创建人工智能模型的公司之间的军备竞赛,以及希望通过污染数据来保护其知识产权的创作者之间的军备竞赛可能会导致当前机器学习生态系统的崩溃。当人工智能(AI)大型语言模型在机器(而不是人类)生成的数据上进行训练时,会导致模型崩溃。模型崩溃的催化下,生成式人工智能的退化不可避免。这导致连锁反应,生成更不靠谱的数据,训练出更加不靠谱的模型。

在8月发表的一篇学术论文中,芝加哥大学的计算机科学家提供了一项技术,可以防御大规模抓取内容(特别是艺术品)的行为,并阻止使用这些数据来训练人工智能模型。这一努力的结果将污染基于数据训练的人工智能模型,并阻止它们创建风格相似的艺术品。

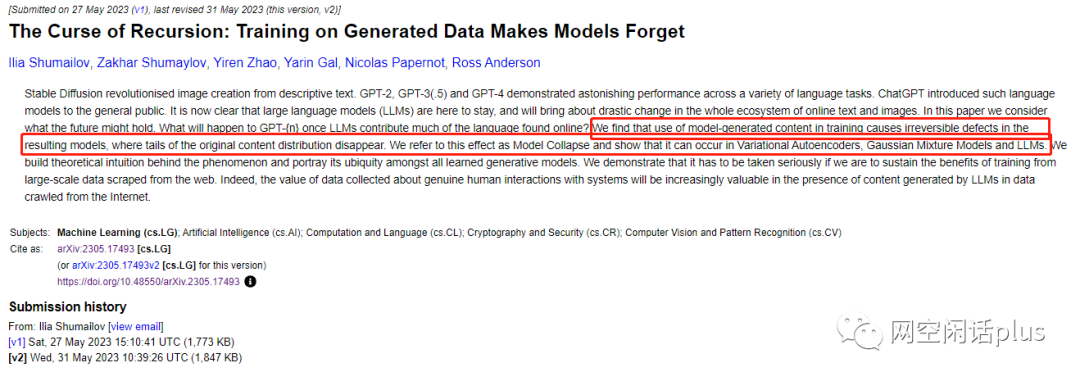

另外一篇论文则强调,这种故意污染将与人工智能在企业和消费者中的广泛采用同时发生,这一趋势将使在线内容的构成从人类生成转变为机器生成。随着越来越多的模型在其他机器创建的数据上进行训练,递归循环可能会导致“模型崩溃”,即人工智能系统与现实脱节。

数据退化不可避免

英国和加拿大研究人员的一项研究表明,当人工智能(AI)大型语言模型在机器(而不是人类)生成的数据上进行训练时,会导致模型崩溃。模型崩溃的催化下,生成式人工智能的退化不可避免。这导致连锁反应,生成更不靠谱的数据,训练出更加不靠谱的模型。有专家形象地称这为数据乱伦!

“换句话说,大规模使用[大型语言模型]在互联网上发布内容将污染训练它们的数据集,”该论文表示。

随着越来越多的人工智能生成的文本和合成数据在线发布,这给未来训练生成人工智能带来了问题。

Open AI的ChatGPT和Alphabet的Bard等大型语言模型最初主要使用从互联网上抓取的人类生成文本进行训练,并使用进一步的人类输入进行微调。

但是,越来越多的在线内容也是由人工智能模型本身创建的。

当人工智能模型从机器生成的数据而不是人类创建的数据中学习时,“即使保留了一些原始数据,在几次迭代内也会发生重大退化,”他说。

“优化缺陷、有限模型和有限数据带来的错误最终会导致合成数据质量较低。随着时间的推移,错误会变得更加复杂,最终迫使从生成的数据中学习的模型进一步误解现实。”

贝里维尔机器学习研究所(BIML)联合创始人加里·麦格劳(Gary McGraw)表示,数据退化已经发生,可能会给未来的人工智能应用带来问题,尤其是大型语言模型(LLM)。

“如果我们想要拥有更好的LLM,我们需要让基础模型只吃好东西,”他说。“如果你认为他们现在所犯的错误很糟糕,那么你就等着看他们犯下自己的错误并犯下更明显的错误时还可能会发生什么。”

数据中毒

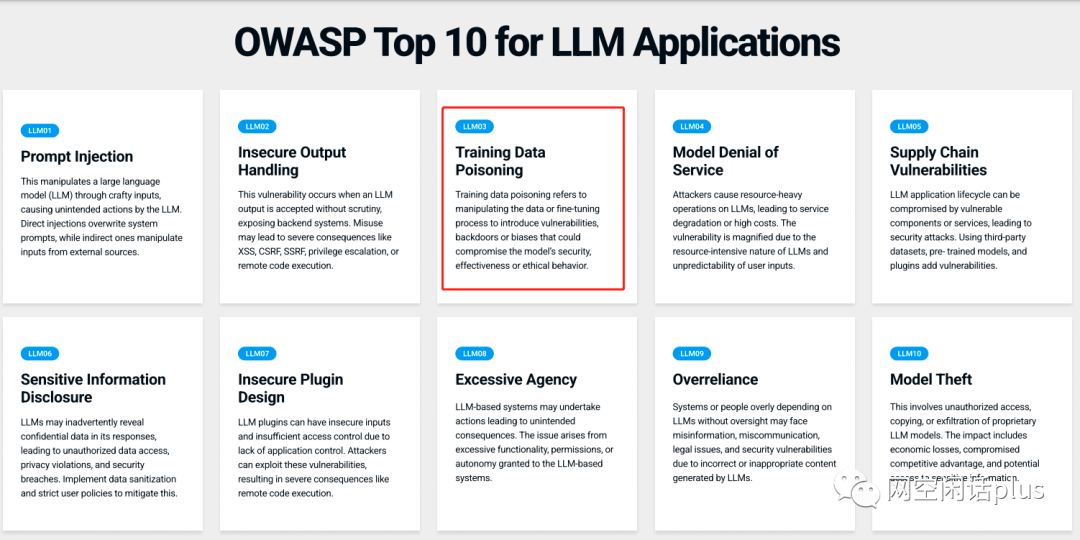

随着研究人员继续研究数据中毒问题,这一问题引起了人们的担忧。数据中毒可以是对未经授权的内容使用、对人工智能模型的攻击或人工智能系统不受监管使用后的自然进展的防御。例如,开放全球应用程序安全项目(OWASP)于8月1日发布了大型语言模型应用程序的十大安全问题列表,将训练数据中毒列为LLM的第三大威胁。

一篇关于防止未经许可模仿艺术家风格的防御措施的论文强调了数据中毒的双重性质。芝加哥大学的一组研究人员创建了“风格斗篷”,这是一种对抗性人工智能技术,可以修改艺术品,使经过数据训练的人工智能模型产生意想不到的输出。研究显示,他们的方法被称为“Glaze”,已成为Windows和Mac中的免费应用程序,下载量已超过74万次,并在USENIX安全研讨会上获得了2023年互联网防御奖。

软件安全公司Contrast Security的首席产品官、OWASP Top-10的负责人Steve Wilson表示,虽然他希望人工智能公司和创作者社区能够达到平衡,但目前的努力可能会导致更多的问题而不是解决方案。

“正如恶意行为者可能会引入误导性或有害数据来破坏人工智能模型一样,‘扰动’或‘风格斗篷’的广泛使用也可能会产生意想不到的后果,”他说。“这些问题可能会降低有益的人工智能服务的性能,也会造成法律和道德困境。”

数据鱼龙混杂(好的、坏的和有毒的)

如果不引入人类内容创作者,专注于创建下一代人工智能模型的公司将面临风险。人工智能模型依赖于人类创建的内容,而未经许可的内容的广泛使用造成了一种分离性的断裂:内容创建者正在寻找保护其数据免遭意外使用的方法,而人工智能系统背后的公司则旨在使用这些内容进行培训。

防御措施以及互联网内容从人类创建到机器创建的转变可能会产生持久的影响。根据加拿大和美国大学的一组研究人员发表的论文,模型崩溃被定义为“影响一代代学习生成模型的退化过程,生成的数据最终会污染下一代模型的训练集”。

研究人员表示,“如果我们要维持从网络上抓取的大规模数据进行训练的好处,就必须认真对待模型崩溃”。“事实上,当LLM在从互联网上爬取的数据中生成内容时,收集到的有关人类与系统的真实交互的数据的价值将变得越来越有价值。”

Contrast Security的Wilson表示,当前的大型人工智能模型——假设它们赢得了创作者带来的法律诉讼——可能会找到绕过正在实施的防御措施的方法。他说,随着人工智能和机器学习技术的发展,他们将找到检测某些形式的数据中毒的方法,从而使防御方法的效率降低。

此外,更具协作性的解决方案,例如Adobe的Firefly(它用数字“营养标签”标记内容,提供有关用于创建图像的来源和工具的信息)可能足以保护知识产权,而不会过度污染生态系统。

然而,这些方法是“一种创造性的短期解决方案,但不太可能成为长期防御人工智能生成的模仿或盗窃的灵丹妙药”,威尔逊说。“重点或许应该放在开发更强大、更道德的人工智能系统上,并辅之以强有力的法律框架来保护知识产权。”

BIML的McGraw认为,如今致力于大型语言模型(LLM)的大公司应该大力投资以防止互联网上的数据污染,并且与人类创造者合作符合他们的最大利益。

“他们需要找到一种方法将内容标记为‘我们制作的,所以不要将其用于培训’——本质上,他们可能只是自己解决问题,”他说。“他们应该想这样做……我不清楚他们是否已经吸收了这一信息。”

LLM的救赎之路

可以设想多种方法来解决LLM训练中复杂的数据问题。先发优势方法强调保留对原始人类生成数据源的访问。使用有错误的数据会给模型的学习过程带来缺陷,导致对现实的理解出现偏差。随着时间的推移,这些误解会被放大,削弱人工智能的实用性。

区分人工智能生成的数据和人类生成的数据很困难。因此,还必须考虑采用社区范围的协调方法,以确保参与LLM创建和部署的不同实体共享确定数据源所需的信息。确保原始数据中的少数群体在后续数据集中得到公平的代表也很重要,不仅在数量上,而且在其独特属性方面。

随着人工智能模型越来越多地吞噬机器生成的内容,模型崩溃的阴影变得越来越大。为了抵御令人难以忘怀的深渊并挽救这一变革性技术,迫切需要强大的数据收集、准确的注释和全社区的协调。

参考资源

1、https://www.darkreading.com/dr-tech/will-the-ai-arms-race-lead-to-the-pollution-of-the-internet-

2、https://www.darkreading.com/vulnerabilities-threats/adversarial-ai-attacks-highlight-fundamental-security-issues

3、https://cosmosmagazine.com/technology/ai/training-ai-models-on-machine-generated-data-leads-to-model-collapse/

4、https://vue.ai/blog/ai-transformation/the-degeneration-of-generative-ai/

声明:本文来自网空闲话plus,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。