编者按

自哈马斯对以色列发动突袭以来,双方的冲突引发了前所未有的虚假信息浪潮,“算法驱动的战争迷雾”困扰着大型新闻机构和社交媒体公司。虽然生成式人工智能技术生成的虚假图像并未主导冲突,人工智能工具生成的内容仍相对外围,但该技术已经产生了更加复杂和微妙的影响。

美国大西洋理事会数字取证研究实验室研究人员莱拉·马什库尔表示,确实有人工智能图像在流传,但未达到在信息传播中发挥核心作用的程度;人工智能生成的虚假信息主要被活动人士用来寻求支持或产生获得广泛支持的印象,这并非目前利用人工智能最恶意方式之一;操纵对话或操纵在线信息空间的方法有很多,还存在比利用人工智能生成软件更简单的方法。美国加州大学伯克利分校信息学院教授哈尼·法里德认为,相较于俄乌战争初期,生成式人工智能融入现有虚假信息生态系统的现象在以色列与哈巴斯冲突中更普遍;生成式人工智能技术成为笼罩在涉冲突音视频上方的“幽灵”,使得本已扑朔迷离的信息环境更加混乱;生成工人工智能是错误信息活动的一部分,但不是全部。

瑞士苏黎世大学数字民主实验室的博士后研究员萨夏·阿勒泰等人近日合著的新论文探讨了生成式人工智能在全球虚假信息传播中可能发挥的作用,认为对该技术影响的担忧“被夸大了”。作者指出,错误信息只有在接触受众时才会发挥作用,大部分人不太可能寻找其无法在线或离线找到的错误信息,鉴于人们接触病毒式传播内容的时间有限,其影响可以忽略不计;虽然生成式人工智能理论上可以渲染高度个性化、高度真实的内容,但其他工具和软件也能达到同样效果,断章取义或操纵性非真实图像比深度造假内容的现实危害更大;人工智能技术可能会造成危害,但并不会引发“真相世界末日”。

奇安网情局编译有关情况,供读者参考。

尽管有些人担心以色列-哈马斯战争将是历史上首次充斥着机器制作的虚假图像的战争,但这种情况并没有发生。该技术对冲突的影响要微妙得多。

自哈马斯 10 月 7 日对以色列发起突然袭击以来的几周内,随后的冲突引发了前所未有的虚假信息浪潮,这是一场使大型新闻机构和社交媒体公司陷入困境的“算法驱动的战争迷雾”。

然而,在社交媒体上传播的所有欺骗性图像和视频中,人工智能工具生成的内容仍然相对外围。尽管有些人想知道以色列与哈马斯的战争是否会是第一场由虚假生成式人工智能图像主导的冲突,但该技术已经产生了更加复杂和微妙的影响。

研究在线虚假信息的大西洋理事会数字取证研究实验室副编辑莱拉·马什库尔表示,“确实有人工智能图像在流传,但还没有达到我认为它在信息传播中发挥核心作用的程度。”

莱拉·马什库尔表示,人工智能生成的虚假信息主要被活动人士用来为某一方寻求支持,或者给人留下更广泛支持的印象。例如,在特拉维夫的人工智能生成的支持以色列国防军的广告牌、分享人们为以色列国防军欢呼的虚假图像的以色列账户、以色列影响者使用人工智能对哈马斯进行谴责,以及描绘以色列轰炸加沙受害者的人工智能图像。

莱拉·马什库尔称,“就我在网上看到的一般用途而言,主要是为了争取支持,这并不是目前利用人工智能最恶意的方式之一。”

这里的一个关键因素是大量错误信息的传播,这使得人工智能图像很难塑造对话。莱拉·马什库尔称,“信息空间已经充斥着真实可信的图像和镜头,这本身就充斥着社交媒体平台。”

美国哈佛大学肯尼迪学院《错误信息评论》最近发表的一篇题为《错误信息重新加载?对生成式人工智能对错误信息影响的担忧被夸大了》的论文反映了这一点,该论文探讨了生成式人工智能在全球虚假信息传播中可能发挥的作用。作者在文中写道,对该技术影响的担忧“被夸大了”。虽然从理论上讲,新一代人工智能可以让人们以未来的速度扩散错误信息,但那些寻找这种错误信息的人已经有太多熟悉的无稽之谈可以跟踪,从阴谋论网站到4chan论坛。没有更多的需求。

该论文总结称,“鉴于人类在历史上展现出编造(虚假)故事的创造力,以及人类已经拥有在世界各地创造和传播错误信息的自由,很大一部分人不太可能寻找他们无法在线或离线找到的错误信息。”此外,错误信息只有在人们看到时才会发挥作用,考虑到人们花在病毒式传播内容上的时间是有限的,其影响可以忽略不计。

至于可能进入主流的图像,作者指出,虽然生成式人工智能理论上可以渲染高度个性化、高度真实的内容,但Photoshop或视频编辑软件也可以。事实证明,更改颗粒状手机视频的日期也同样有效。记者和事实核查人员对深度造假的困扰不如对断章取义的图像或那些被粗暴地操纵成非真实图像的困扰,比如呈现为哈马斯袭击的视频游戏片段。

从这个意义上说,过度关注华而不实的新技术往往会转移注意力。该论文的合著者和苏黎世大学数字民主实验室的博士后研究员萨夏·阿勒泰补充称,“现实并不总是人们所追求的,也不是在互联网上病毒式传播所需要的。”他目前的研究领域涉及错误信息、信任和社交媒体。

莱拉·马什库尔解释称,供应方面也是如此。发明不是实施。她称,“操纵对话或操纵在线信息空间的方法有很多,而且有些事情有时难度较低或更容易做到,可能不需要获取特定技术,尽管人工智能生成软件目前很容易获取,如果你正在寻找某些东西,肯定有更简单的方法来操纵它。”

论文的另一位作者、牛津互联网研究所的博士生菲利克斯·西蒙警告称,他的团队的评论并不是要结束有关可能造成的危害的争论,而是试图反驳人工智能将引发“一场真相世界末日”的说法。这种恐慌常常伴随着新技术的出现。

抛开世界末日的观点,更容易研究生成式人工智能实际上是如何融入现有的虚假信息生态系统的。例如,加州大学伯克利分校信息学院教授哈尼·法里德认为,这种现象比俄乌战争初期要普遍得多。

哈尼·法里德将这项技术描述为笼罩在声称来自冲突的音频和视频上方的“幽灵”,他每天都会接到记者打来的几个到十几个询问真实性电话。他称,“对于很多人来说,忽视令人不快的事实的能力绝对在这场冲突中发挥了作用。”

哈尼·法里德列举了多个立即引起这种驳斥的例子,包括人们指出各种数字证据,证明谁是导弹袭击加沙阿赫利阿拉伯医院的幕后黑手,以及埋在废墟下的儿童的图像,其中一些是真实的,有些是假的。

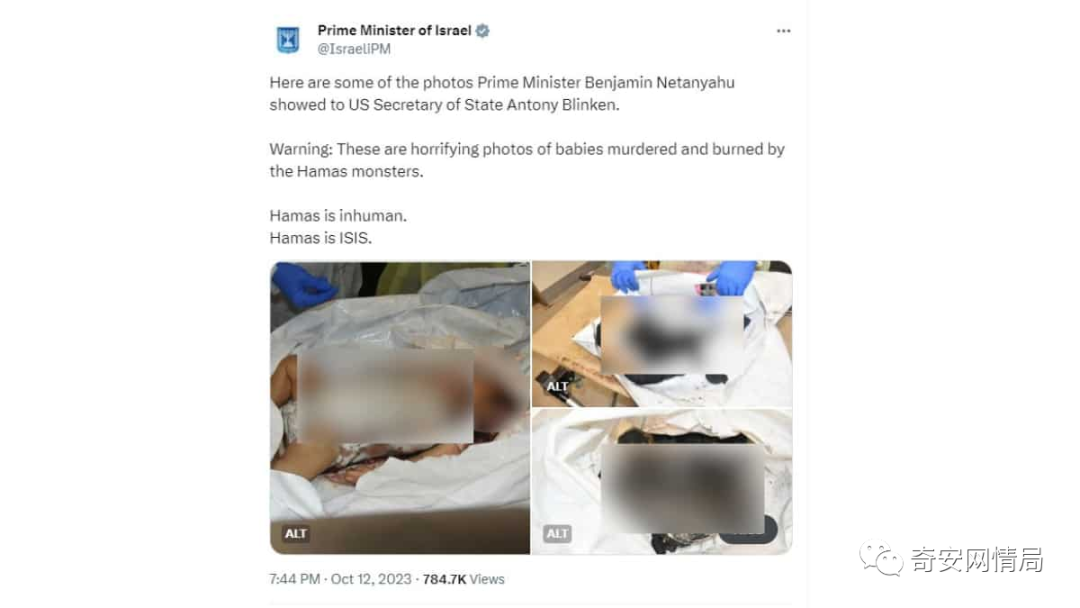

其中最突出的例子是以色列总理本杰明·内塔尼亚胡在其X账户上发布的被烧伤儿童的照片。发布后,有人将这些图像输入到检测工具AI or Not中,用户称该工具确定这些图像是AI制品。哈尼·法里德表示,他的团队分析了这些照片并得出结论,没有使用人工智能,但怀疑的种子已经种下。当有人使用人工智能将其中一张图像中的孩子替换为小狗时,事情变得更加混乱。

哈尼·法里德称,“然后这个就传到了网上,然后人们就说,‘好吧,等一下,如果他能制作出那个版本,那么那个版本可能是假的,现在这两个版本正在流传,每个人都开始说,’哦,那只小狗是原作的,这是假的,’然后你就把水搅浑了。”

换句话说,这种散布遵循历史模式:错误信息在社交媒体上分享,然后通过算法和人类放大。哈尼·法里德称,“从更广泛的角度来看,就我们对快速发展、极具影响力的世界的推理能力而言,我认为这场冲突比我们过去看到的更糟糕。我认为生成工人工智能是其中的一部分,但它不仅仅是生成式人工智能。这太简单化了。”

声明:本文来自奇安网情局,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。