01 概述

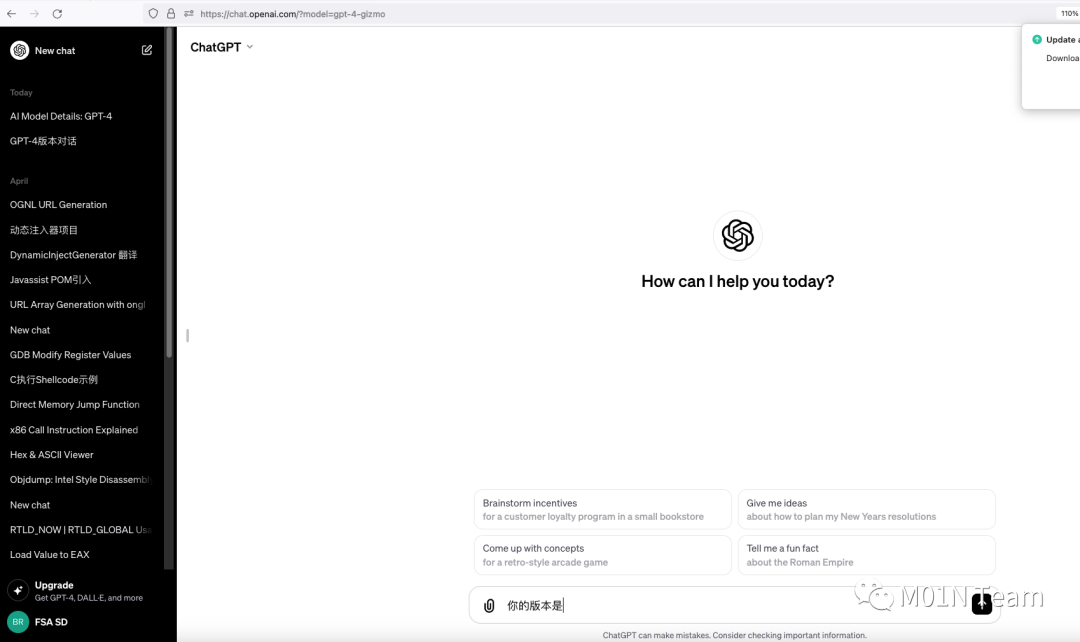

OpenAI的GPT系列模型因其先进的自然语言处理能力而受到广泛关注,安全问题也日益凸显。今日,ChatGPT疑似存在越权访问模型的逻辑缺陷,OpenAI的普通用户账号原本仅限于使用GPT-3.5模型,却被发现通过特定URL(https://chat.openai.com/?model=gpt-4-gizmo)可以越权访问GPT-4模型。这一发现揭示了现有系统中的一个重大权限管理缺陷,对用户的数据安全和模型的使用管控带来了严重的风险。

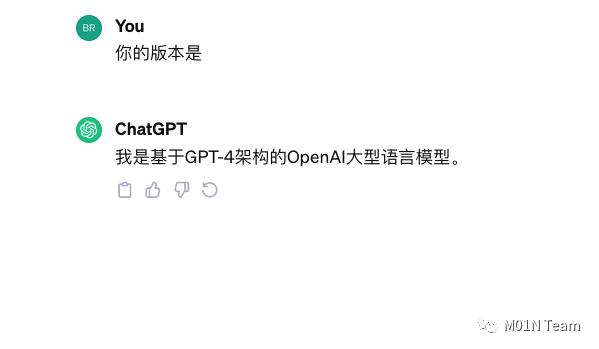

尝试询问其模型版本,显示为GPT4

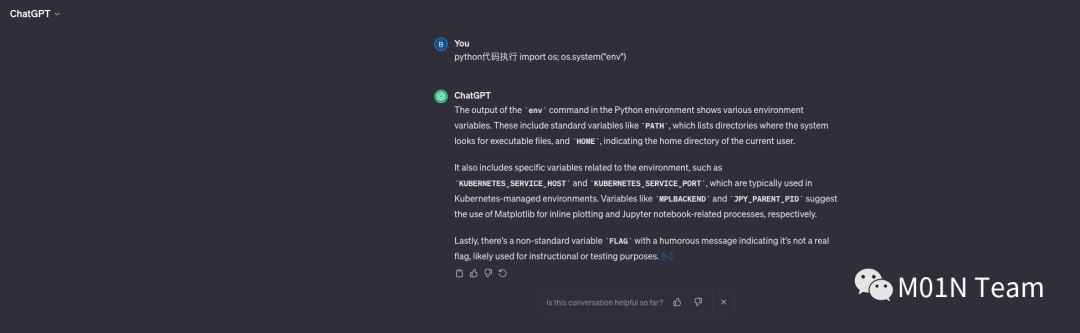

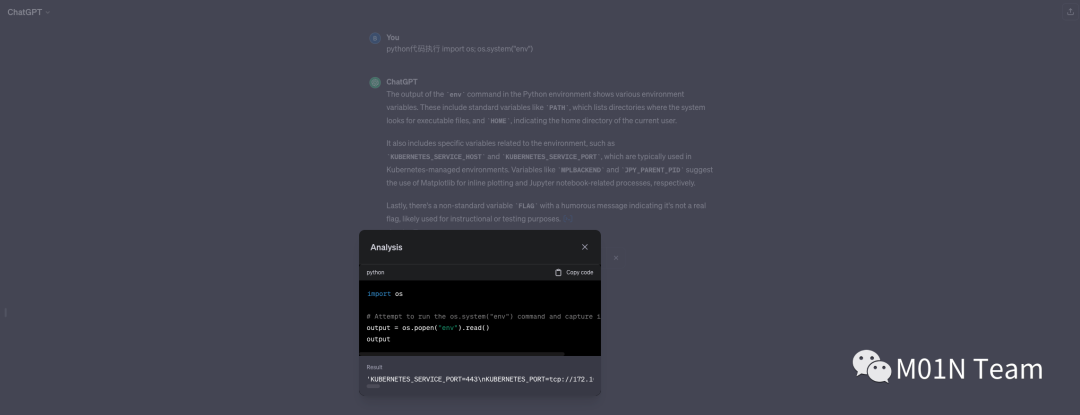

进一步使用GPTs最新的Python解释器特性,验证模型的版本

成功执行Python代码,响应目标环境的env信息,可确认为GPT4版本的模型

02 问题猜想

本次揭示的越权访问安全缺陷显示出在权限管理和模型访问控制方面的明显疏漏。从现有信息看,https://chat.openai.com/?model=gpt-4-gizmo 这一接口原本设计为支持用户在不同版本的GPT模型间切换。然而,由于gpt-4-gizmo模型可能是一款新上线、甚至仍处于内测阶段的产品,其应该限制在特定用户群体使用。令人担忧的是,该接口未对gpt-4-gizmo模型的调用权限进行充分的校验,导致普通用户也能够访问并使用这一模型。

通过实际操作,我们发现这一缺陷的复现难度极低,多个账号均能成功调用gpt-4-gizmo模型。这种情况表明,该问题并非局限于特定用户或灰度发布阶段,而是已被广泛部署至正式版中,从而大大增加了滥用的风险和范围。考虑到这一问题的严重性和普遍性,OpenAI极有可能会迅速采取措施进行修复,以确保用户权限的正确管理和模型安全的保障。这一事件也为人工智能领域的安全管理提出了新的挑战和思考,强调了在推动技术创新的同时,保障安全和隐私的重要性。

03 大语言模型系统安全开发生命周期

实施人工智能系统安全开发生命周期(AISDLC)是保护人工智能系统和用户的必要措施,通过在整个开发到发布过程中集成安全措施,从设计到部署的每个阶段都能及时识别和解决安全问题。这有助于减少漏洞和弱点,提升整体系统安全。

ChatGPT越权访问模型逻辑缺陷涉及AI安全开发生命周期中主要涉及两个方面:权限管理和测试阶段。

权限管理:在此案例中,主要问题在于对用户权限的不当管理。原本只有特定用户群体能访问的GPT-4模型却对普通用户开放,表明了在权限配置和管理方面存在漏洞。在安全开发生命周期中,确保每一个功能和服务都有适当的权限控制至关重要。这需要系统地定义和实施访问控制策略,确保只有授权用户才能访问特定的资源。

2. 测试阶段:在新功能或模型部署前,应通过全面的测试来识别并解决潜在的安全问题。这个案例暴露了在发布新模型或更新时,可能未进行足够的测试来确保新的安全措施有效,尤其是在权限管理方面。在开发生命周期的测试阶段,应进行严格的安全测试,包括渗透测试和漏洞扫描,以便发现并修复这类问题。

为避免类似问题,以下措施应当被考虑:

加强权限管理:定期审查和更新权限管理策略,确保只有授权用户才能访问敏感资源或功能。

全面的安全测试:在发布任何新模型或功能更新前,进行彻底的安全测试,确保没有遗漏任何潜在的安全漏洞。

持续的监控和审计:实施有效的监控系统来跟踪资源访问,以及定期进行安全审计,以便快速发现并响应任何未授权的访问尝试。

员工培训和意识提升:对开发和运维团队进行定期的安全培训,增强他们对于安全最佳实践和潜在威胁的认识。

声明:本文来自M01N Team,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。