2023年9月7日消息,兰德公司发布《生成式人工智能的兴起和社交媒体操纵3.0时代的到来》报告。该报告认为,目前正处于一个潜在社交媒体操纵的新时代,生成式人工智能不断的技术迭代已逐渐打破了以前对社交媒体恶意影响活动的限制。

生成式人工智能技术的扩散不仅使对手国家操纵社交媒体舆论,推动政府叙事,也可能被非国家行为者掌握以影响民众判断,对美国的国家安全构成潜在威胁。

报告呼吁美国政府、技术和政策界应该积极采取各种措施,减轻潜在风险,并强烈建议制定一个连贯、积极和广泛的战略来应对这一新威胁。

在生成式人工智能时代,如何开展媒体操纵攻防战?

编译:辛勤耕耘者

全文摘要与关键词

1.社交媒体操纵的技术迭代:社交媒体操纵1.0→2.0→3.0时代;3.0使用生成式AI,模糊真实与合成内容的界限(真实性高,替代人工,扩展成本低,可检测性较低)

2.生成式AI威胁国家安全:社交媒体操纵→恶意战术,影响受众对政治的理解,进攻型生成能力 vs 防御型检测能力

3.生成式AI在社交媒体操纵中应用:内容生成+内容交付(自主调度代理)

4.生成式AI的局限性:可被检测;模型开发部署运营成本高;目前只能处理较短文本;对社交媒体操纵影响尚不明确

5.生成式AI威胁应对措施:①技术缓解措施;②政策缓解措施(加大干预+国家安全政策);③外交缓解措施(监控对手,纳入军备控制)

6.评述:该报告将矛头对准俄罗斯等国,夸大生成式人工智能在社交媒体操纵方面的作用,弱化美国作为全球生成式AI技术引领者、社交媒体最大操纵者的身份,制造认知偏差,试图为美国进行社交媒体操纵提供便利;此外,针对生成式AI局限分析较为入理,提出从技术、政策、外交方面的应对手段具有一定可行性,为下一步相关研究和工作提供了思路。

01 社交媒体操纵的技术迭代

1.1 社交媒体操纵的发展历程

从2010年起,社交机器人就被部署用于恶意操纵社交媒体。生成式人工智能可生成文本和图像支持社交媒体操纵活动。

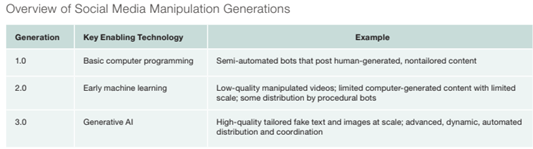

在内容生成方面,社交媒体操纵经历了三代发展:早期的粗糙伪造、更复杂的深度伪造、生成式人工智能。

社交媒体操纵1.0 使用了粗糙伪造的东西:低质量的程序机器人,具有一定自动化程度的虚假账户,可大量产生文本,但明显可以看出是合成的、虚假的,以连续、自动化的纯文本输出为标志,缺乏与用户进行有意义互动,很容易被检测到是人为制作的。

社交媒体操纵2.0 更加复杂,机器人具有更像人类的功能,包括:抓取互联网内容和简介的能力;更自然的昼夜发帖;与人类社交媒体用户互动的能力有限。更像人类的账户可以分享更复杂的虚假信息,例如,“深度假视频”可能显示一位世界领导人呼吁自己的军队投降,这种“深度假视频”可被细心的人检测到,嘴唇和面部不同步,皮肤看起来太光滑或太粗糙,总是直视前方,但共享帐户和共享的合成音频、视频或图片的逼真度增加可能会欺骗人们。在2.0中,帐户的真实性和发布的内容质量得到提高,使影响活动更难检测、更有效。第2.0代包括一些程序编程,使机器人在不同时间发布内容。

社交媒体操纵3.0 使用了生成式人工智能,技术上产生质的飞跃,模糊了真实内容与合成内容之间的界限。

与2.0相比,生成式人工智能可用于:

制作更高质量的虚假或欺骗性消息;

有可能建立一个庞大的机器人网络,看起来和行为都像人类,生成的文本、图像以及视频和音频的真实性得到提高;

大型语言模型表现出具备自主决策能力,给定一个任务,可以计划行动过程,尝试这些行动,进行修改,并决定任务何时完成;

除了生成内容,大型语言模型还可以充当端到端系统的控制模块。

1.2 生成式人工智能的特点

生成式人工智能是机器学习的高级形式,是一种流行的人工智能类型。在生成式人工智能中,大型语言模型和文本到图像模型是目前最成熟和可部署的类型。其他可能迅速成熟的包括音频、视频和音乐等。生成式人工智能打破了前两代社交媒体操纵的诸多限制,具有以下特点:

一是真实性较高。生成式人工智通过以具体的、不引起人怀疑的方式与其他账户互动,或者通过生成具体的、逼真的图片,使社交机器人可以以看起来像真正人类的方式行事。生成型人工智能社交机器人可在短时间的交流中产生显著的人类互动,但过度互动仍可能会被发现是非人类。

二是替代人工。社交媒体操纵2.0涉及更真实的内容和更大的劳动力需求之间的性能权衡。在人力资源上的投资越多就越有说服力,内容就越真实。生成式人工智能的高度真实性取代了进行社交媒体操纵所需的大部分人类劳动。

三是扩展成本更低。生成式人工智能扩展性好。社交媒体操纵3.0网络会有前期成本,但由于实现了上述劳动力替代,成本不会随着规模的扩大而增加。这种能力适用于内容生成和网络管理。

四是可检测性较低。生成式人工智能的真实性使得它比之前版本合成的虚假内容更难检测。在检测和改进生成式人工智能之间正在进行一场竞赛,但目前检测还处于劣势。

02 生成式人工智能对美国国家安全的威胁

生成式AI→社交媒体操纵→恶意战术→国家安全。报告称,对手通过生成式人工智能扩大和支持社交媒体上的恶意影响操纵,对美国构成了潜在的国家安全威胁。生成式人工智能难以检测,对恶意行为者更有吸引力,并可能会产生新的恶意战术和技术。尤其是,多种生成式人工智能的融合更令人担忧,这些模型大幅降低了创建虚假媒体的成本,媒体质量足以欺骗依靠感官决定世界真实性的用户。

主要风险在于:影响受众对政治的理解,颠覆“民主社会”。俄罗斯和伊朗等国已经开始使用生成式人工智操纵社交媒体,目前尚不清楚这些民族国家的恶意行为者是如何利用生成式人工智能的。但其风险在于,恶意行为者能够暗中影响受众对国内政治对话的理解,颠覆民主社会,对民主社会和民主进程构成直接挑战。

生成式AI:社交媒体操纵3.0。如果说俄罗斯2016年针对关键人口统计数据和摇摆州的选举干预代表了社交媒体操纵2.0,那么通过生成式人工智能则可能对2024年选举进行干预,代表了社交媒体操纵3.0。生成式人工智能需要大量的训练数据训练模型,将进一步增大社交媒体操纵风险。来自社交媒体的大量真实文本和图像可以很好地服务于训练模型。民族国家在国内拥有巨大的监控能力,能从其拥有的媒体平台获得数据,更容易获得训练数据。

俄罗斯和伊朗等国的国家恶意行为者可能会采用生成式人工智能进行恶意的社交媒体操纵,且随着技术的进一步成熟、更加普遍和更易于实现,可能会引起其他国家效仿。

进攻型生成能力 vs 防御型检测能力。在生成式人工智能时代,对进攻型生成能力和防御型检测能力之间的差距做出明确的声明还为时过早,但随着技术的成熟,生成式人工智能对检测能力提出了越来越高的要求。

03 生成式人工智能理论及应用

生成式人工智能将是社交媒体操纵中十分有用的变革性元素。社交媒体操纵可分为两部分:内容生成(例如,撰写宣传材料)和内容交付(例如,让人们阅读宣传材料)。

3.1 内容生成:“内容真实性”是大规模社交媒体操纵的最大挑战

高质量的内容是社交媒体操纵成功的必要条件;还要求内容能够引起共鸣,整体交互须像人一样。通过生成式人工智能生成大量的令人信服的“真实”内容一直是大规模社交媒体操纵的最大挑战。但随着生成式人工智能技术的发展,其生成的内容已日趋完美。

3.2 内容交付:

僵尸网络。在内容交付方面,也发生了明显变化。自2012年以来,俄罗斯等国家的国家行为者一直将僵尸网络作为大规模内容交付的主要形式。僵尸网络发布的内容是由人类制作的,在内容交付过程中,不断重复相同的内容,导致这些内容被识别和删除。

生成式人工智能不仅可提高了内容生成的质量和速度,并且会影响内容交付。

自主调度代理。大型语言模型可充当自主调度代理,创建或以其他方式获取不真实(伪造)账户,会使虚假账户产生更大的影响,具有更大的传播范围,将更“真实”的内容更好地创建动态的、可信的(合成的)人物角色,极大地提高社交媒体操纵活动的整体效果。

通过生成式人工智能可影响帐户及其内容范围,在无需大量人力投资的情况下创建大规模、人性化网络的能力将改变社交媒体操纵。

以前依靠人力的策略,如付费传播内容,对恶意行为者将不再具有吸引力。生成型人工智能擅长大规模创建可信的内容,支持大型合成行为者网络( large networks of synthetic actors),但无法保证其传递的信息会产生共鸣和影响力。

04 生成式人工智能的局限性

4.1 生成式AI缺少理解能力

大型语言模型、文本到图像模型仅是语言和图像模式丰富的数据表示,并不涉及对内容的理解。ChatGPT等大型语言模型的输出通常不准确或上下文联系不恰当,细心的读者可以察觉出其中不对的地方。类似地,文本到图像的输出通常也具有可见的异常。生成式AI并非完美,也不是人类无法检测到的。不过我们注意到,这些模型的质量正在迅速提高。

4.2 生成式AI模型的开发、部署、运营成本高

随着技术的快速发展,生成式人工智能人工智能模型的质量正在迅速提高。构建的下一代更复杂的人工智能模型也存在各种限制。创建GPT-3和GPT-4规模的大型语言模型成本昂贵;开发GPT-4耗资1亿美元且部署成本也很高,运行每天花费10万美元。未来计算能力的成本还无法预测,训练下一代更大型、更高性能的模型也花费巨大。对于非国家行为者来说,这种成本难以承受,只有决定推行这种模式的国家才能负担得起。

4.3 生成式AI模型目前只能处理较短的文本

大型语言模型的性能受架构的限制,例如建模期间文本输入的长度。当前一代大型语言模型使用变压器(transformer)架构,一次只能处理有限数量的文本。变压器在接收文本的方式上是二次型的:输入长度增加一倍,计算需求就会增加四倍,这可能会迅速超出其限制。该领域正在进行研究,截至2023年5月,大型语言模型只能对较短的文档块构建的模型进行推理,限制了对各种任务的准确性和适用性。

4.4 生成式人工智能对社交媒体操纵产生影响尚不明确

生成式人工智能对社交媒体操纵具有革命性意义,但尚不清楚社交媒体影响活动会对现实世界产生多大影响。大量证据表明此类运动产生了一些影响,但其影响程度和持续时间尚不清楚。一些研究发现,社交媒体操纵运动不会改变强烈持有的观点。其他研究表明,一些运动的影响很小。包括社交媒体操纵在内的恶意信息操作会产生深远影响,但这种威胁的严重性尚不清楚。

05 生成式AI威胁的应对措施

5.1 技术缓解措施

一是识别、归因和删除不真实的人物(账户)。内容交付(特别是不真实的账户)是社交媒体操纵的新限制因素。平台应加强监管,使恶意行为者无法开设新账户,并努力识别和删除不真实的账户。

二是增强公众对真实社交媒体内容的信心。媒体区块链系统作为一种监管和真实性的公共链,有助于确定图像或文件的真实性、产生的时间和地点。该系统将使得对文档或图像的更改可见,且可突出不真实的文档。通过媒体区块链系统可以给公众提供一种快速验证可信来源的方法。

三是限制恶意行为者采用人工智能生成的内容。虽然人工智能模型难以控制,但用于训练当前和未来语言生成模型需要大量的数据集、计算能力和熟练的技术人员进行训练,易于控制。2022年美国政府颁布的针对俄罗斯等国的人工智能硬件访问限制有助于限制恶意行为者采用人工智能生成的内容。

5.2 政策缓解措施

一是采取监管措施。创建透明、公共问责和研究人员访问规范,让对手难以获得平台并保持隐藏,是对抗社交媒体操纵的有力工具。规定威胁和平台责任的监管政策是减少平台作为社交媒体操纵传播媒介的重要一步。要求透明度和研究人员准入的监管是加强民主对抗这些威胁的关键途径。

二是加大政策干预。要求平台验证账户的用户身份,可直接打击生成式人工智能社交媒体操纵的规模优势。此外,身份验证会产生寒蝉效应,有助于缓解平台的社交媒体操纵。

三是推行国家安全政策。外向的国家安全政策有助于减轻社交媒体操纵的威胁。国防部须准备好在一个经过验证的信息环境中运行,在全部队范围进行培训和教育;国防部下属机构可以大力研究和红队等对手使用的生成式人工智能,为国家安全政策提供信息;教育联合部队识别由生成式人工智能产生的图像的方法和技能。

四是制订归属标准。政策界应讨论归属标准,美国和其他感兴趣的政府应该考虑如何支持公开认定恶意行为者,同时提高公众对这一威胁的认识,并扩大公共教育和媒体扫盲工作,包括解决生成式人工智能威胁问题。

5.3 外交缓解措施

一是与对手对话。美国可以考虑与对手就生成式人工智能和社交媒体操纵风险的主题进行对话。“二轨外交”(Track II dialogues)有助于促进双方更广泛的政策和研究界之间对话,更好地了解双方如何看待生成式人工智能的风险,以及在限制政府使用和限制国内非国家行为者恶意使用方面是否有达成一致的空间。

二是公布使用原则。美国可公开宣布其使用这一新兴能力的原则,如美国国务院2023年2月关于“负责任的军事使用人工智能和自主权”的声明,有助于澄清美国政策的直接目的,有助于减轻对手国家的一些担忧,激励其他国家考虑采用类似的原则,有利于限制生成式人工智能的扩散。

三是监控对手使用。美国应开始监控对手对人工智能生成内容的使用。虽然早期对手的应用可能是试验性的,但证实对手有利用这种新兴能力的意图,为美国和其他国家提供一个提高认识的机会。

四是与盟国和伙伴合作。美国应该开始与盟国和伙伴就新出现的风险、对手使用的证据以及潜在的对策进行接触,提高意识,分享信息,防止对手将生成式人工智能应用扩展到更广泛的目标国家。

五是纳入军备控制。美国可考虑对社交媒体操纵相关能力进行武器控制的潜力。在与对手国家关系严重恶化的情况下,还需要考虑将不受监管的生成性人工智能纳入军备控制,并开展相关政策研究。

06 评述

6.1 美国将矛头对准俄罗斯等国,夸大生成式人工智能在社交媒体操纵方面的作用,制造认知偏差

报告中将俄罗斯等国视为对手,夸大对手国家在生成式人工智能方面的研究进展和在社交媒体操纵方面的应用,污名化对手国家。美国是生成式人工智能技术的全球引领者,更是社交媒体的最大操纵者。该报告在主观上混淆视听,颠倒是非,制造认知偏差,企图塑造对美国生成式人工智能有利的发展国际环境,为下一步进行社交媒体操纵提供便利条件。

6.2 对生成式人工智能的局限性以及对策分析为下一步相关研究和工作提供了思路

正如报告中所述,生成式人工智能并不完美,深入分析了生成式人工智能的局限性,随着研究的进一步深入开展,这些局限性会逐步得到克服,为下一步研究提供了思路。报告从技术、政策和外交三个方面提出了应对生成式人工智能威胁的措施,具有一定的可行性,同时也为下一步应对和开展工作指明了方向。

参考文献:https://www.rand.org/pubs/research_reports/RRA853-1.html

声明:本文来自认知认知,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。