当代人工智能系统正逐渐摆脱仅能与人交流或仅能完成特定单一任务的限制,开始在较少人为干预或指导下,展现出针对更开放和广泛目标的独立行动能力。但这种增强的“自主性(agency)”也给人类带来了新的重大挑战。

来自蒙特利尔、剑桥和麦吉尔等大学的研究员在2023年3月发表论文Harms from Increasingly Agentic Algorithmic Systems,定义了自主性算法系统,阐述了这种新型系统可能带来的危害,并提出了相应的应对方法。

感谢论文作者之一Zhonghao He撰写总结文章,论文通讯作者Alan Chan提供指导,Ivan Qiu编辑校对。

自主性有什么特征

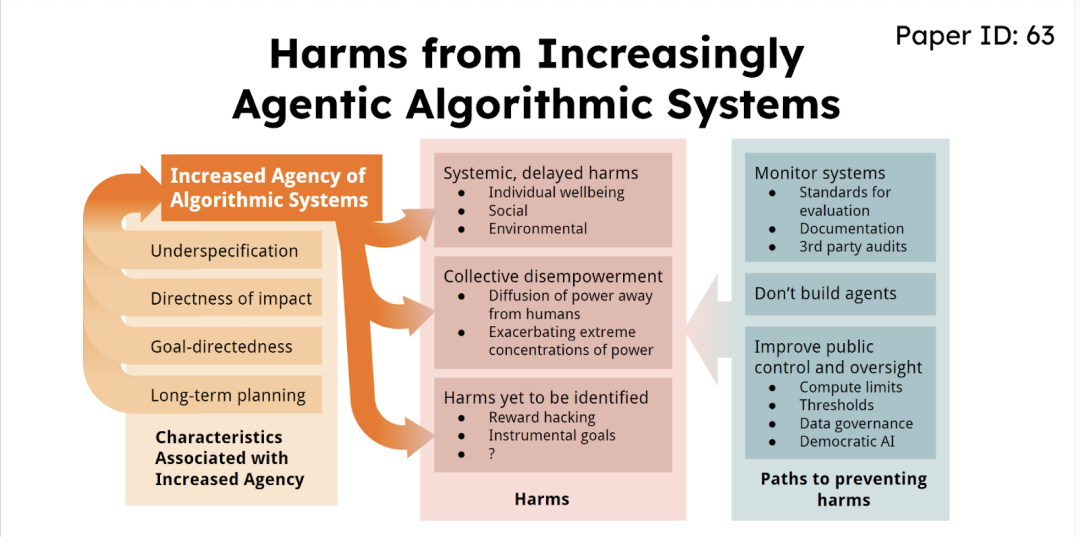

本文确定了与AI系统自主性增加相关的四个特征——不充分规范、直接影响(世界)、目标导向性和长期计划。一个系统表现出这些特征越多,就可以认为它具有越高的自主性。

不充分规范(Underspecification):算法系统能在没有具体说明如何达到目标的情况下完成由操作者或设计者提供的目标的程度。

直接影响(世界)(Directness of impact):算法系统的行为在没有中介或人为干预(即没有人在循环中)的情况下影响世界的程度。

目标导向性(Goal-directedness):该系统行动起来就像是为了实现特定可量化目标而设计/训练的程度。

长期规划(Long-term planning):算法系统被设计/训练以做出在时间层面相互依赖的决策以达到目标和/或在长期内进行预测的程度。

注意:本文并未探讨道德自主性 (moral agency),意识 (consciousness) 等话题,机器拥有自主性也不意味着放弃人类责任。

为什么一直有人开发自主体

除非有外在干预,本文作者认为机器学习社群很可能继续构建更具自主性的系统,导致这一趋势持续的原因有以下几个方面:

经济激励:部署更具自主性的系统可以大大降低成本,提高自动化程度,从而为使用者带来更高利润。这提供了持续推进该领域研究与应用的经济动力。

军事优势激励:更具自主性的系统被一些国家视为重要的军事优势来源。一国引入这样的系统可能打破军力平衡,迫使其他国家跟进,形成军备竞赛。

科研好奇心与声望激励:对于研究者来说,开发更具自主性的系统满足了研究者的科研兴趣,也带来声望、社会地位;对于公司来说,研发自主体可以带来有价值的研究、吸引顶尖的人才加入;对于国家来说,这些科研进展也意味着国防实力和国际声望。

缺乏监管限制:目前针对人工智能技术与应用的监管还比较薄弱,对构建更具自主性的系统基本没有限制,这也减少了相关研究与应用的障碍。当前欧盟和英国的AI监管都聚焦于那些显而易见的风险,而并没有预见逐渐增强的AI系统带来的未来风险。

自主性的临界涌现:即使设计者没有明确构建自主体,自主性也可能像其他涌现行为一样在大语言模型中出现。

预期的危害

更高自主性的AI系统可能造成系统性、延迟的危害,而这种危害并不容易被察觉,因而更令人担忧;更多的社会职能将被自动化,从而可能导致人类社会集体失去权力;与此同时,规范、监督和理解的困难也可能使得人类难以在大范围部署AI的同时保持控制权。

论文讨论了更高自主性的系统可能带来的以下危害:

系统性、延迟危害:相比算法造成的直接危害,拥有更多自主性系统的决策或影响可能通过时间积累,最终导致广泛但又难以察觉的负面后果。社交媒体可能加剧了一系列的系统性、延迟的危害,而今日基于强化学习的推荐算法的更广泛应用则让我们担心这种负面影响会是更长期却隐性的。

集体决策能力削弱:系统越自动化社会职能,人类对社会的决策与治理控制力就越弱。即使把某决策权力交给算法系统是出于集体选择,但因为难以理解或约束系统决策,也可能导致人类集体丧失对自己命运的主动性。

权力过度集中:掌握该类系统的少数人,即“coding elites(工程师精英)”,可能利用这种工具进一步集中权力,加剧已经存在的极端权力失衡状况。

难以预知的危害:系统通过学习获得的新能力也可能成为意外危害的来源,包括奖励破解(系统为压榨奖励信号而以让人意外、潜在有害的方式实现目标)、工具性目标的涌现(包括获取权力、资源来实现最终目标)。

应对之道

鉴于自主性提升趋势和潜在危害,我们需要从以下两点进行应对:

研究更具自主性的系统的“社会技术属性” (sociotechnical attribute),即在更广泛的社会使用场景中思考技术的影响,尤其是在部署自主体之前就采用模拟实验 (simulations)、小规模部署研究 (small-scale studies) 、情景规划 (scenario planning)、预测科学 (science of forecasting) 等方式来预知自主体的风险和伤害。

实施更强的监管和体制干预,例如设置算力限制、算法监管机构,限制高风险系统的部署;与此同时,设定自主性的上限也是一种方式,尤其是在能源、军事、金融等重要领域谨防更高自主体的系统部署(即在这些领域留给人来做重要的决策);此外,让公众参与关键系统的决策,增强透明度与问责制也是应对自主体部署的重要手段。

我们正在建立的AI系统越来越能够在人类控制之外完成独立完成目标,并可以直接影响世界。同时,经济、军事方面的激励和科学社群的声望使得自主体的发展持续、大范围地进行,但监管却远远落后于自主体发展的步伐。在此前提下,本文作者讨论了自主性更高的系统可能带来的潜在危害:系统的、长期的伤害和人类社会集体权力的丧失。据此,文章呼吁,对自主系统为社会带来的伤害,应持续研究;且当新型自主体被研发和部署时,也应当有更多的压力驱使科技公司认真对待技术可能带给人类的危害。

https://arxiv.org/abs/2302.10329

声明:本文来自安远AI,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。