文/徐纬地

人工智能(以下简称AI)技术的军事应用,既是AI应用的重要方面,也是当下军事领域的前沿问题。当前,虽然AI技术已经取得了重大突破,且仍在蓬勃发展,但AI军事应用的发展前景仍算不清晰,还有许多待思考和回答的问题。

一

AI的发展需要规范,AI的军事应用更需要规范。这似乎已经成为国际共识。然而,AI军事应用的国际规范何时出台?目前关于AI军事应用的规范和限制,正式纳入议程展开谈判的,就是联合国特定常规武器公约(CCW)框架下关于“致命性自主武器(Lethal Autonomous Weapon System, LAWS)”的谈判。这个谈判进程已有10年,但进展却不尽人意。一个原因是,究竟什么是LAWS,它与一般的AI赋能武器系统,与更广义的AI赋能军事系统之间有哪些明显的区别,现在还不能说得很清晰。

与以往的军事技术不同,AI作为一种渗透性技术,它本身并非一个固定、明确、有形的东西,它可以跟各种已有的技术和装备结合,使之效能提高。用一个可能让AI专家不喜欢的比喻:它更像是一个无形的“鬼魂”,可以附体到各种系统上,渗透到世界的各行各业和各个角落。

“AI鬼魂”从外观上不容易看见,很难识别。现在人们谈AI军事应用,谈AI赋能系统,谈LAWS,在很多情况下,所举的例子,所指的都是有一些形的东西:无人机、无人战车、水面无人艇、水下无人潜航器,或是各种作战机器人。这些无人作战平台可以跟AI赋能武器系统或军用系统划等号么?显然不行。很多无人系统中,实际上是有“人”的:有的可能是“人在回路中”(Human in the loop),有的可能是“人在回路上”(Human on the loop),有的则可能是“人在回路外”(Human outside the loop)。哪一种算是LAWS?如果人在回路外算LAWS,人在回路上或人在回路中是否可算“半自主武器系统”,是否要跟LAWS一样受控?如果某种武器系统可以通过一个开关或按钮,从人在回路外调整为人在回路上或人在回路中状态,这样的系统是否应该说又不是LAWS了呢?还是说,只要能以“人在回路外”模式作战的武器系统,就都算做LAWS?

目前正在热议的规范AI的军事应用,也都是从有形的系统入手,但是这些无人作战系统并不能与军用AI系统简单地划等号。这些无人机、无人艇、作战机器人等无人作战系统以及巡飞弹等智能弹药可能有一定的AI技术应用在其中,但有的则跟AI技术可能没有太多、太深的关系。试图通过控有形来控无形,是不是一个能成功好办法?现在还难说。

正因为“鬼魂AI”从外观上很难发现和判定,现在的AI技术研发和军事应用大国,谁都不会主动宣布自己哪些武器系统属于AI赋能系统。1现在做这样的宣布无异于自套枷锁。由此,若要制定规范,也一定要尽量落实到有形的系统上。A国可能会说,B国和C国的这个系统,D国的那个系统属于要监控、要限制的对象;B国和C国也会说,A国的某个系统必须受控制……可以肯定,那些AI军用领先的国家,都不想看到自己的系统受限制。一方面,这些国家会通过各种媒体向外宣布:我这个AI赋能武器系统算法如何如何先进,目标识别能力如何如何高,作战效能如何如何好;另一方面,当国际社会要讨论如何控制这些AI赋能自主武器系统时,相关国家就会说:我的系统都是“人在回路”的,不是全自主武器系统,媒体的宣传不作数……

这种关于哪些武器系统属于LAWS,或属于AI赋能武器系统的争吵可能要持续很长时间。各种关于AI军事应用的“国际规则、规范”也可能长期停留在“软法”状态,有一些舆论和道义影响力,但并没有多少强制约束力。

最终,可能只有当相关国家因AI军事应用吃了大亏,看到这个“AI鬼魂”不仅会带来好处亦会带来麻烦,滥用AI军事技术可能给自己造成实实在在的重大损失后,各国才会同意就AI技术军事应用的控制达成一些有实实在在约束力的协议,关于AI赋能武器系统的使用规范才可能发挥效用。

二

AI技术的军事应用和民事应用两者之间的关系也是一个需要注意的问题。当下在一些国家,AI赋能技术民事应用正方兴未艾,处于积极探索和发展过程中,不断取得进展。在这种情况下,应当注意的是,避免滥用AI赋能技术与利用AI技术促进经济发展两者之间的平衡。

在讨论限制AI军事应用时,特别是当军控专家们照搬核军控的经验,提出“防止滥用AI赋能技术”和“防止AI赋能武器扩散”时,尤其要小心。如果把关于AI技术军事应用控制和管理的概念和主张任意扩大,就可能成为限制广大发展中国家借助AI技术,缩小和消除数字鸿沟,推动自身经济发展的阻碍。在这种倾向下,正常的AI民事应用国际合作也可能被泼上“AI武器技术扩散”的脏水。

另一方面也要看到,很多情况下,AI技术在军事应用和民事应用之间就隔着薄薄的一张纸,并不是一堵墙。对于那些吃透了AI技术应用的专家和工程师来说,在这张纸的两边变换,应该不是什么特别困难的事。考虑到数字技术产品和供应链的发展,这种AI技术的军用转民用或民用转军用,的确有很大的可能性。

要防止和限制AI技术的滥用,特别是被不适当地从民用转为军用,若只是从工程技术上想办法,这个问题很可能无解。与许多其他国际军控问题一样,AI军事应用的管控和规范,虽然问题可能表现为技术,问题的解却在技术之外。根本的办法,还是努力改善国际安全环境,降低紧张局势,一方面要为AI技术军用制定更加完善可行的规则规范,另一方面要尽量降低AI技术从民用转为军用的需求。当然,关键技术环节、关键材料和关键零部件的管控,也可能会发挥一定作用。但那些被管控的对象,也很可能会想方设法突破或绕开限制。

三

目前,AI技术军事应用还处在探索尝试阶段,哪条路径能较快地通向成功,哪条路径比较曲折崎岖,现在还不太清楚。从以往军事斗争实践的经验看,也许应该考虑对AI技术军事应用的基本环境做一些基本的区分和探讨。在不同的军事斗争环境下,AI军事应用可能会有一些不同的特点和规律。

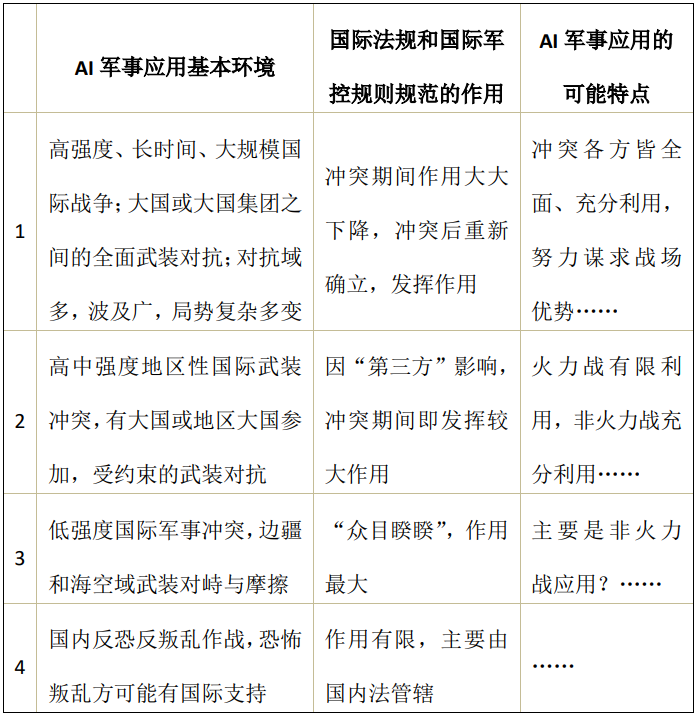

如果以武装冲突的规模、强度、范围和持续时间来看,大致可以分出下面四种AI军事应用的基本环境。

上述第一种是大规模国际战争环境,大国或大国集团在很大的地理范围和多个作战域展开充分的全面战略对抗。冲突不可避免地将涉及陆地、海洋、天空、太空和电磁网络空间。在冲突期间,虽然双方在口头上都会说自己一方是正义的,承诺将会遵守各种国际法规和国际规则,但在实际对抗中,双方都会甩开了膀子打,不会再严格履行原有的双边军控条约协定义务,一些多边国际条约协定的有效性也会受到很大冲击。战争结束后,原有的国际法规、条约、协定和规范很多也可能将要重新洗牌,重新确立。在这种情况下,关于AI技术的军事应用有可能不受限制地全方位充分展开。对AI军事应用来说,这可能是最佳实践环境。但对人类社会来说,这绝非好事。幸运的是,由于核武器等大规模毁伤性武器的存在和影响,这种环境出现的可能性并不太高。

第二种情况与当下俄乌冲突的情况有些相似,属于有限制的中高强度军事冲突。虽然有大国或地区大国参加,但由于多重制约因素的作用,冲突双方都是在有限范围内激烈对抗,可谓“拴着半条胳膊或半条腿打架”。在这种环境下的AI军事应用,也会受到一些现有国际法 条款的约束和影响。AI的军事应用可能在电磁、网络、态势感知等领域全面展开,但为避免冲突过度升级,在直接火力打击方面,AI军事应用则不得不有所收敛和控制。需要注意的是,破坏国际规则的一方会因此获得更大的收益,并对遵守规则的一方形成不平等的更大对抗优势,从而加剧国际规则的虚化、弱化、软化的风险。国际社会应当尽量防止这种情况的出现。在这方面,AI技术与核武器的结合问题,尤其值得特别关注和警惕。

第三种情况是冷战背景下的低强度国际武装冲突。全球或地区大国可以是冲突参与方,其他大国则是间接参加与之对抗。这也同当下的俄乌冲突有几分相似。这种非直接军事对抗环境下的AI技术军事应用,可能是受约束最大的应用,可能多表现为不容易被发现的非火力作战应用,例如AI技术与网络电磁对抗或太空对抗手段结合,更多体现在态势感知和情报数据处理上,为可能的火力作战升级做准备。这种AI赋能的军事较量,有可能看上去既不显眼,也不激烈。由于态势并非一目了然,对抗双方无论是吃了亏还是占了便宜,很可能都会先闷着不说,待把相关情况都搞清楚了,再决定是否公开和如何公开。

值得注意的是,第二和第三种环境下的AI军事应用,可能会带来更多的“低可视∕高可抵赖”攻击事件。2坏事有人干,却没人承认。3虽然这种攻击与AI军事应用并没有必然联系,但由于“AI鬼魂”天然具有低可视特性,当AI赋能于其他作战能力和手段后,被攻击方要抓住对方“冒烟的枪口”,就会面临更多困难。这一发展趋势将对各国军事安全决策者带来更多更严峻的挑战,也使国际安全局势更加不稳定。

第四种情况基本上是国内的军事安全斗争,主要是在国内法框架内运用军事力量,AI技术的军事应用虽然也会受到国际法规的约束,但总体上影响不大。在这种环境下,AI技术军事应用可能会使作战力量对比更加悬殊。但如果恐怖组织或叛乱势力得到境外大国的支持,情况将又另当别论。现在一些非国家武装往往大多有自己的财力来源和武器和技术装备采购渠道,也可能掌握某些AI赋能武器系统,与它们作战时,国家正规武装力量也不可掉以轻心。

在上述不同强度的军事对抗背景下,AI军事应用会有哪些特点和规律,笔者只是提出初步猜想,具体情况如何,还需要进一步探索。当然,上述各种军事对抗的背景也不可截然割裂,它们相互之间也有各种相互关联和影响。一种环境下的AI军用,也会对其他环境下的AI军事应用方式和途径带来刺激、影响和推动。

四

迄今为止,AI技术的军事应用,特别是AI赋能武器系统总体上仍处于探索和尝试状态,作战实践经验还比较少,现在要谈AI军事应用及其管控的“最佳实践”为时尚早,条件还不成熟。目前看来,各AI军事应用和管控的研究者,特别是那些AI军事应用的领先者,普遍都在致力于通过有关AI军事应用的想定的设计、编撰和推演,来牵引AI军事应用的发展。这是当下AI军事应用值得注意的特殊现象。

与一般的军事想定研发相似,AI军事应用想定的设计和编撰也要满足相关性(Relevance)、挑战性(Challenging)、可能性(Plausible)和清晰性(Clear)等要求。其中最易引起争议的是可能性,好的想定设计和编撰要照顾四个逻辑的顺畅:一是事件的时间逻辑,二是相关行为者的意图逻辑,三是相关科学技术的逻辑,四是与事件相关的国际法规逻辑。从已经接触到的各种AI军事应用的想定看,涉及面已经比较广泛,如AI赋能武器系统的研发和测试、AI赋能大型情报收集处理系统的设计和运作、AI引发国际军事摩擦的司法调查、AI赋能武器系统(作战机器人、智能地雷、水下无人攻击武器等)作战使用、使用AI赋能技术确保核武器在危机时能顺利发射,以及深度伪造技术应用引发国际冲突等。

关于想定设计、编撰及其推演,需要澄清一个问题:虽然好的想定及其推演可能有助于创造行动方案和计划,但想定推演本质上仍是一种训练方法,通过不同角色的对抗性推演博弈,想定推演可能有助于发现自方的薄弱环节和漏洞,但它并非行动方案生成工具。如果把想定和推演得出的结果直接转变为行动方案,可能误入歧途,而且会带来很大的风险。

这种通过想定设计和编撰推进AI军事应用来探索AI军事应用和管控措施的可行性和内在规律,是当下AI军事应用不普遍、实际作战案例稀缺情况下的特殊现象,既是一种无奈的补充和辅助做法,也有其合理性和前瞻性。关于AI军事应用的想定设计和编撰,需要不断根据技术和作战实践的发展调整并改进原有的构想和思路。这种以想定来牵引AI军事应用的特殊现象是否属于暂时的短期现象?它可能持续多久?现在也还不太好说。

【1】笔者就此请教过一位专门负责AI军事研发和应用的美军将领:美军会宣布自己哪个系统是AI赋能系统么?他对此倾向于做否定回答。

【2】关于“低可视∕高可抵赖”概念,参看David E. Sanger, The Perfect Weapon: War, Sabotage, and Fear in the Cyber Age , CROWN, NEWYORK 2018, p.

【3】俄乌冲突期间的北溪天然气管道被炸就是一个典型的“低可视∕高可抵赖”攻击事件。尽管各国专家对谁是肇事者已有共识,但“肇事者”也可以抛出各种混淆视听的说法。在谈到该事件的幕后黑手时,那些曾参与决策咨询的美国人士往往也会一脸真诚地说:我不知道谁干的。

声明:本文来自知远战略与防务研究所,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。