今天为大家介绍清华大学团队关于安全可信数据要素流通的一篇论文martFL: Enabling Utility-Driven Data Marketplace with a Robust and Verifiable Federated Learning Architecture,论文作者包括网络研究院硕士毕业生李琪,刘卓涛老师(通讯作者),李琦老师和徐恪老师,论文公开发表于ACM CCS 2023。

文章的主要目标是基于联邦学习技术实现安全可验证的数据交易,同时保证数据提供方的模型隐私性、数据使用方的模型鲁棒性和数据交易的公平性。该工作使用联邦学习、同态加密和零知识证明等多种隐私计算技术,提出了基于联邦学习的数据交易新范式。

文章链接:https://dl.acm.org/doi/10.1145/3576915.3623134

martFL: Enabling Utility-Driven Data Marketplace with a Robust and Verifiable Federated Learning Architecture

Qi Li, Zhuotao Liu, Qi Li, and Ke Xu

01 研究背景

随着人工智能技术在各领域的广泛应用,对高质量训练数据的需求日益增长。然而,如何收集这些数据,特别是那些未公开的私域数据,面临严峻的挑战。为此,研究人员使用“数据市场”(也被称为数据空间)的概念建模数据要素的流通,希望通过数据要素的流通共享助力数据价值的释放,从而驱动人工智能技术的进一步发展。在数据市场中,有数据使用需求的参与者可以通过访问其他参与者提供的数据,寻找与其需求相匹配的高质量数据,并与之完成数据交易。但是,随着数据隐私保护需求的增强,直接交易原始数据可能存在困难,甚至违反法律(例如GDPR、个人数据保护法等)。这迫使数据交易不得不放弃交易原始数据的传统范式,通过与隐私计算技术结合,实现仅交易数据效用而不交换原始数据的新范式。

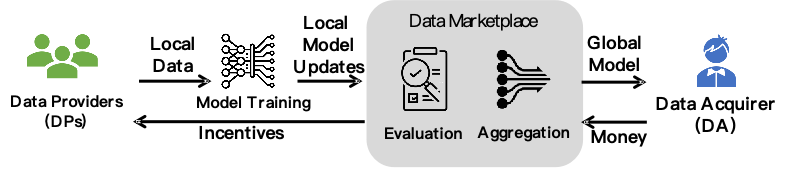

研究人员提出了以机器学习模型为载体的数据交易模式,即通过联邦学习(Federated Learning,FL)等分布式机器学习方案学习数据特征,在不交换原始数据的前提下,仅通过共享梯度等更新信息实现模型共享,从而实现“原始数据不出域,数据可用不可见”的目标。如上图所示,在这种效用驱动型的数据市场(Utility-driven Data Marketplace)中,共有三类参与方:数据提供方(Data Provider, DP)、数据使用方(Data Acquirer, DA)和交易平台。在一次数据交易中,数据使用方根据自身需求在交易平台发起数据合作任务,数据提供方接受任务并使用本地数据参与模型训练。双方在交易平台完成模型交易后,再由数据使用方进行模型聚合,并最终提供基于机器学习模型的服务。

然而,基于FedAvg等普通联邦学习框架构建效用驱动型数据市场存在隐私、安全、公平等三大主要挑战。

02 研究挑战与现有工作

挑战1:在数据交易方面,如何在保护DP的模型隐私的情况下评估其数据质量,是实现数据流通面临的首要问题。普通FL架构的模型聚合协议不允许 DA 在获取DP的模型之前评估其本地模型的质量。这在数据交易中引发了一个两难困境,即为了保护自身权益,DP不愿在获得其模型定价之前提交自己的本地模型,而DA则希望在购买本地模型之前先评估它的价值,已降低购买成本。

挑战2:在模型训练方面,由于DP可以提交任意的本地模型,普通FL架构的模型聚合协议容易受到投毒攻击。为了解决这一问题,现有的鲁棒联邦学习方案可以分为两类:服务器驱动型和客户端驱动型。前者需要DA根据本地数据设置固定的本地模型评估标准,并依据此标准对DP提交的本地模型进行打分,但该方案往往导致最终模型的兼容性不足;而后者仅通过DP上传模型的相对值来判断模型质量,没有对模型本身提出的筛选标准,存在鲁棒性不足的问题。而兼容性和鲁棒性都会影响最终模型的准确率。

挑战3:在交易结算方面,DP往往处于弱势地位。不诚实的DA可以故意贬低其数据质量,压低数据价格,否认DP的贡献,导致其合法权益难以得到保障,进而阻碍数据流通。在FL中,模型的聚合权重本质上量化了该模型在训练中的效用。因此,一个公平的交易应该基于聚合权重来分配奖励。为此,一些现有方案考虑在智能合约上执行完整的FL聚合协议以自动分配奖励。然而,这种方案迫使DA公开聚合协议,这可能引起恶意的DP发起白盒攻击;同时该方案也大大增加了数据交易的成本,降低了模型聚合的效率。

03 方案设计

为了解决上述挑战,本文提出了一种新颖的FL架构martFL,可以为效用驱动型的数据市场提供安全鲁棒且可验证的模型训练与数据交易。martFL由两个主要模块组成。第一,质量感知的模型聚合协议(Quality-aware Model Evaluation),该协议可以在保护DP数据隐私的情况下评估其数据质量,并剔除质量低下的模型,保证全局模型的鲁棒性。第二,可验证的数据交易协议(Verifiable Data Transaction Protocol),该协议保证DA和被选择的DP安全地交换奖励和模型,实现交易的公平性。

3.1 质量感知的模型聚合协议(Quality-aware Model Evaluation)

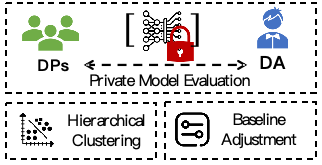

该协议共分为两个阶段。在第一阶段,如上图所示,martFL基于基准模型评估DP提交的本地模型更新量,去除其中可能存在攻击的异常模型,识别并购买高质量的模型。同时,该评估方法使用CKKS同态加密技术,可以在保护DP模型隐私的同时评估其模型的质量。

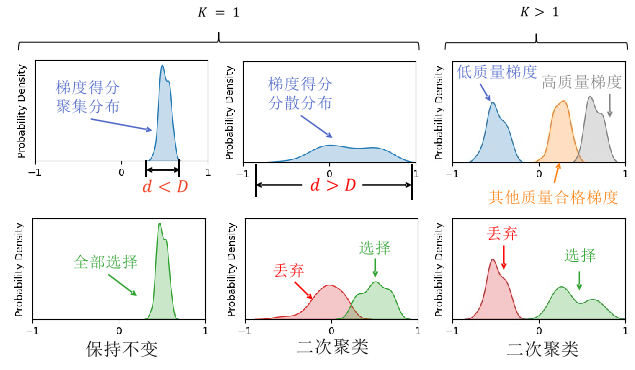

在第二阶段,martFL设计了层次聚类方法,如下图所示。该方法通过改进的Gap Statistic算法对数据提供方本地模型梯度得分进行聚类,剔除质量异常的模型并计算聚合权重,同时平衡全局模型的鲁棒性和兼容性。另外,为了降低全局模型对于DA本地数据集的过拟合现象,martFL设计动态基准调整策略,不仅提升了全局模型的准确率,同时可以防止DP的白盒攻击。

3.2可验证的数据交易协议(Verifiable Data Transaction Protocol)

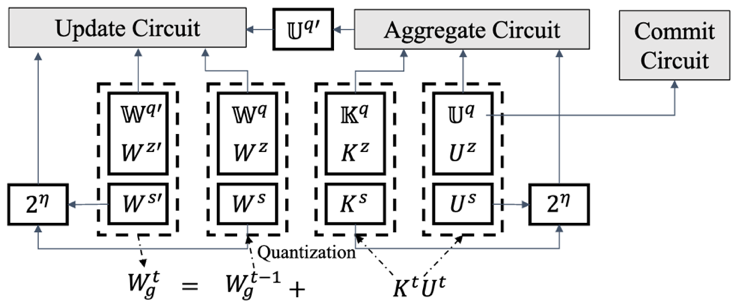

如上图所示,可验证交易协议的核心是一个零知识证明方案,该方案允许DA证明其确实使用了先前承诺的聚合权重忠实地聚合模型,同时保证不泄漏DP提交的模型参数。由于该证明可以通过智能合约被公开验证,因此DP可以根据其权重公平地申领奖励。由于交易过程基于智能合约完成,martFL可以在无需任何实时在线的可信第三方监管的情况下实现公平的数据交易过程。

与其他基于零知识证明的可证明机器学习方案不同,martFL没有直接应用零知识证明协议来证明端到端的聚合过程。因为DA对于DP本地模型的评估算法可能非常复杂,甚至包含同态加密等密码学计算;另外,参与训练的机器学习模型的可能参数量巨大,甚至可能包含上亿级的浮点数参数。以上两个问题都会为DA带来不可承受的计算负担。因此,martFL选择在端到端训练中只证明足以确保公平结算的关键计算,从而保证需证明的对象只涉及固定数量的参数而与模型的参数量大小无关,从而允许参与方在可接受的时间和计算开销内完成零知识证明计算,大大提升了方案的可用性。

具体来说,martFL首先将浮点数计算量化到无符号整数域,并针对性地设计了对于编译友好的可证明电路(如下图所示),实现精度几乎无损的量化模型聚合。另外,martFL采用可验证的抽样机制,使用可验证延迟函数生成随机种子,构建与训练模型体量无关的证明协议,在保证聚合公平性的前提下大幅度提升方案的性能。

最后,martFL将零知识证明与智能合约相结合,搭建完整的数据要素交易过程,支持用户管理、过程追责、链上验证、奖励分发等功能,保证数据评估、交易、流通全流程的正确执行和可信验证。

04 实验结果

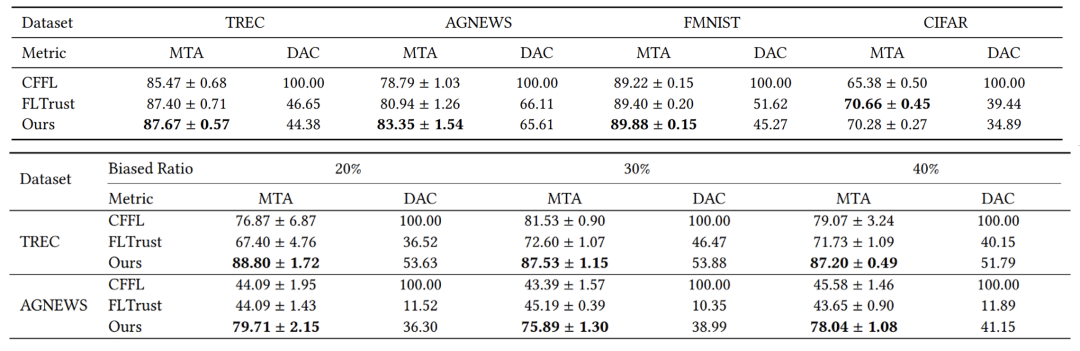

本文在准确率、鲁棒性、精度损失、系统开销等方面,对martFL进行全方面的评估。在准确率和鲁棒性的实验中,本文将martFL与2种服务器驱动型方案和4种客户端驱动型方案进行了对比,并在4个数据集上进行实验评估。

4.1 准确率及数据采集成本

实验结果显示,无论DA本地的数据集有偏或无偏时,martFL都可以取得最佳的准确性以及较低的数据采集成本。

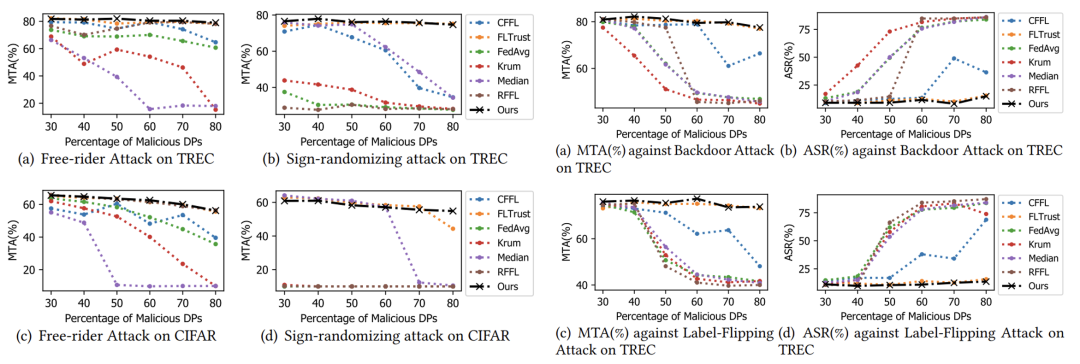

4.2 模型鲁棒性

实验结果显示,martFL可以抵御定向攻击、非定向攻击、女巫攻击等多种攻击手段,并在攻击者比例较高时,保持模型较高的准确率。

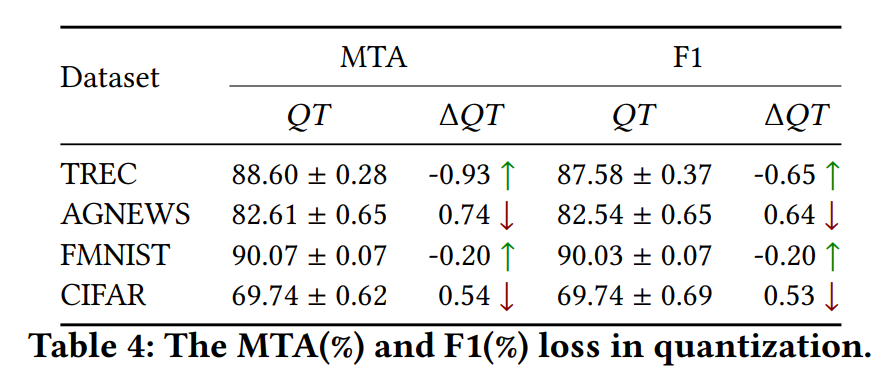

4.3 量化带来的精度损失

实验结果显示,在可验证的数据交易协议中,对模型参数的量化计算几乎不会对martFL的准确率有任何影响。

更多关于鲁棒性和兼容性分析、方案性能、交易成本等相关实验,欢迎阅读完整版论文。

05 结语

在新的数据流通范式下,数据要素与隐私计算的结合已成为驱动人工智能技术发展的关键力量。本工作提出了martFL,一个面向数据交易场景的安全可验证的联邦学习新架构,可以同时保证数据提供方的模型隐私性、数据使用方的模型鲁棒性和数据交易的公平性。我们期待未来能够通过更先进的隐私计算技术,推动数据要素的可信流通,进一步为人工智能技术的蓬勃发展提供不竭的动力。

声明:本文来自赛博新经济,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。