在AI大模型掀起的全球技术浪潮中,国产AI应用出海趋势显著增强,在全球市场具有广泛的渗透与影响。然而,面对国际市场,各国对于AI应用的监管情况各不相同。如美国和英国,采取较为宽松的监管策略,侧重于行业自律与分散监管,为AI创新提供相对自由的空间;而欧盟则实施更为严格的监管模式,旨在确保AI系统的安全性和可靠性。

走出去智库(CGGT)特约法律专家、鸿鹄律师事务所(Bird & Bird)合伙人龚钰推出AI出海合规系列文章,将对各地区的AI合规法律进行整体的介绍,并对中国AI企业在出海的过程中,所关注的合规重点问题进行总结与分析,以期为AI企业出海提供关于合规管理的基本概览。

今天,走出去智库(CGGT)刊发系列文章之一《AI新纪元:欧盟〈人工智能法〉解读》,供关注AI监管的读者参阅。

要点

1、《人工智能法案》具有广泛的域外效力。对于出海企业而言,即使其人工智能产品在国内开发并生产且该企业在欧盟境内并未设立实体,如果产品在欧盟市场投放,出海企业需要关注《人工智能法案》的有关规定。

2、在风险导向的立法路径下,《人工智能法案》提出了一系列不可接受风险的AI系统。落入该等风险的AI系统理论上不得被投放至欧盟市场。

3、《人工智能法案》对于违反其规定的特定行为制定了一系列的处罚措施,以确保人工智能的实践安全合规且可问责。

正文

随着大模型与通用人工智能的崛起,AI正重塑着我们的世界。它们不仅改变了传统的人机交互方式,更在医疗、教育、交通等领域发挥着革命性的作用。然而,随着技术的进步,对AI的规制也变得日益重要。欧盟《人工智能法案》(以下简称“《人工智能法案》”)的出台,正是对这一需求的回应。作为全球首部人工智能领域的法案,《人工智能法案》为AI技术的发展提供了法律框架,确保其在促进社会进步的同时,也能保护公民的基本权利。

对于中国出海企业而言,随着全球化战略的不断推进,了解并遵守目标市场的法律法规对于企业的合规经营至关重要。本系列文章将深入解读《人工智能法案》,并探讨其对中国出海企业的影响。

作为本系列第一篇文章,开宗明义,我们将介绍《人工智能法案》的立法背景、适用范围、AI系统的分类和监管机制。

一、 立法背景

从立法目的上看,《人工智能法案》旨在根据欧盟价值观,制定统一的法律框架、促进欧盟单一市场内安全可信的人工智能系统的开发和采用、保障欧盟公民的基本权利,以及鼓励欧洲在人工智能领域的投资和创新。

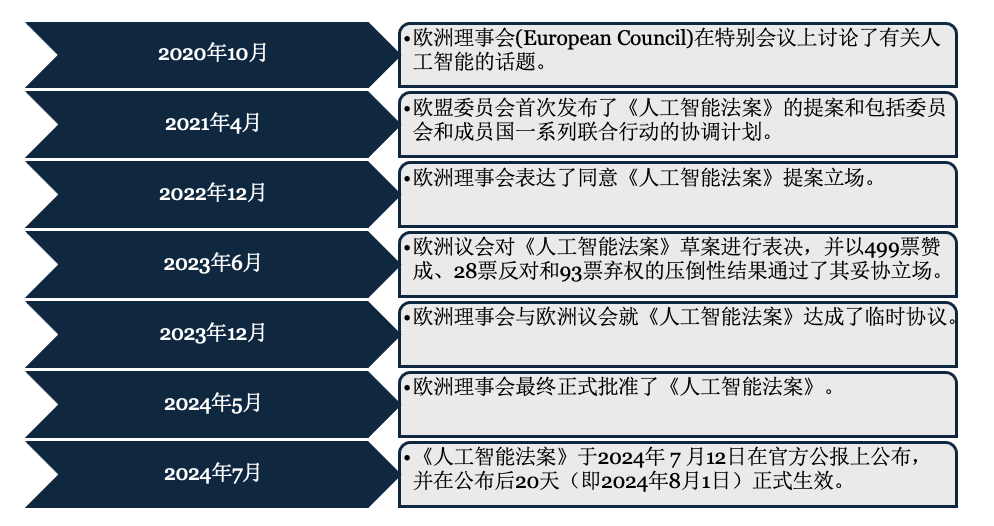

欧盟早在2020年便开始讨论有关AI技术的规制问题,但真正的加速点出现在2022年末——ChatGPT的横空出世展现出AI在自然语言处理方面的巨大潜力,这一事件也成为了推动欧盟加快《人工智能法案》立法进程的催化剂。为了更清晰地展示这一立法过程的演变,我们制作了一个简要的时间表:

在《人工智能法案》正式生效的现下,如何应对《人工智能法》提出的监管要求,落地合规方案,是相关企业面临的现实挑战。

二、 法案适用范围

从立法结构上看,与《通用数据保护条例》(General Data Protection Regulation)类似,《人工智能法案》也采取了横向立法模式,覆盖金融、医疗、内容、教育、能源、运输、司法等各个行业领域。我们注意到,《人工智能法案》在适用的客体范围、主体范围、地理范围三个维度均具有广泛性。

广泛的人工智能类型:《人工智能法案》对“人工智能”的定义较为宽泛,指代以机器为基础的系统,它能够以不同程度的自主性运行,并可能在部署后表现出适应性,而且为了明确或隐含的目标,它能够从其接收的输入中推断如何生成输出,如预测、内容、建议或可影响物理或虚拟环境的决定。基于该定义,当前被广泛使用的虚拟助手、推荐系统、搜索引擎、自动驾驶、语音识别、医疗诊断、股市分析、语言翻译等产品都可能落入“人工智能”的范畴。但需要注意的是,《人工智能法案》原则上并不适用于军事、国家安全、研究和非专业目的的人工智能系统。

角色广泛:从规制的主体上看,法案涵盖了从AI系统的开发者、部署者、进口商、分销商到产品制造商,以及授权代表等多种市场参与者。我们将在本系列的第三篇文章中进一步分析不同角色在《人工智能法案》下的对应义务。

域外效力:《人工智能法案》具有广泛的域外效力。具体而言,该法案适用于在欧盟市场上投放或提供使用的人工智能系统的开发者,无论这些开发者是否在欧盟境内设立或位于欧盟;该法案也适用于在欧盟境外设立或位于第三国的AI系统开发者和部署者,只要其人工智能系统产生的输出在欧盟被使用。因此,对于出海企业而言,即使其人工智能产品在国内开发并生产且该企业在欧盟境内并未设立实体,如果产品在欧盟市场投放,出海企业需要关注《人工智能法案》的有关规定。

三、 AI系统的分类

1.分类标准

《人工智能法案》引入了一套适度且有效的人工智能系统约束规则。具体而言,该法案遵循基于风险的方法(Risk-based approach),对人工智能系统进行分级,根据人工智能系统可能产生的风险的强度和范围,将人工智能划分为四个等级,并为不同等级的人工智能创设了不同的义务,如下图所示:

此外,《人工智能法案》还考虑了通用人工智能模型(General-Purpose AI models或GPAI模型,包括大型生成式人工智能模型)可能产生的系统性风险。这些大模型可用于完成各种指示,并正在成为欧盟许多AI系统的基础。如果这些大模型过于强大或被广泛使用,其中的一些大模型可能会对欧盟市场带来系统性风险。例如,被滥用于网络攻击,或是在许多应用程序中向不特定公众传播有害偏见。基于该等考量,最终版本的《人工智能法案》相较最初的草案稿新增一章用于明确GPAI模型开发者的义务。

2.不可接受风险

在风险导向的立法路径下,《人工智能法案》提出了一系列不可接受风险的AI系统。落入该等风险的AI系统理论上不得被投放至欧盟市场。该等系统可能会以实质性扭曲人类行为为目的或达到类似效果,因此如果将这些AI系统投放市场并投入使用,可能对人类造成重大伤害,特别是对身体、心理健康或经济利益产生严重的负面影响,故应予以禁止。

根据最终生效的《人工智能法案》版本,不可接受风险的AI(即被禁止的AI系统)包括以下类型:

潜意识操纵:例如,AI在人们不知情或不同意的情况下影响人们支持或反对某政党;

利用人的弱点致害:例如,带有语音助手的产品可能误导未成年人从事危险活动;

通用社交评分:使用AI根据个人特征、社交行为对个人进行评分;

预测警务:根据个人特征评估个人未来犯罪的风险;

公共场所实时远程生物特征识别:生物特征识别系统属于此类,但执法部门可在司法批准和委员会监督下使用除外;

评估人的情绪状态:这适用于工作场所或教育领域的人工智能系统。但是,如果出于安全目的(例如检测驾驶员是否睡着),情绪识别可能备归类为高风险;

根据敏感特征对人员进行生物识别分类:以推断自然人的种族、政治倾向、工会成员身份、宗教或哲学信仰、性生活或性取向;

远程的实时生物识别系统:执法部门在公共场所进行实时远程生物特征识别,但该等系统在严格限定的场景下可被例外的使用。

3.高风险

高风险AI系统是《人工智能法案》着最多笔墨规定的一类系统,此类系统可能对健康、安全、基本权利和法治构成重大威胁。高风险AI系统可以分为两类:

受欧盟相关安全立法规制(参见《附录一》)且需要开展第三方合格性评估(third-party conformity assessment)的AI系统。换言之,如果某AI系统是一个专门的AI产品或某个产品中重要的安全部件,并且在它投入市场之前,需要通过一个独立的第三方机构进行合格性评估,那么该产品属于高风险AI系统;以及

《附录三》中专门规定的高风险系统:《人工智能法案》的《附录三》列举了以系列高风险AI系统的用例,包括用于生物识别、关键基础设施、教育、就业、基本服务、执法、移民和司法的人工智能系统。但是,用于生物识别身份验证、检测金融欺诈或组织政治运动的AI存在一些例外情况。

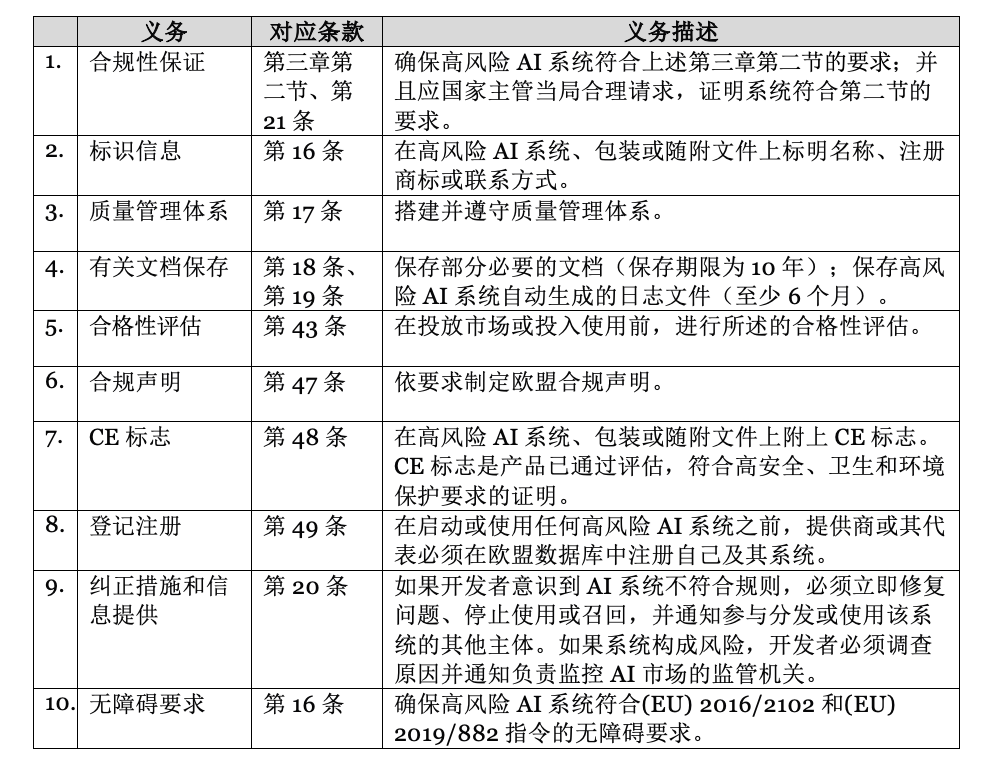

《人工智能法案》第三章第二节对高风险AI系统提出了一系列安全保障要求,具体包括搭建完善的风险管理制度、确保数据训练和治理的合规性、准备技术文档并定期更新、自动记录AI全生命周期事件、确保产品的透明度、允许人类有效监督,以及保证系统准确、稳健和安全。此外,《人工智能法案》对高风险AI系统产业链中的不同主体施加了不同的合规义务,以高风险AI系统开发者为例,其主要合规义务如下表所示:

除对开发者进行规制外,《人工智能法案》还对部署者、进口商等主体需要履行的义务作出明确规定,更多不同主体对应的具体合规义务请参见我们本系列第三篇文章。此外,《人工智能法案》还设置了一套风险识别与汇报的监管机制,包括通知、报告、公告等,以保证受规制的主体能够履行其相应义务,以及问责机制的有效性。

4.有限风险

有限风险(Limited risk)AI系统是那些在某些情况下可能会对用户或社会造成一定风险,但这些风险相对较低,不需要特别严格的监管措施。这些系统在使用过程中,如果透明度不够或功能不明,有可能对用户造成轻微的误导或困扰,但不会像高风险系统那样对健康、安全、基本权利和法治构成重大威胁。此类系统包括但不限于:

聊天机器人:用于客户服务或信息查询的自动化系统。

情感识别系统:用于识别人的生物特征或情绪反应,进行客户服务或市场研究等。

推荐系统:用于在电子商务平台等提供商品或服务推荐。

生成或操控内容的AI系统(如deepfake):用于生成虚拟图像、音频或视频内容。

《人工智能法案》对有限风险AI系统的监管旨在确保其在提供便利和创新的同时,也能够保护用户的基本权利和利益,这主要通过加以透明性义务(Transparency obligations)来实现。有限风险AI系统在首次使用时应提供清晰可辨的信息,使用户无障碍地了解其基本功能和目的等,从而避免误导用户或产生误解:

互动告知:当用户直接与AI系统互动时,系统必须清楚地告知用户正在与AI系统互动,例如,聊天机器人应明确表示其为AI系统。

内容标识:对于生成或操控内容的AI系统,这些系统的输出必须标识为人工生成或操控的,并且标识应是机器可读的

情感和生物识别:如果AI系统用于情感识别或生物识别分类,系统必须告知用户该功能正在被使用。

5.最小风险

最小风险(Minimal risk)AI系统是那些GPAI模型、不可接受风险、高风险或有限风险类别以外的一般AI系统。这些系统不会对用户的健康、安全或基本权利造成重大威胁。这类系统包括大部分常见的AI应用,比如:

文字处理软件:如用于拼写检查和语法纠正的AI系统。

垃圾邮件过滤器:用于电子邮件系统中的自动垃圾邮件检测和过滤。

简单的推荐系统:如视频流媒体平台上的内容推荐算法(如果这些推荐不会对用户产生重大影响)。

《人工智能法案》对最小风险AI系统的监管相对宽松,允许其自由使用。《人工智能法案》鼓励企业自愿遵守一些行为守则,确保AI系统的公平性、非歧视性和透明性。

四、 监管机制

1.违法后果

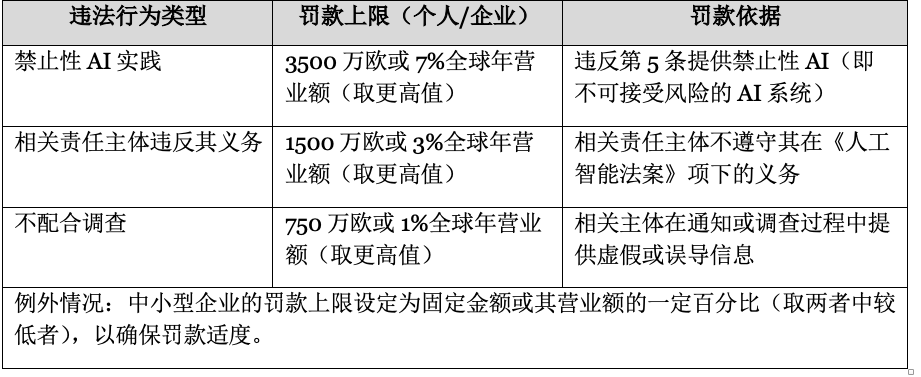

《人工智能法案》对于违反其规定的特定行为制定了一系列的处罚措施,以确保人工智能的实践安全合规且可问责。这些处罚措施又根据违法行为的性质、严重性,以及违法主体的体量而有所不同,如下表所示:

2.执法机制

根据《人工智能法案》,各成员国至少应当设立或指定至少一个市场监督管理机关作为成员国监管机关,负责合规监测和执法监督等职能。各成员国监管机构将实际负责监督执行关于AI系统的监管要求和处罚,包括对AI系统进行评估、要求AI系统运营相关主体提供信息和采取措施,以及实施处罚。

此外,就欧盟层面而言,为保证《人工智能法案》的执行,欧盟委员会在其内部设立了人工智能办公室(AI Office)负责法规解释、合规监测、执法监督、国际协调等职能。人工智能办公室的主要职责包括:

实施监督任务:人工智能办公室作为欧盟委员会的内部机构将实际负责监督执行GPAI模型的监管要求和处罚,包括对GPAI模型进行评估、要求模型开发者提供信息和采取措施,以及实施处罚。

系统风险预警:当GPAI模型在欧盟层面构成可识别的风险或符合某些风险标准时,人工智能办公室会收到来自科学小组的合规警报。收到警报后,人工智能办公室可评估和处理已识别的风险。

出台实施指南:人工智能办公室还将利用专业知识促进法案的理解和适用,包括制定AI相关的行为准则、指南文件、关于基本权利评估的问卷模板等。

除了委员会层面的监管要求,《人工智能法案》还设置了一套机制促进成员国之间的协调与合作,具体包括:

通知机关建立:每个成员国必须设立至少一个通知机关(notifying authority),负责制定和执行评估合格性评估机构的程序,并对这些机构进行监督。通知机关需要配备足够的专业人员,并具备信息技术、人工智能和法律等领域的专业知识。

市场监督:成员国的市场监督机构可以请求欧盟委员会的协助,以执行法规下的任务。

人工智能监管沙盒:成员国应建立监管沙盒,为AI系统提供开发、培训、测试和验证的受控环境。所谓监管沙盒是指由监管机构创建的框架,它允许公司和创新者在受控的环境中测试和开发新产品、服务或商业模式。监管可以在沙盒中提供指导和监督,以降低与基本权利、健康和安全相关的风险,并促进跨境合作和监管学习。

违规行为的报告与举报者保护:成员国应按照Directive (EU) 2019/1937的规定,建立机制报告违规行为并保护举报者。

注释:

1. Regulation (EU) 2024/1689 of the European Parliament and of the Council of 13 June 2024 laying down harmonised rules on artificial intelligence and amending Regulations (EC) No 300/2008, (EU) No 167/2013, (EU) No 168/2013, (EU) 2018/858, (EU) 2018/1139 and (EU) 2019/2144 and Directives 2014/90/EU, (EU) 2016/797 and (EU) 2020/1828 (Artificial Intelligence Act) (Text with EEA relevance).

2. https://ec.europa.eu/commission/presscorner/detail/en/QANDA_21_1683

3. https://digital-strategy.ec.europa.eu/en/policies/ai-office

专家简介

龚钰

走出去智库(CGGT)特约法律专家

鸿鹄律师事务所(Bird & Bird)合伙人

龚律师领导鸿鹄律师事务所中国的数据保护和网络安全团队。他在数据保护、网络安全以及科技、媒体、电信相关的监管及交易方面经验非常丰富。他曾为来自多个行业的中国和跨国客户提供境内外法律服务,擅长解决行业相关的复杂法律问题。龚律师的观点经常被媒体引用,并且作为业内认可的作者发表TMT及数据相关文章。

龚律师毕业于曼彻斯特大学,并获得法学学士学位。他拥有中华人民共和国法律职业资格和美国纽约州律师执业资格。他还是国际隐私专业人员协会成员,持有CIPP/E、CIPP/US 和CIPM证书。

声明:本文来自走出去智库,版权归作者所有。文章内容仅代表作者独立观点,不代表安全内参立场,转载目的在于传递更多信息。如有侵权,请联系 anquanneican@163.com。